-

合成孔径雷达(synthetic aperture radar, SAR)具有全天时、全天候对地观测能力,针对广阔的海洋区域可以大范围地获取海面SAR图像,有效探测海面船只,对我国海洋事业起着至关重要的作用。但是SAR图像在视觉上是灰度图像,目标纹理特征不明显,导致基于SAR图像的目标信息提取困难。同时,由于SAR相干成像的特点,近岸区域中存在的各类金属建筑会产生与船只特征相近的强散射点,仅靠人工进行目标检测难度很高,效率较低,容易产生误检现象,且船只目标具有不定朝向、密集排列特点,易产生漏检现象,因此近岸区域下的SAR图像船只检测是一个具有挑战性的问题。

传统的SAR图像船只目标检测方法多采用恒虚警率法,其依赖于人工建模,通过设计海杂波模型提取船只特征,无法有效区分船只与岛屿、近岸建筑等虚警目标,因此在背景复杂的近岸情形下效果不佳[1]。随着深度学习技术的不断发展,其在SAR图像目标检测方面的应用具有良好的发展前景,目前基于深度学习方法进行SAR船只检测大体分为两个技术路线,前者对以YOLO[2]和SSD[3]为代表的单阶段目标检测算法进行适应性改进,以实现实时高效船只检测。如文献[4]针对船只在近岸场景下方向多变问题,对YOLOv3算法进行改进,结合水平框和旋转框的预测结果实现船只目标方位角估计,提升了YOLOv3算法在复杂场景下的船只检测效果。文献[5]针对单阶段目标检测算法在复杂场景下船只检测性能不佳问题,在YOLOv3上引入了通道注意力机制,通过加强各网络层通道间的特征融合,提高模型在近岸场景下的检测性能。后者以Faster R-CNN[6]为代表的双阶段目标检测算法进行适应性改进,以实现高精度船只目标检测,如文献[7]通过多尺度特征融合与特征通道校准方法,提高Faster-RCNN算法在复杂场景下的船只目标检测性能。

单阶段目标检测算法由于缺少了双阶段算法的精细处理,在面对SAR图像中尺度大小不一、视觉特征不明显的船只目标时表现不佳。另外,单阶段目标检测算法YOLOv3作为Anchor Based算法虽然在一定程度上缓解了双阶段目标检测算法,如在Faster R-CNN中选择性搜索带来的候选框计算量爆炸的问题,但其每个网格中不同尺寸锚框的生成依赖于人工参数设置,目标的定位精度严重依赖于手动调参。同时为兼顾目标检测实时处理平台资源功耗受限等情形,需要避免主流算法模型参数量大、网络推理耗时长的问题。

针对以上问题,本文提出了一种基于改进YOLOX的SAR近岸区域密集船只高精度检测方法,有效地解决SAR近岸情形下算法模型准确率低、虚警率高且参数冗余问题,主要创新点如下:

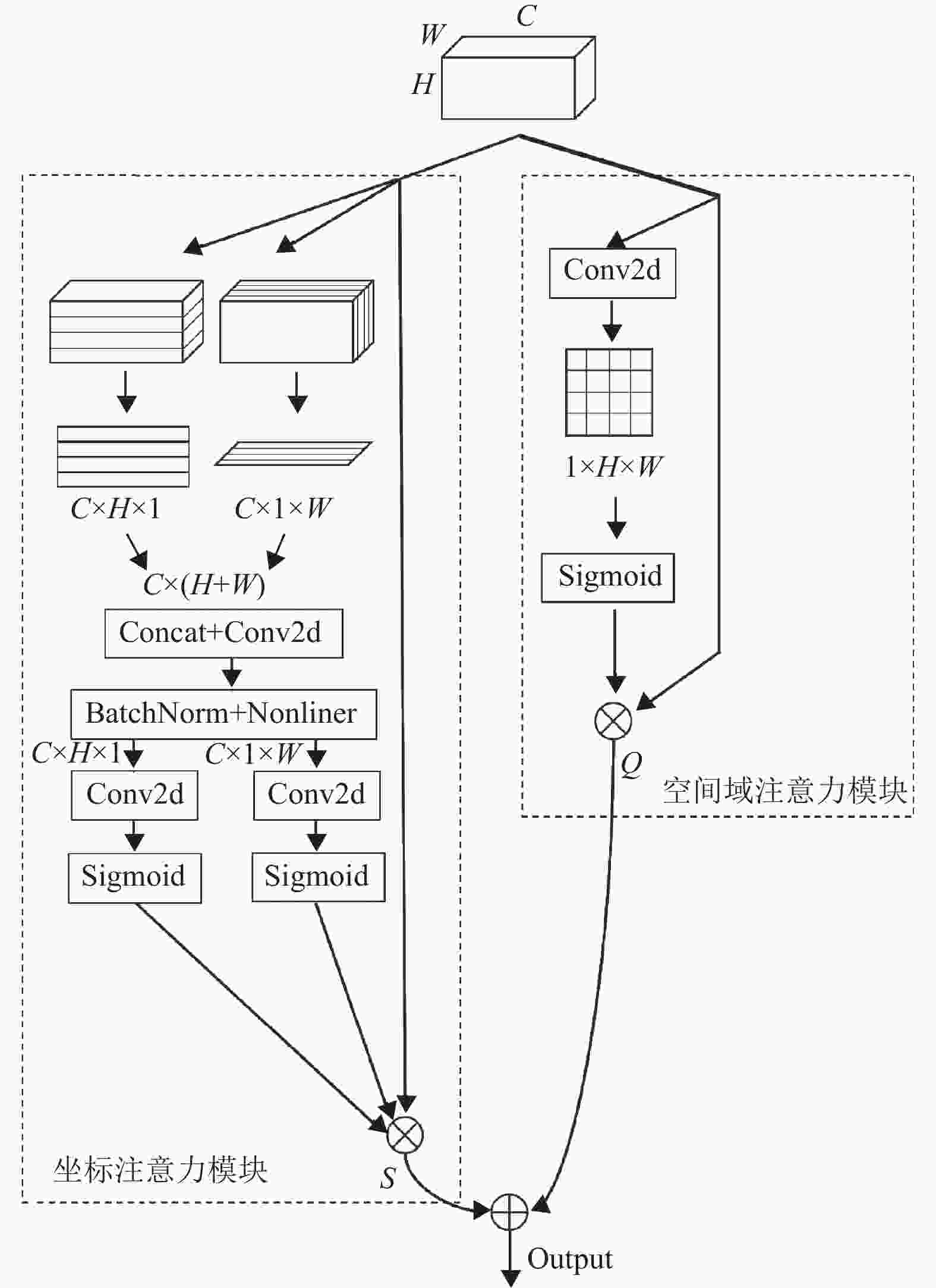

1) 改进坐标注意力机制,进一步提升对空间域信息的学习,并引入至特征提取网络,提升网络对船只目标信息的聚焦,实现目标信息的有效提取;

2) 采用旋转目标框进行目标检测,增加角度分类头学习目标的角度信息,并通过将旋转目标框转化为二维高斯分布的方法,计算预测分布与目标分布的KL散度作为旋转框损失值训练网络,提升网络在近岸区域下的检测精度;

3) 基于YOLOX的Anchor Free机制,结合上述两点设计,有效减少由于角度分类头导致的冗余候选框激增问题,避免冗余框带来的无效计算。

-

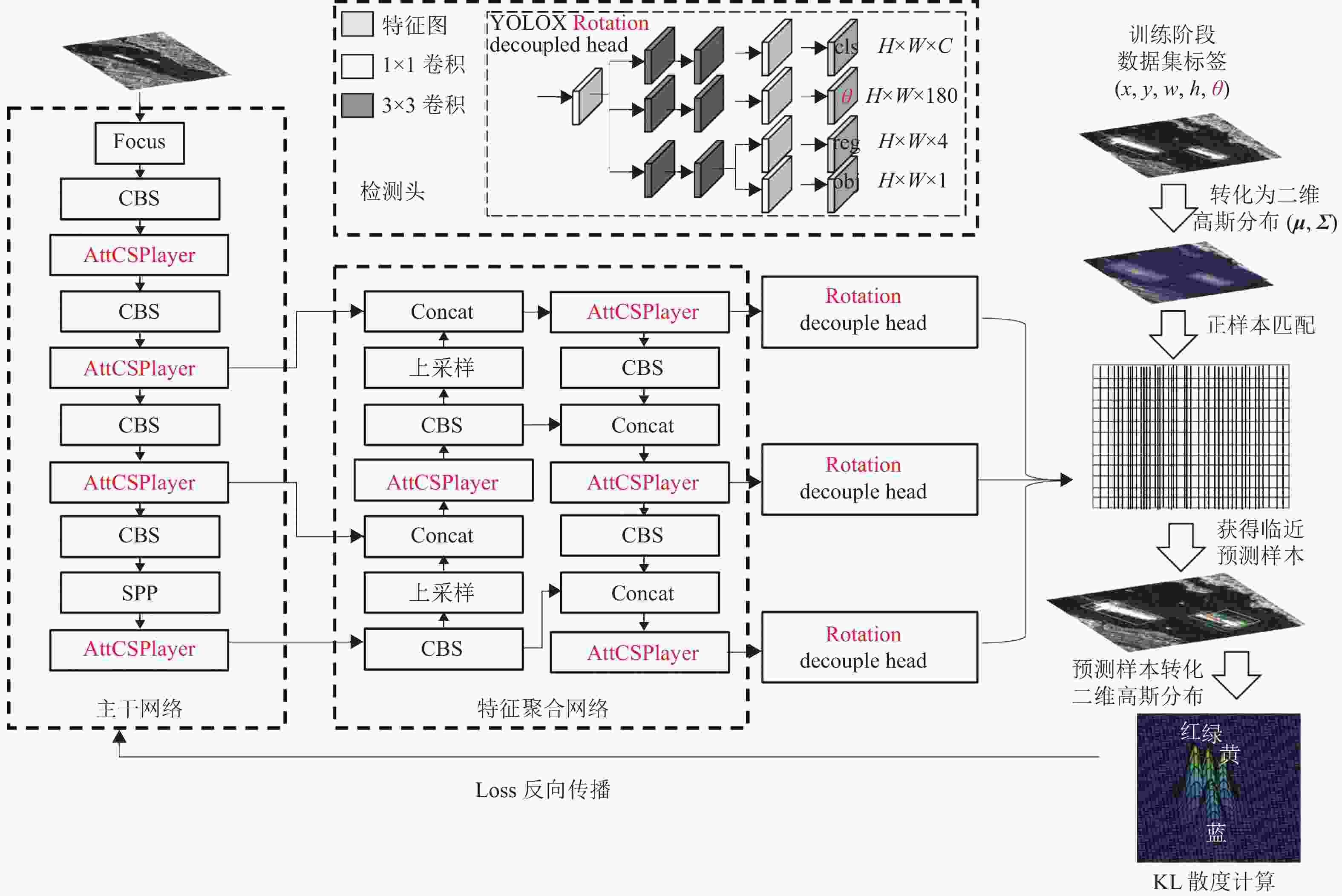

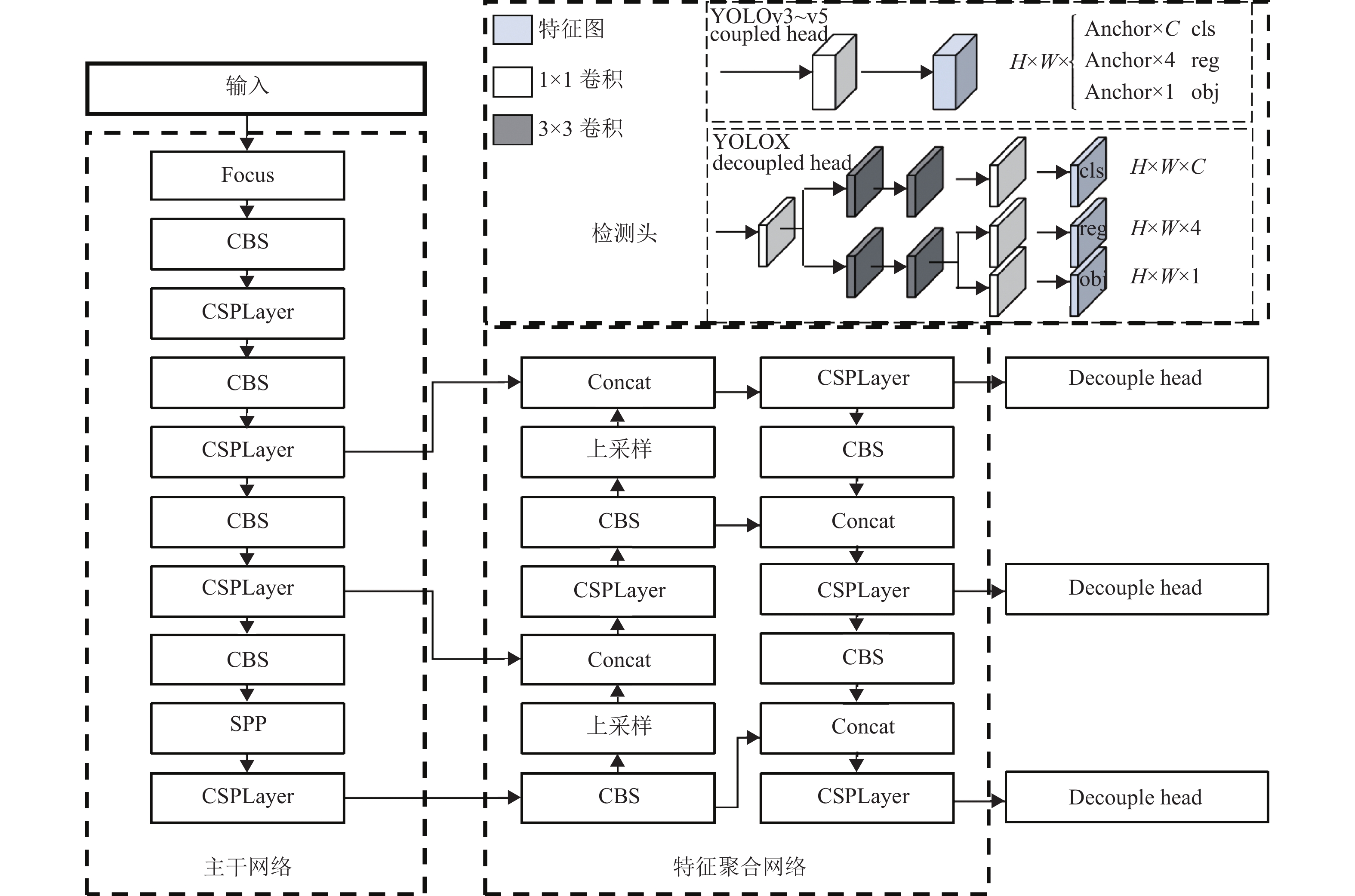

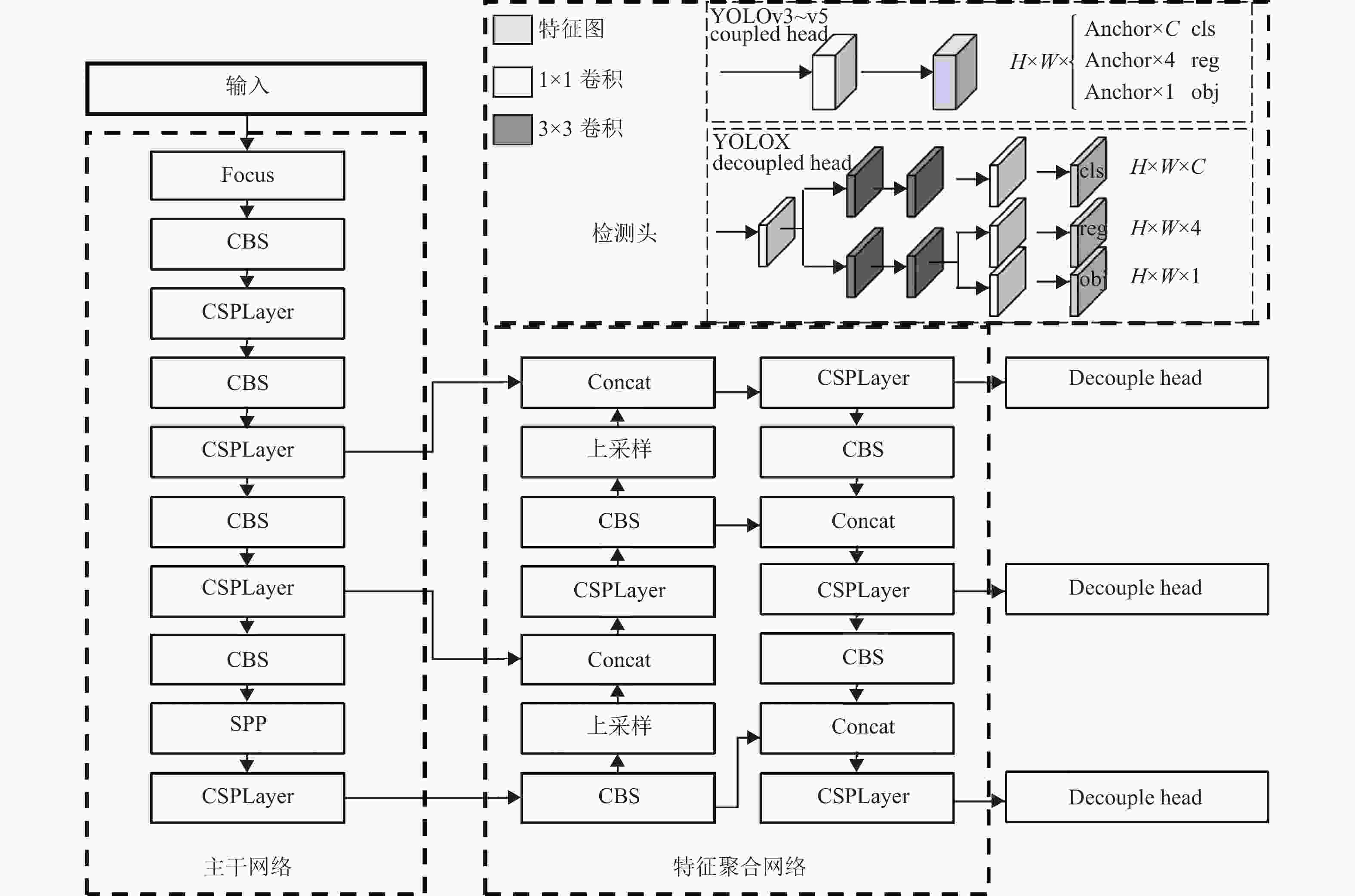

当前最新提出的YOLO系列算法中效果最优的单阶段目标检测算法YOLOX[8],其大致分为3个组成部分:主干网络、特征聚合网络与检测头。主干网络采用CSPDarknet来对图像进行特征提取,其主要组成部分CBS由卷积(convolution)、批量归一化(batch-normalization, BN)和激活函数(silu)组成,YOLOX在主干网络前通过采用Focus模块将输入的高分辨率图像拆分成多个低分辨率的特征图,以减少传统下采样操作产生的信息损失,而在主干网络提取特征后通过空间金字塔池化层(spatial pyramid pooling, SPP)来提取不同尺寸的空间特征信息,提升模型对不同尺寸目标的鲁棒性。此外,主干网络中的CSPLayer通过其残差结构可以将特征图的梯度变化集成到了最后的输出中,减少网络参数与运算量,并同样用于特征聚合网络PAFPN中以加强网络特征聚合能力,是目标特征提取的关键网络。

而YOLOX检测头采用Decoupled Head对提取的特征进行解耦,使回归与分类任务分成两部分,cls特征图负责学习目标的类别信息,reg与obj特征图则负责学习目标的位置及存在信息,以有效提高网络的检测精度,实现高精度的船只目标检测。最后在预测端将不同尺度的特征向量进行融合,通过SimOTA方法对融合的特征向量进行正样本筛选匹配,得到与真实样本近似的预测候选框,以消除先前YOLO系列检测算法中对先验Anchor设置的依赖,减少冗余候选框造成的无意义计算资源消耗,其网络结构如图1所示。

-

CSPDarknet主干网络的设计能够有效提取船只目标的细节信息,但设有对细节信息做出有效聚焦,忽略了能有效提升网络检测性能的目标空间结构信息与内部通道信息。因此引入注意力模块对原有网络结构进行改进,目前主流注意力机制模块有SE[9]、CBAM[10]、CA[11]等,其中模块CA作为通道域的最新进展,对输入的特征图沿水平坐标与垂直坐标方向进行平均池化以对每个通道进行编码,此步骤相较于SE通道注意力模块而言对不同方向的空间信息进行了筛选,以嵌入到通道信息中,实现了空间信息的引入。进一步地,坐标注意力机制采用1*1卷积进行通道信息学习,该步骤结合了ECANet注意力机制[12]的思想,采用1*1卷积替代了原SE通道注意力模块中的全连接层,以提升注意力模块的运行效率与精度,但该模块对空间域信息特征的利用仍不够全面。因此,本文结合BAM注意力模块[13]的构造思想,将坐标注意力模块加以改进并引入到特征提取网络中,学习目标空间结构信息与通道信息,引导神经网络更有效地提取目标特征,提高网络对SAR图像船只目标的特征表达能力,实现近岸船只目标信息的有效提取,改进后的坐标注意力模块如图2所示。

改进后的坐标注意力模块BCA通过结合空间域信息学习模块分支对输入维度为C×H×W的特征图m进行空间域与通道域的特征聚焦,原坐标注意力机制作为通道分支沿水平坐标与垂直坐标方向进行尺寸为(H,1)和(1,W)的平均池化,对每个通道进行编码,得到两个一维向量,当高度为h时,向量第c个通道的输出如式(1)所示;当宽度为w时,第c个通道的输出如式(2)所示。

$$ {\boldsymbol{z}}_c^h\left( h \right) = \frac{1}{W}\sum\limits_{0 \leqslant i < W} {{m_c}\left( {h,i} \right)} $$ (1) $$ {\boldsymbol{z}}_c^w\left( w \right) = \frac{1}{H}\sum\limits_{0 \leqslant i < H} {{m_c}\left( {j,w} \right)} $$ (2) 两个一维向量沿着空间维度进行特征聚合压缩通道,而后级联生成两个特征图nh和nw,用大小为1的卷积核进行卷积,如式(3)所示,生成水平方向与垂直方向的空间信息特征图t;再沿空间维度将特征图t分成两个单张量th和tw,利用两个大小为1的卷积对张量进行卷积,如式(4)和式(5)所示,得到与输入特征图同样的通道数;最后将经过激活函数运算后的值作为通道域注意力权重,与输入特征图相乘,得到权值调整后的特征图S如式(6)所示,实现对特征图通道域信息的加强。

$$ t = {\text{δ}} \left( {{F_1}\left( {\left[ {{n^h},{n^w}} \right]} \right)} \right) $$ (3) $$ {g^h} = {\text{σ}} ( {{F_h}( {{t^h}} )} ) $$ (4) $$ {g^w} = {\text{σ}} \left( {{F_w}\left( {{t^w}} \right)} \right) $$ (5) $$ {S_c}\left( {i,j} \right) = {m_c}\left( {i,j} \right) \times g_c^h\left( i \right) \times g_c^w\left( j \right) $$ (6) 式中,δ为卷积运算;σ为sigmoid激活函数运算。

空间分支则通过引入1×1卷积将输入维度为C×H×W的特征图m进行通道挤压,变化为1×H×W的空间特征图,再将经过激活函数运算后的值作为空间域注意力权重,与输入特征图进行相乘得到权值调整后的特征图Q,实现对特征图空间域信息的加强。最终将通道分支输出的加强特征图S与空间分支输出的加强特征图Q进行相加,得到空间信息与通道信息融合的最终特征图。

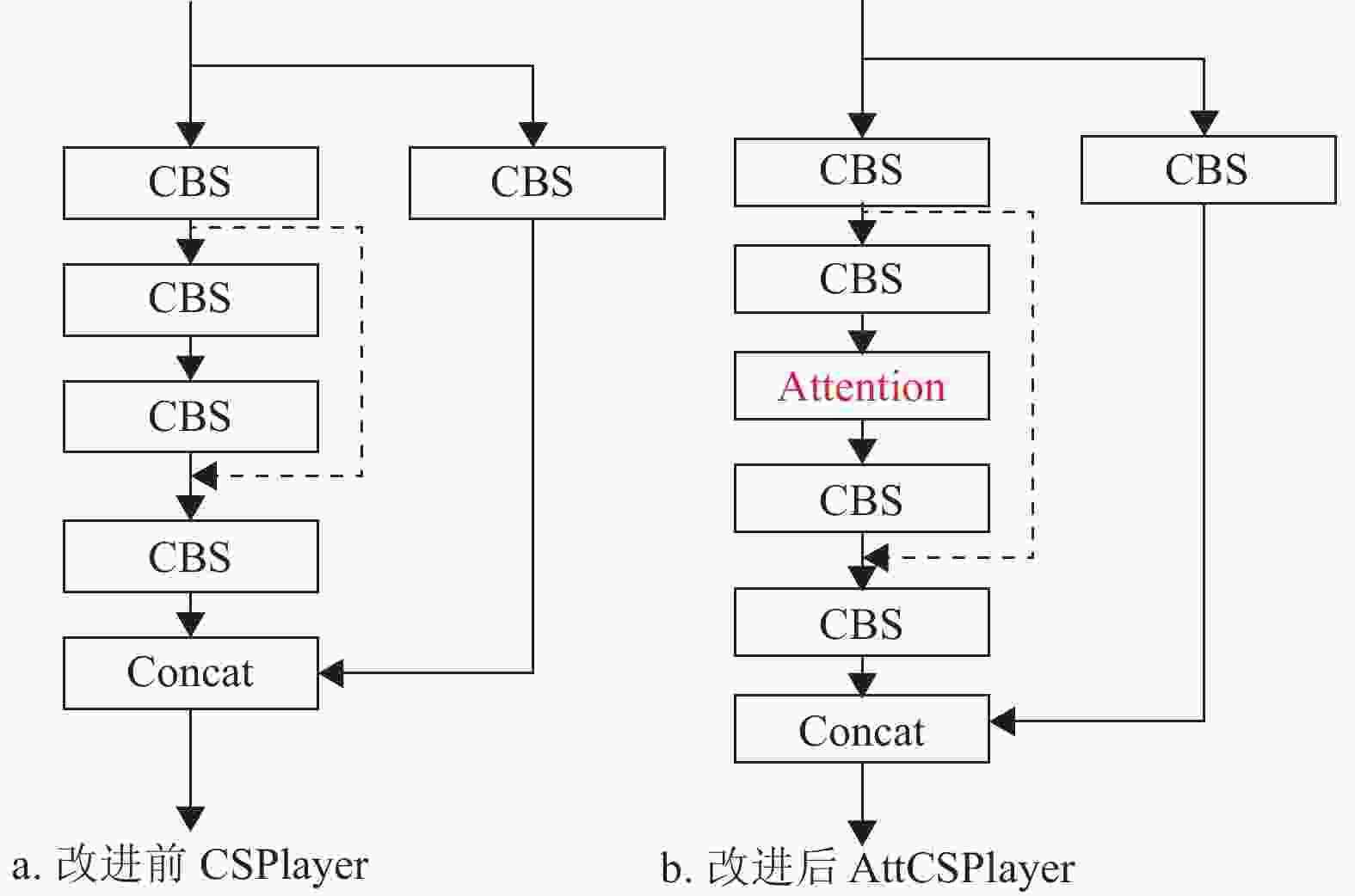

改进前后的特征提取网络AttCSPLayer如图3所示,在原始CSPLayer网络初步卷积提取产生的特征图后,将改进坐标注意力机制作用于输出的特征图中,根据通道域信息与空间域信息调整特征图的权重,再进行各层级特征融合提取。

-

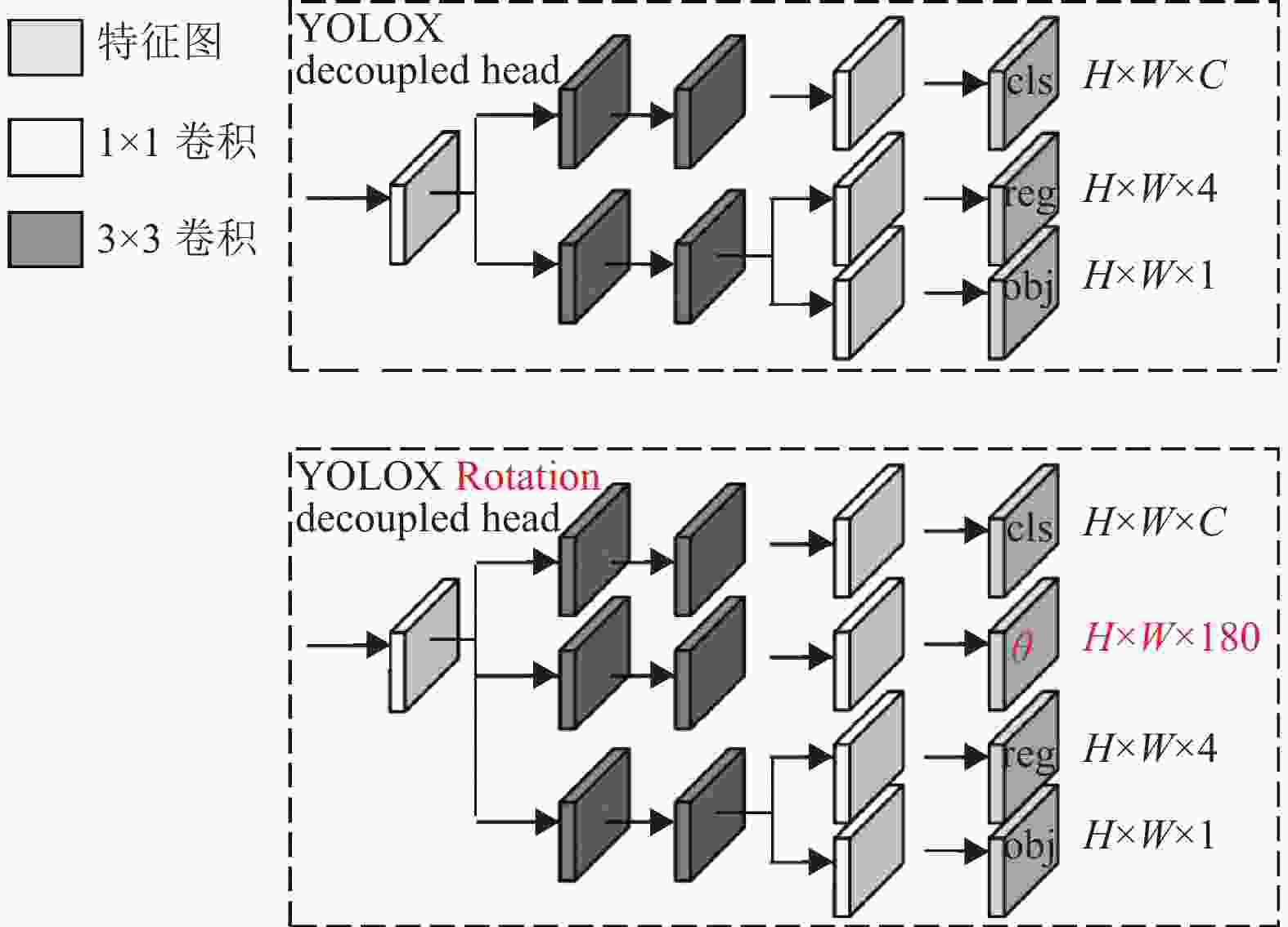

基于水平框的船只检测在近岸情形下表现不佳,且无法提供船只的方位角信息,不利于近岸船只调度任务进行。为此本文采用旋转目标框进行目标检测,增加角度分类头学习目标的角度信息,使检测头能同时输出船只目标位置与方位角估计信息,改进后的旋转检测头如图4所示。

图4中旋转检测头的reg特征图为目标的位置信息,其输出为(x, y, w, h),θ特征图为目标的角度信息,其输出为目标在0°~180°之间的概率,取最大概率的角度作为预测角度值,构成预测旋转目标框(x, y, w, h, θ),通过式(7)将旋转目标框(x, y, w, h, θ)转化为二维高斯分布(μ, Σ),以计算目标真实分布与模型预测分布之间的KL散度[14]作为损失值进行反向传播优化,其中KL散度计算公式如式(8)所示,特别地,设目标角度值为0,计算位置信息的损失梯度,可得式(9)。

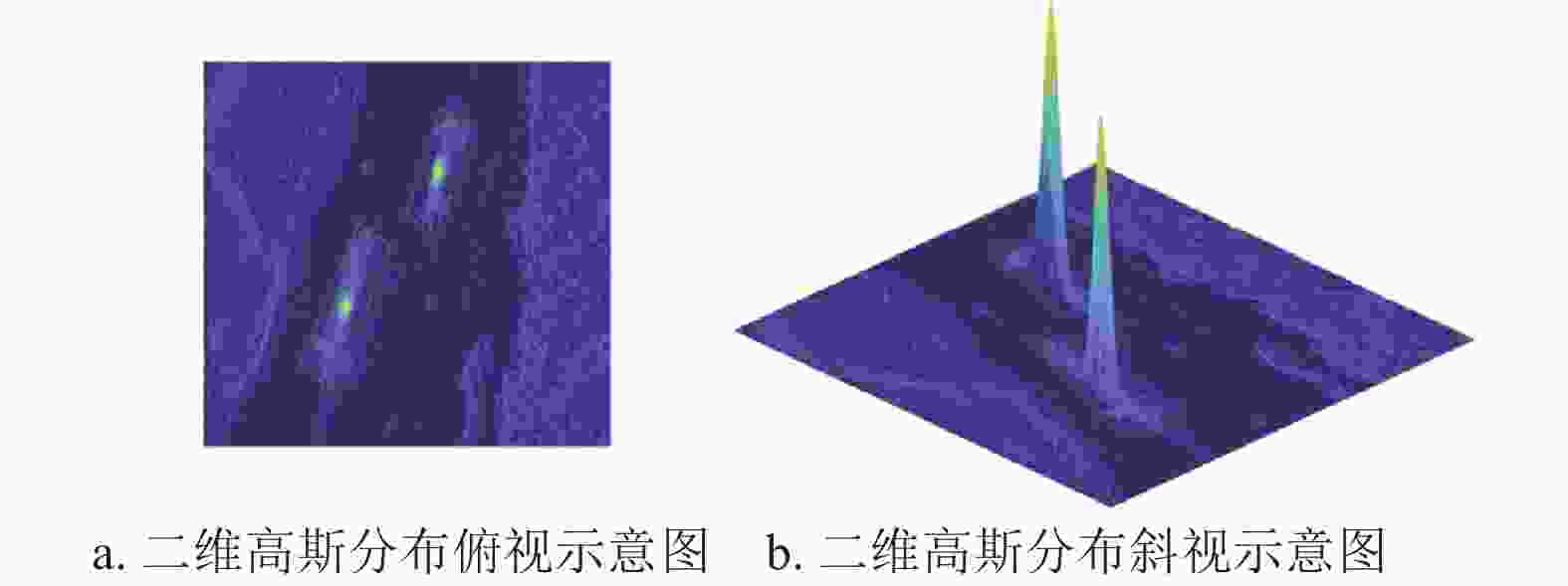

$$ \left\{ {\begin{array}{*{20}{l}} {{\boldsymbol{\mu }} = {{\left( {x,y} \right)}^{\text{T}}}} \\ \begin{gathered} {{\boldsymbol{\varSigma }}^{1/2}} = {\boldsymbol{R}}{\boldsymbol{\varLambda}} {{\boldsymbol{R}}^{\text{T}}} = \\ \left( {\begin{array}{*{20}{c}} {\cos \theta }&{ - \sin \theta } \\ {\sin \theta }&{\cos \theta } \end{array}} \right)\left( {\begin{array}{*{20}{c}} {\dfrac{w}{2}}&0 \\ 0&{\dfrac{h}{2}} \end{array}} \right)\left( {\begin{array}{*{20}{c}} {\cos \theta }&{\sin \theta } \\ { - \sin \theta }&{\cos \theta } \end{array}} \right) \\ \end{gathered} \end{array}} \right. $$ (7) $$ \begin{split} & {{{D}}_{{\text{kl}}}}( {{{ N}_{\text{p}}}\parallel {{ N}_{\text{t}}}} ) = \frac{1}{2}{({{\boldsymbol{\mu }}_{\text{p}}} - {{\boldsymbol{\mu }}_{\text{t}}})^{\text{T}}}{\boldsymbol{\varSigma }}_{\text{t}}^{{{ - 1}}}({{\boldsymbol{\mu }}_{\text{p}}} - {{\boldsymbol{\mu }}_{\text{t}}}) + \\ &\qquad \frac{1}{2}{\text{Tr(}}{\boldsymbol{\varSigma }}_{\text{t}}^{{{ - 1}}}{{\boldsymbol{\varSigma }}_{\text{p}}}{\text{) + }}\frac{1}{2}\ln \frac{{\left| {{{\boldsymbol{\varSigma }}_{\text{t}}}} \right|}}{{\left| {{{\boldsymbol{\varSigma }}_{\text{p}}}} \right|}} - 1 \end{split} $$ (8) $$ \frac{{\partial {f_{{\text{kl}}}}( {{{\boldsymbol{\mu }}_{\text{p}}}} )}}{{\partial {{\boldsymbol{\mu }}_{\text{p}}}}} = \left( {\frac{4}{{w_{\text{t}}^{\text{2}}}}\Delta x,\frac{4}{{h_{\text{t}}^{\text{2}}}}\Delta y} \right) $$ (9) 式中,Dkl为两分布间的KL散度距离;Np代表模型预测旋转框转化的二维高斯分布;Nt代表真实数据旋转框转化的二维高斯分布;Tr为求矩阵的迹。目标旋转框转化为二维高斯分布的示意图如图5所示,通过式(7)将旋转目标框转化为二维高斯分布,每个目标框转化的高斯分布受目标的长宽与角度影响,大小形状不尽相同。由式(9)可知其梯度权重受1/w2和1/h2影响,使得模型可根据目标的尺度来动态调整权重,当目标尺度较小或纵横比较大时,模型通过反向传播学习损失,会增大相应方向的梯度,便于有效地进行位置偏移的优化,提高船只目标中心位置的定位精度。

-

引入改进坐标注意力机制与旋转目标框后的算法结构如图6所示,在原有YOLOX网络结构基础上,采用改进坐标注意力机制改进特征提取网络结构,提高网络对船只目标信息的聚焦;增加角度分类头学习目标的角度信息。在训练阶段读取数据集的目标旋转框信息(x, y, w, h, θ)并将其转化为二维高斯分布(μ, Σ),而后与旋转检测头输出的特征向量进行特征匹配,得到与目标分布相近的预测分布信息,通过计算预测分布与目标分布的KL散度作为旋转框损失值训练网络,使网络模型根据目标的尺度与角度来动态调整位置偏移权重,提升网络在近岸区域下对船只目标位置的定位精度,实现高精度的船只目标检测。

-

本文使用公开的offical-ssdd数据集[15],该数据集对近岸船只目标与远海船只目标进行了划分,并提供了经过二次校验后的船只目标精确标注,数据集样本采用C波段的Radarsat-2、Sentinel-1卫星以及X波段的TerrraSAR-X卫星的SAR图像的裁剪得到数据,共包含1 160张图像、2 587只船舶目标,其中928张图像、2 041只船舶作为训练集,232张图像、546只船舶作为测试集,平均每张图像有2.23个船只,包含5×4像素的小目标船只到384×251像素的大目标船只,涉及了大片远海区域和近岸区域目标,测试集共172只近岸区域船舶目标,374只远海区域船舶目标,背景多样。

实验采用Pytorch深度学习框架,基于CUDA11.4和cuDNN8.2.4加速训练,基于TensorRT部署推理,YOLOX根据不同的网络深度与宽度,由浅到深可以分为YOLOXnano、YOLOXtiny、YOLOXs和YOLOXm等多个模型,本文采用最轻量的模型YOLOXnano进行实验,在此基础上进行改进并与其原始网络对比,最后再跟其他一些改进方法进行测试对比。输入到模型的图像大小设为416×416,batch size大小为128,训练优化器采用Adam优化器更新网络参数,其中学习率(learning rate)和权值衰减(weight decay)参数设为0.001和0.000 5,旋转目标框损失函数采用KLD_Loss,损失权重为5,目标角度损失采用CSL_Loss[16],损失权重为0.1,置信度损失采用BCE_Loss,损失权重为1;计算机具体配置为 Intel® Xeon® E52640,2.40 GHz,显卡为2*P5000[Pascal Quadro],显存2×16 GB;部署平台选用嵌入式平台(NVIDIA Jetson AGX Xavier),显存32 GB;算法的训练和测试均在GPU加速下完成。

-

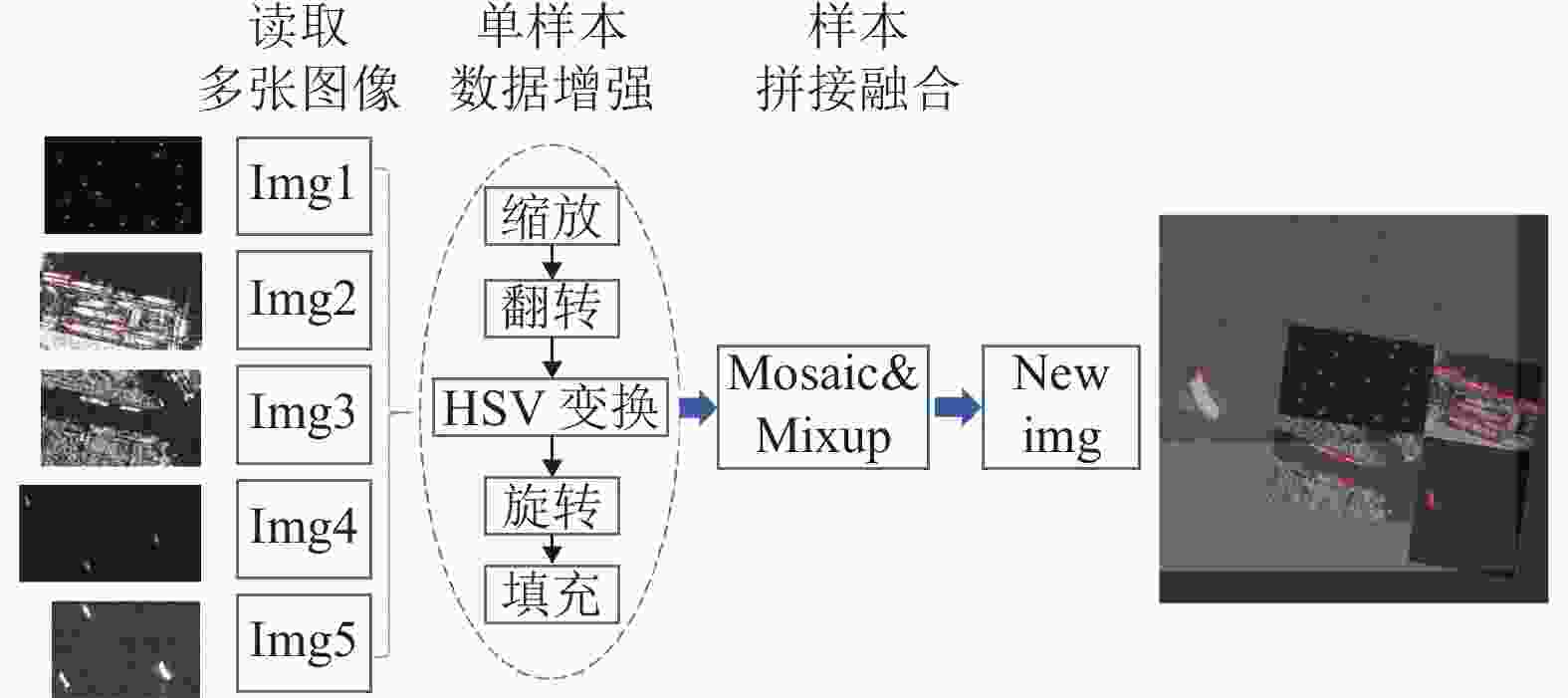

深度学习需要足够的训练样本作为支撑,相较于光学图像,SAR图像数据难以大量获取,为了充分利用有限的训练数据,加强模型泛化能力,抑制过拟合现象[17],本文通过随机缩放、随机旋转、mosaic拼接、mixup变化等方法对训练数据进行进行实时数据增强,效果如图7所示。

-

本文采用平均精度(average precision, AP)作为SAR图像船只检测模型性能的评价指标,计算式为:

$$ \left\{ \begin{array}{c} P=\dfrac{{\rm{TP}}}{{\rm{TP}}+{\rm{FP}}}=\dfrac{{\rm{TP}}}{所有检测结果}\\ R=\dfrac{{\rm{TP}}}{{\rm{TP}}+{\rm{FN}}}=\dfrac{{\rm{TP}}}{所有真实结果}\\ {\rm{AP}}={\displaystyle {\int }_{0}^{1}PR\text{d}R} \end{array} \right.$$ (10) 式中,TP为模型正确检测的船只目标数量;FP为误检船只目标数量;FN为漏检船只目标数量;精确率P表示正确检测的船只目标数量在全部检测结果中的比率;召回率R表示正确检测的船只目标数量占所有船只目标真实数量的比率。以P为纵轴,R为横轴,绘制出PR曲线,曲线与横坐标围成的面积为AP值,Ap50为交并比阈值设为0.5时的AP值。

利用本文算法在offical-ssdd数据集上进行检测,对采用不同改进方案的YOLOX检测算法结果进行对比,以检测精度Ap50作为算法检测精度性能指标,实验结果如表1所示。表中YOLOX为原始网络不加任何改进的检测结果;CA_YOLOX为引入了坐标注意力机制到特征提取网络中进行改进的YOLOX算法;BCA_YOLOX为引入了改进后坐标注意力机制到特征提取网络中进行改进的YOLOX算法;R_YOLOX为引入了旋转框方法到检测头中进行改进的YOLOX算法;本文方法则是结合了改进坐标注意力机制与旋转框的YOLOX算法。从表1可以看出,引入坐标注意力机制后算法模型的精确率有所提升,召回率差异减少,误检严重问题得到改善,引入改进坐标注意力机制后算法模型的精确率进一步提升。引入旋转框后算法模型在近岸区域的精确率有所提升,召回率基本保持一致,能更有效地定位出目标的正确位置。通过结合改进坐标注意力机制与旋转框方法,本文方法在近岸区域的检测精度高于其他算法,拥有更好的检测性能,在offical-ssdd数据集近岸区域检测的Ap50值相较于YOLOX算法提升了18.77%,引入注意力机制与旋转框方法都提高了近岸区域下船只目标的检测平均精度,同时引入改进坐标注意力机制与旋转框这两种改进方法后,网络的检测性能最好。

表 1 SAR船只检测结果评价指标

算法 近岸区域 远海区域 总计 P/% R/% Ap50/% P/% R/% Ap50/% Ap50/% YOLOX 0.6686 0.9127 0.6593 0.9582 0.9813 0.9792 0.8788 CA_YOLOX 0.8023 0.9262 0.7984 0.9920 0.9893 0.9907 0.9306 BCA_YOLOX 0.8547 0.8033 0.8262 0.9813 0.9601 0.9790 0.9351 R_YOLOX 0.7442 0.7485 0.7333 0.9413 0.9439 0.9374 0.8728 本文算法 0.8488 0.9799 0.8470 0.9893 0.9867 0.9870 0.9426 为验证本文所提检测网络的性能,在offical-ssdd数据集上完成本文方法与YOLOv3[18]、YOLOv5[19]和Faster R-CNN算法的对比实验,结果如表2所示。从表中可以看出,本文方法相较除YOLOX以外的其他算法,模型计算参数最少,总体测试检测精度最优,网络推理延时最低,且能获取船只目标方位角信息,满足实时处理需求。

表 2 不同算法检测性能对比

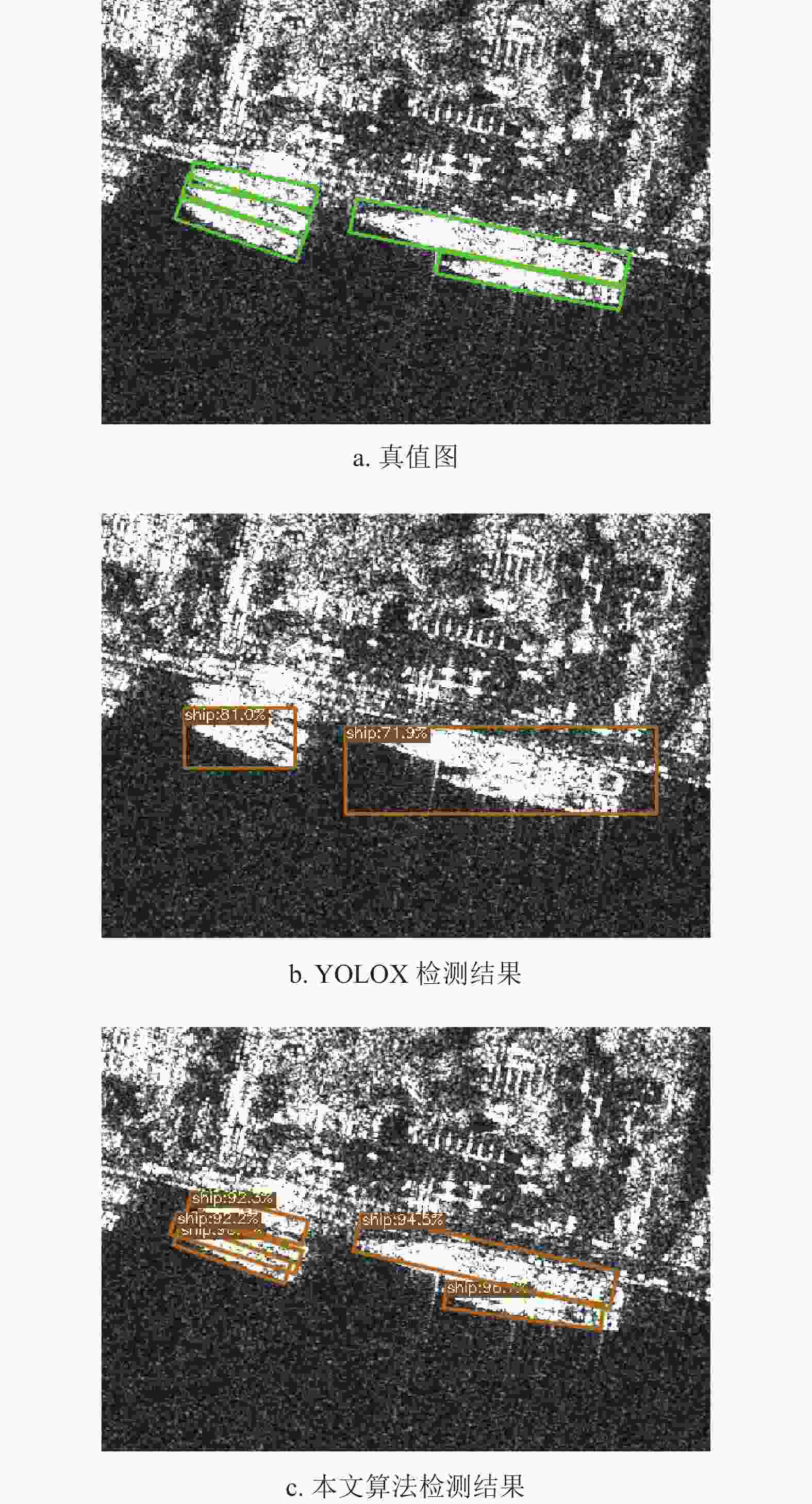

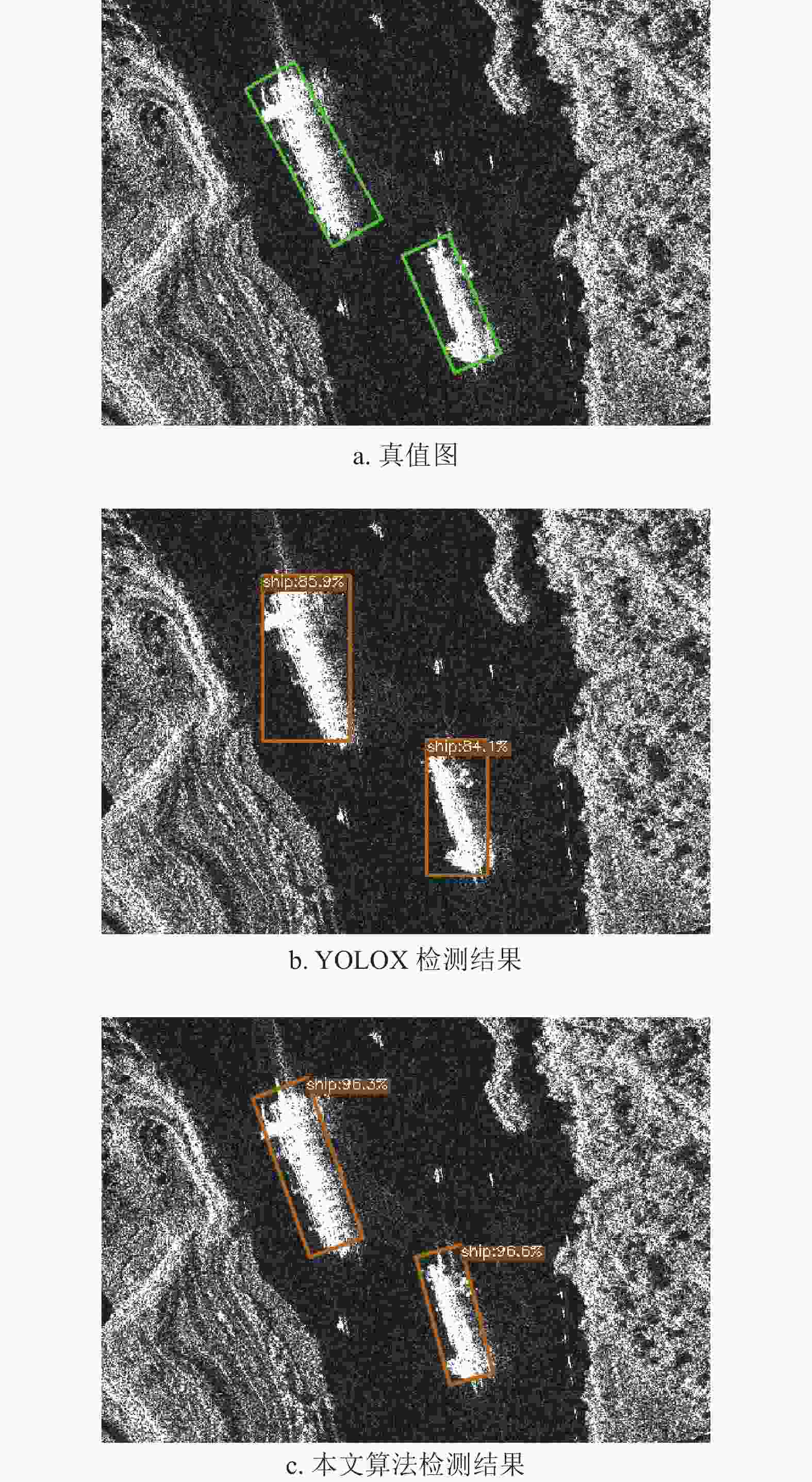

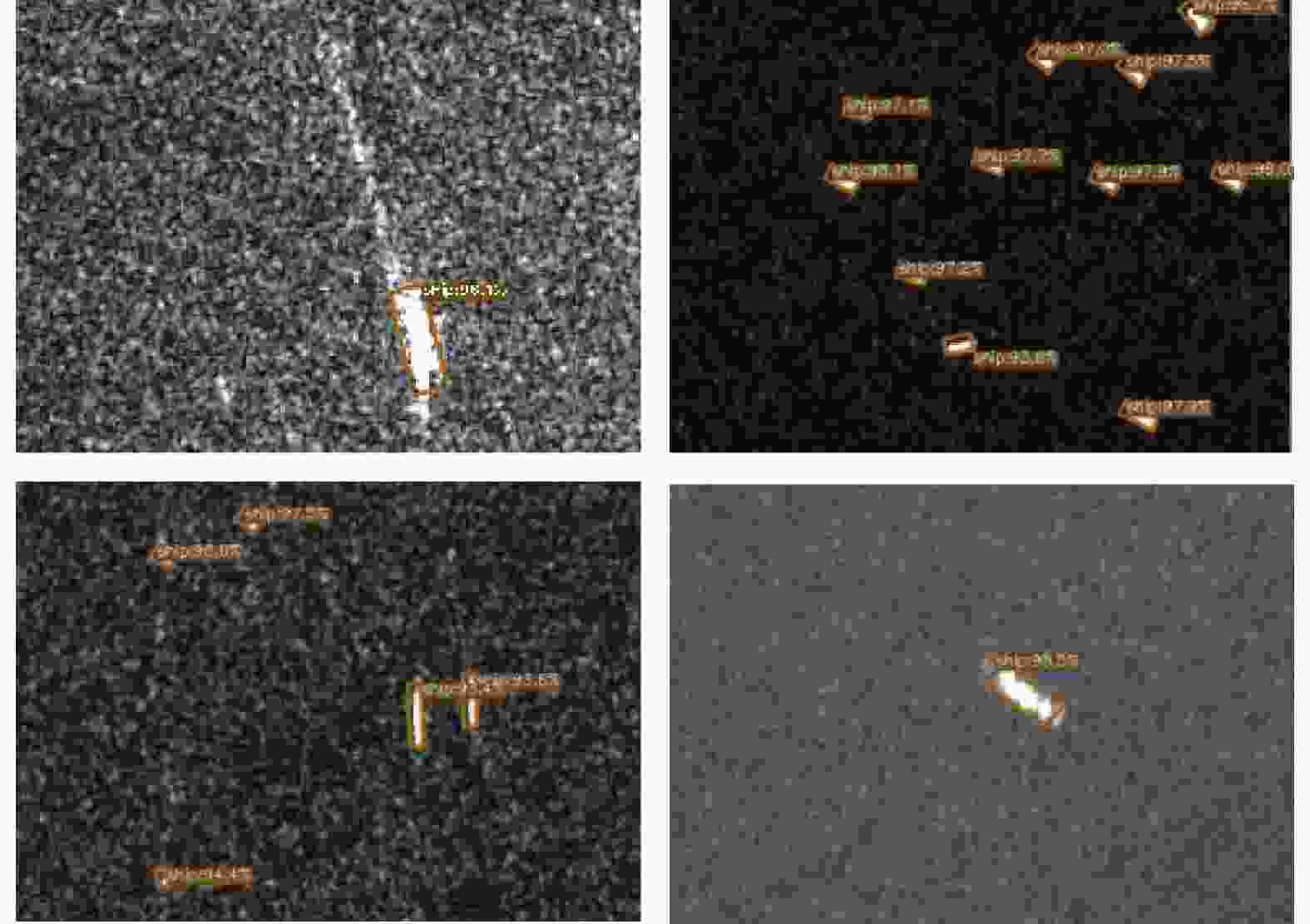

算法 参数量×106 Ap50/% 网络推理耗时/ms YOLOX 0.91 0.879 8 YOLOV3 36.3 0.871 28 YOLOV5 7.2 0.901 30 Faster RCNN 272.7 0.890 119 本文算法 1.14 0.942 10 本文实验检测结果如图8所示。对于紧密排列的邻岸大目标,传统YOLOX算法会出现漏检现象,或如图8b所示只输出一个大的目标框,而本文算法则能有效地检测并区分邻近排列的船只,如图8c所示。

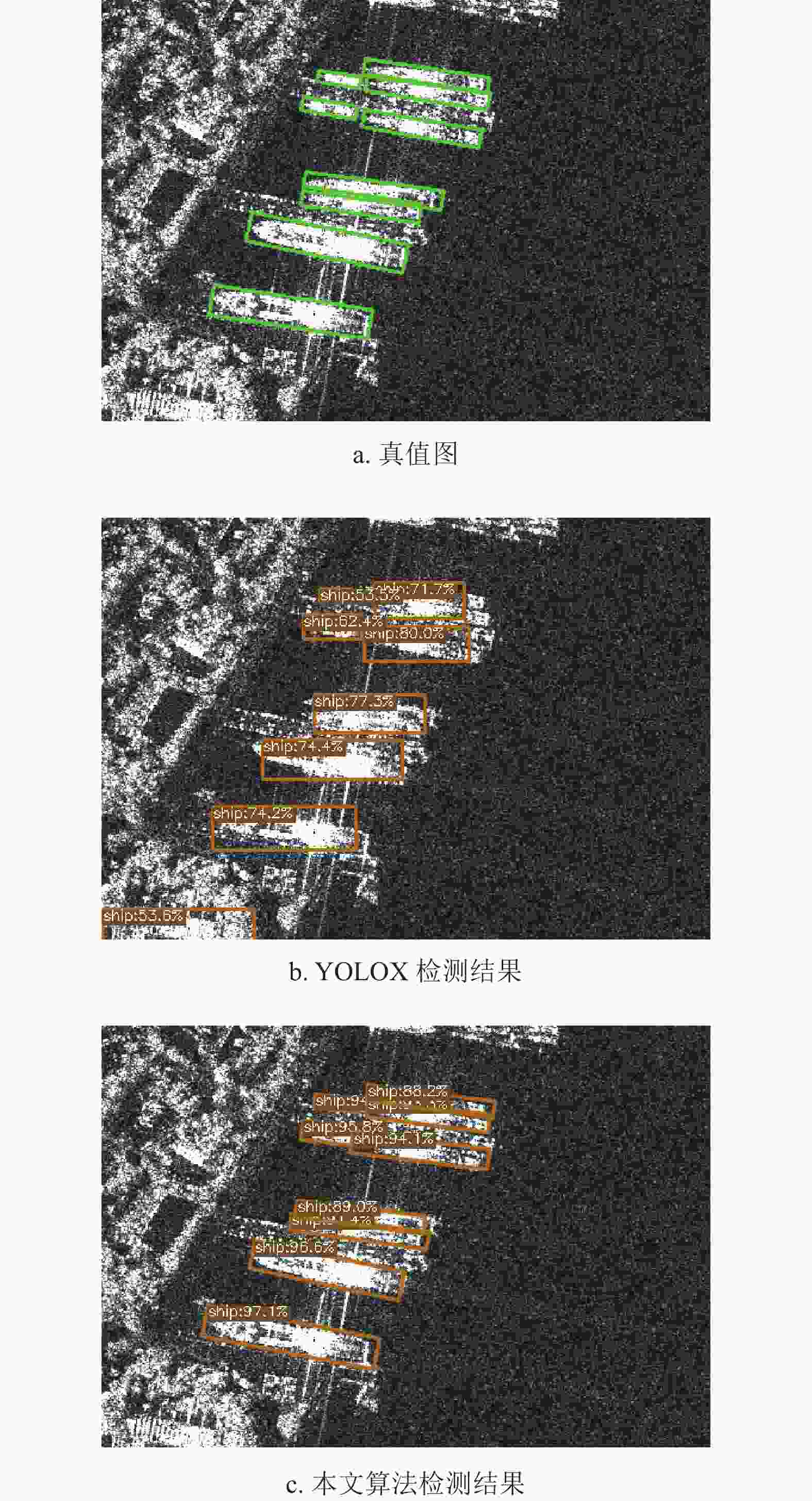

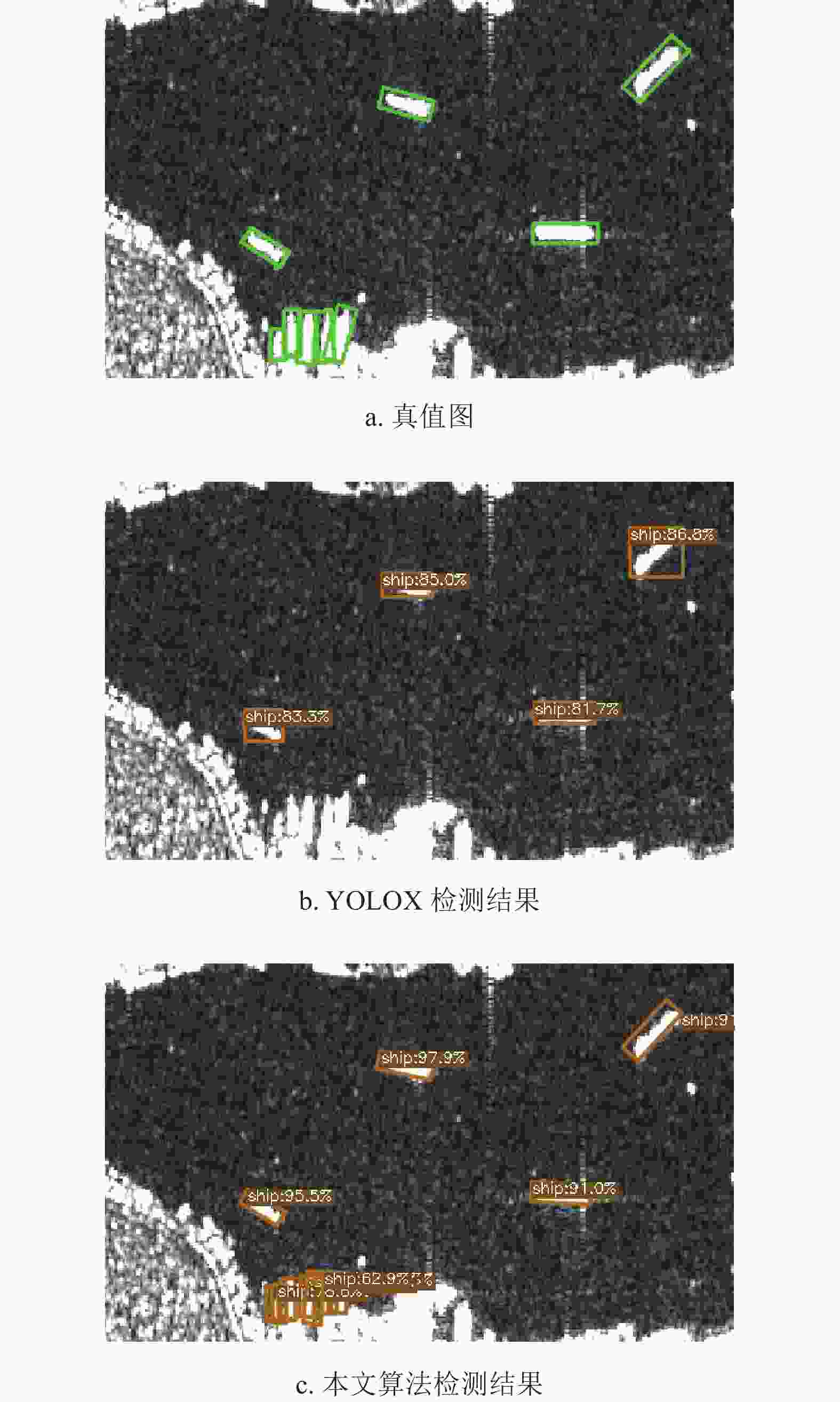

对于在港口中停靠的船只(图9a),采用传统YOLOX算法进行检测时,出现了误检与漏检现象,将陆地建筑误检为船只目标,对港口停靠紧密的船只则只输出一个较大的目标框,无法有效区分排列紧密的船只目标,如图9b所示。而本文方法则有效检测并区分各船只目标,没有错检现象,如图9c所示。

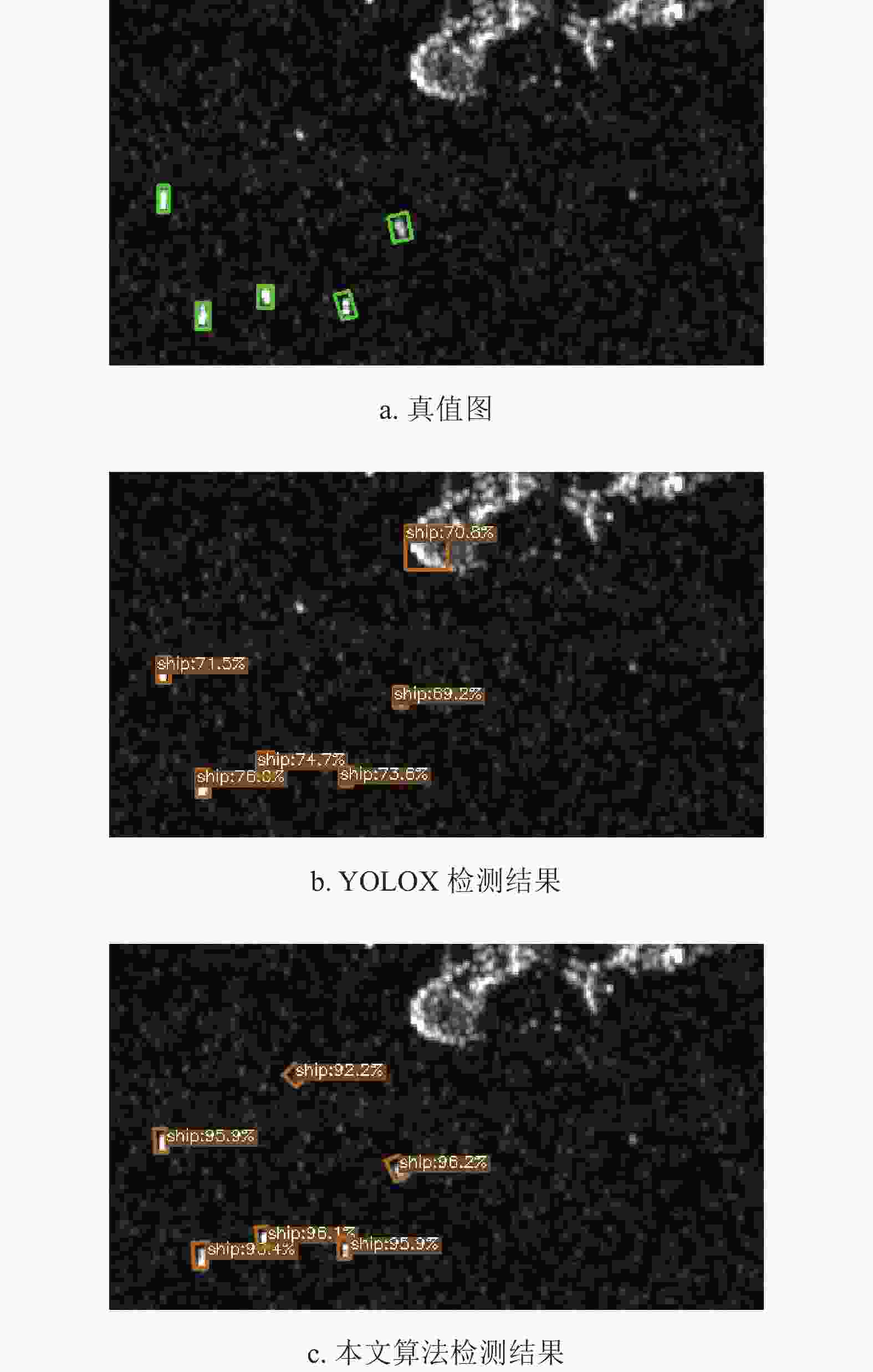

从图10可以看出,传统YOLOX算法采用水平框检测,船只越大水平框引入的背景信息越多,模型对大船只目标的关注度不够,导致输出预测框置信度较低。本文算法预测框置信度明显提升,且预测框可以更精确地涵盖目标区域,输出更精确的目标位置信息,检测更为准确。

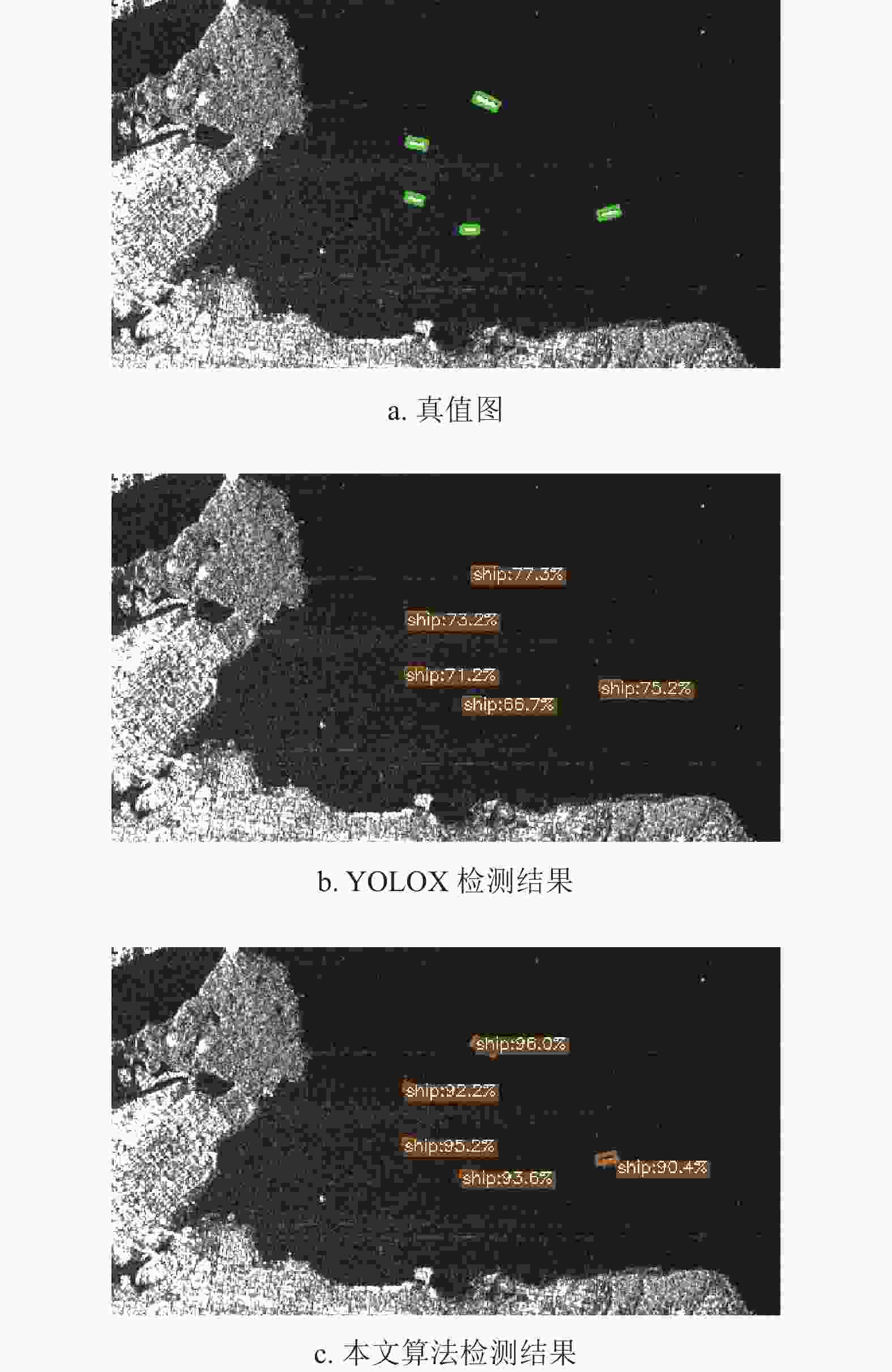

对于近岸小目标,传统YOLOX算法会出现漏检现象,如图11所示,难以检测出停靠在岸边的小目标船只。而本文方法则能对近岸小目标进行有效检测,但由于近岸场景下,近岸建筑产生的强散射点与临近的船只特征相近,在特征提取的过程中引入背景干扰信息过多,导致近岸区域小目标的检测置信度较低,仅在50%~60%之间。

在海岛周围区域,从图12可以看出,传统YOLOX算法将岛屿误检为船只目标,而本文方法则是将海面杂波散射点误检为船只目标。这是由于本文方法采用旋转框检测,对异于周围海面背景下的杂波散射点更为敏感,导致误检现象。而传统YOLOX采用水平框检测,在周围背景干扰下对海面杂波散射点的关注度降低,其对船只目标输出的预测框置信度也较低,在检测阈值设为0.5的情况下不会将杂波散射点视为船只目标,但会将区域亮度信息较为明显的岛屿错检为船只目标。

从图13也可以看出,本文方法对异于周围海面背景下的散射信息更为敏感,将海面杂波散射点误检为船只目标,而传统YOLOX算法对海面散射信息的关注度较低,因此未产生误检现象。在近海区域,本文方法预测框置信度较传统YOLOX算法有明显提升。

本文方法在远海场景不同海况情形下检测效果如图14所示,可以看到,对于不同海况情形下的远海场景目标,本文方法依旧可有效进行检测。综上所述,对于SAR船只目标检测任务,本文方法在近岸和远海场景下都能取得良好的效果,能够在复杂背景下识别船只目标,并且能更好地处理多尺度问题,得到更加精准的检测框。

-

本文提出了基于改进坐标注意力机制与旋转目标框的单阶段检测网络方法。在构建特征提取网络时加入改进坐标注意力机制准确提取感兴趣区域,同时选用旋转目标框获得船只方位角信息,提高检测精度。经offical-ssdd数据集实验验证,改进的YOLOX检测算法的检测精度在近岸情形下较YOLOX模型提升了18.77%,与主流YOLOv5检测算法相比,本文模型计算参数量减少了84.2%,推理耗时缩减至1/3,总体检测精度提升了4.1%,满足实时处理需求,验证了本方法的有效性。本文方法虽较基于水平框检测方法能得到更精准的目标框,但对SAR图像近岸场景中的大船只目标中心定位仍有待进一步提升。后续仍需进一步扩充数据集,优化网络结构,减小网络对近岸船只的定位偏移量。

Improved YOLOX SAR Near-Shore Area Ship Detection Method

-

摘要: 针对SAR近岸区域船只检测准确率低与虚警率高的问题,提出一种基于改进注意力机制与旋转框的SAR近岸区域船只检测方法。该方法首先通过改进坐标注意力机制并引入至特征提取网络中,提升网络的特征提取能力;其次,增加角度分类头,并引入二维高斯分布,计算预测分布与目标分布的KL散度评估旋转框损失值,完成目标的角度信息提取;再基于YOLOX算法中的无锚框(AF)机制,减少候选框冗余,使模型轻量化并进一步提高定位精度。最后在公开数据集offical-ssdd上进行测试,在嵌入式平台(NVIDIA Jetson AGX Xavier)上对模型进行推理验证。该算法模型计算参数仅1.14 M,在近岸情况下平均检测精度较YOLOX模型提高了18.77%,总体检测精度达到94.2%。验证结果表明,该算法适用于复杂场景下任意方向的密集船只目标检测,满足实时处理需求。Abstract: To solve the problem of low accuracy and high false alarm rate of synthetic aperture radar (SAR) nearshore area vessel detection, a new SAR nearshore area vessel detection method based on improved attention mechanism and rotating frame is proposed. Firstly, the feature extraction capability of the network was enhanced by improving the coordinate attention mechanism and introducing it into the feature extraction network. Secondly, the angle classification head was added and the two-dimensional Gaussian distribution was introduced to calculate the KL divergence between the prediction distribution and the target distribution, so as to evaluate the loss value of the rotating frame and complete the angle information extraction of the target. Then, based on the anchor frameless (AF) mechanism of YOLOX algorithm, the model can be made lightweight and the positioning accuracy can be further improved by reducing the redundancy of candidate frames. Finally, the model was tested on the open dataset Offical - SSDD, and the inference verification was performed on the embedded platform (NVIDIA Jetson AGX Xavier). The calculation parameter of the algorithm model is only 1.14M, and the average detection accuracy of the algorithm model is 18.77%, higher than that of the YOLOX model in the nearshore condition, and the overall detection accuracy reaches 94.2%. The verification results show that the algorithm is suitable for dense ship target detection in any direction in complex scenes and can meet the requirements of real-time processing.

-

Key words:

- improved coordinate-attention /

- inshore region /

- rotation anchor /

- SAR /

- ship detection

-

表 1 SAR船只检测结果评价指标

算法 近岸区域 远海区域 总计 P/% R/% Ap50/% P/% R/% Ap50/% Ap50/% YOLOX 0.6686 0.9127 0.6593 0.9582 0.9813 0.9792 0.8788 CA_YOLOX 0.8023 0.9262 0.7984 0.9920 0.9893 0.9907 0.9306 BCA_YOLOX 0.8547 0.8033 0.8262 0.9813 0.9601 0.9790 0.9351 R_YOLOX 0.7442 0.7485 0.7333 0.9413 0.9439 0.9374 0.8728 本文算法 0.8488 0.9799 0.8470 0.9893 0.9867 0.9870 0.9426 表 2 不同算法检测性能对比

算法 参数量×106 Ap50/% 网络推理耗时/ms YOLOX 0.91 0.879 8 YOLOV3 36.3 0.871 28 YOLOV5 7.2 0.901 30 Faster RCNN 272.7 0.890 119 本文算法 1.14 0.942 10 -

[1] 孙显, 王智睿, 孙元睿, 等. AIR-SARShip-1.0: 高分辨率SAR舰船检测数据集[J]. 雷达学报, 2019, 8(6): 852-862. doi: 10.12000/JR19097 SUN X, WANG Z R, SUN Y R, et al. AIR-SARShip-1.0: High-Resolution SAR ship detection dataset[J]. Journal of Radars, 2019, 8(6): 852-862. doi: 10.12000/JR19097 [2] REDMON J, DIVVALA S, GIRSHICK R, et al. You only look once: Unified, real-time object detection[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. [S.l.]: IEEE, 2016: 779-788. [3] LIU W, ANGUELOV D, ERHAN D, et al. SSD: Single shot MultiBox detector[C]//European Conference on Computer Vision. Cham: Springer, 2016: 21-37. [4] 徐英, 谷雨, 彭冬亮, 等. 面向合成孔径雷达图像任意方向舰船检测的改进YOLOv3模型[J]. 兵工学报, 2021, 42(8): 1698-1707. XU Y, GU Y, PENG D L, et al. Improved YOLOv3 model for ship detection of synthetic aperture radar images in any direction[J]Acta Armamentarii, 2021, 42(8): 1698-1707. [5] 杨杰. 基于深度学习的SAR舰船目标检测方法研究[D]. 秦皇岛: 燕山大学, 2021. YANG J. Research on SAR ship target detection method based on deep learning[D]. Qinhuangdao: Yanshan University, 2021. [6] REN S Q, HE K M, GIRSHICK R, et al. Faster R-CNN: Towards real-time object detection with region proposal networks[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2017, 39(6): 1137-1149. doi: 10.1109/TPAMI.2016.2577031 [7] 周雪珂, 刘畅, 周滨. 多尺度特征融合与特征通道关系校准的SAR图像船舶检测[J]. 雷达学报, 2021, 10(4): 531-543. doi: 10.12000/JR21021 ZHOU X K, LIU C, ZHOU B. Multi-Scale feature fusion and feature channel relationship calibration for SAR image ship detection[J]. Journal of Radars, 2021, 10(4): 531-543. doi: 10.12000/JR21021 [8] GE Z, LIU S T, WANG F, et al. YOLOX: Exceeding YOLO series in 2021[EB/OL]. (2021-08-06). https://arxiv.org/abs/2107.08430. [9] HU J, SHEN L, ALBANIE S, et al. Squeeze-and-Excitation Networks[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. [S.l.]: IEEE, 2018: 7132-7141. [10] WOO S, PARK J, LEE J Y, et al. CBAM: Convolutional Block Attention Module[C]//Proceedings of the European Conference on Computer Vision (ECCV). Munich: [s.n.], 2018: 3-19. [11] HOU Q B, ZHOU D Q, FENG J S. Coordinate attention for efficient mobile network design[C]//Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. [S.l.]: IEEE, 2021: 13713-13722. [12] WANG Q L, WU B G, ZHU P F, et al. ECA-Net: Efficient channel attention for deep convolutional neural networks[C]//Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. [S.l.]: IEEE, 2020: 11531-11539. [13] PARK J, WOO S, LEE J Y, et al. BAM: Bottleneck attention module[EB/OL]. [2022-01-23]. https://arxiv.org/abs/1807.06514. [14] YANG X, YANG X J, YANG J R, et al. Learning high-precision bounding box for rotated object detection via kullback-leibler divergence[J]. Advances in Neural Information Processing Systems, 2021, 34: 18381-18394. [15] ZHANG T W, ZHANG X L, LI J, et al. Sar ship detection dataset (ssdd): Official release and comprehensive data analysis[J]. Remote Sensing, 2021, 13(18): 3690. doi: 10.3390/rs13183690 [16] YANG X, YAN J C. Arbitrary-Oriented object detection with circular smooth label[C]//European Conference on Computer Vision. Cham: Springer, 2020: 677-694. [17] 阮晨, 郭浩, 安居白. 复杂背景下SAR近岸舰船检测[J]. 中国图象图形学报, 2021, 26(5): 1058-1066. RUAN C, GUO H, AN J B. SAR nearshore ship detection under complex background[J]. Journal of Image and Graphics, 2021, 26(5): 1058-1066. [18] REDMON J, FARHADI A. YOLOv3: An incremental improvement[EB/OL]. [2022-01-20]. https://arxiv.org/abs/1804.02767. [19] ZHU X K, LYU S C, XU W, et al. TPH-YOLOv5: Improved YOLOv5 based on transformer prediction head for object detection on drone-captured scenarios[C]//Proceedings of the IEEE/CVF International Conference on Computer Vision. [S.l.]: IEEE, 2021: 2778-2788. -

ISSN

ISSN

下载:

下载: