-

随着互联网和物联网的高速发展,手机、平板和电脑成了人们日常生活中必不可少的边缘智能计算设备[1]。通常,边缘智能计算场景包括智能医疗、智能家居、智能交通、智能教育等。边缘计算从云端计算延伸,在边缘部署地理分布的边缘网关网络,提供更接近物联网设备的计算能力。在传统的云端计算模式下,边缘智能终端直接将本地模型发送到云端进行计算处理,机器学习的集中训练模式可能会带来一些安全隐患,这种模式容易被攻击者拦截并发起隐私攻击[1-2]。此外,由于分布式用户数据具有多源特性、异质性等特点,集中处理会带来很大的资源开销和安全风险。边缘智能计算通过扩展边缘云端对中心云端进行补充,使得网络边缘能够满足计算和存储此类应用的要求[3]。

联邦学习是一种新型的分布式框架,与传统的集中式机器学习相比,具有更好的隐私保护功能。 它的原理是组合多个分布式设备,保护本地各种设备协调下的数据集,共享局部模型参数,可以获得更准确的机器学习模型来自训练和学习,从而实现数据的“可用隐身”。

-

联邦学习[4]是谷歌在2016年首次提出的分布式机器学习模式,目的是为了解决数据交换过程中存在的隐私泄露问题。传统的联邦学习系统是服务器和客户端模式,分为横向联邦学习、纵向联邦学习和联邦迁移学习,其中联邦迁移学习不对数据进行切分,利用迁移学习来克服标签不足的情况[5]。对比传统的机器学习,服务器将模型参数分配给不同的客户端,客户端只上传模型参数而不上传原始数据,从而可以将数据保存在本地,从一定程度上保护了用户隐私。

在现阶段的研究中,融合边缘智能计算和联邦学习的方案具有边缘化、分布式、资源动态性等特征,同时使隐私保护和合作共享成为可能。但是由于隐私攻击模型的出现,如梯度泄露攻击、重放攻击,使得模型的隐私性受到威胁。文献[6]指出,在智能家居中传感器与大量的用户隐私相关联,在数据的产生、传输、处理过程中都存在着隐私泄露的风险。文献[7]指出,车联网的部署在提供定位服务的同时也存在隐私泄露的风险。文献[8]通过将释放出的Netflix数据集与IMDb数据集进行关联就挖掘出了一部分用户的敏感信息,随后在推荐中对于数据的隐私保护方法进行了大量尝试,如匿名化、差分隐私、本地化的差分隐私、同态加密算法、安全多方计算等与推荐方法的结合;以及机器学习思想在推荐中的尝试,如对抗机器学习、对抗样本生成等,都在一定程度上保护了用户的隐私和安全。文献[8] 设计了一个安全聚合方案,在聚合期间使用户能够更新加权向量平均,消除用户间的致盲因子。文献[9] 基于协同学习设计了 GAN 攻击,使恶意用户加入训练过程并生成诚实的数据集用户。文献[10] 添加拉普拉斯噪声到神经网络中的梯度以满足差分隐私。尽管如此,文献[11]指出虽然添加梯度噪声可以保证隐私,但它的签名大大降低了模型的准确性。文献[12]提出了一种基于加法同态加密的协同学习系统。

-

设D和D'是相邻数据集,即只有一个样本不同。对于查询函数 f,如果满足式(1),则 f 满足差分隐私:

$$ \Pr [f(D) \in R] \le {e^\varepsilon }\Pr [f(D) \in R] + \delta $$ (1) 式中,

$\varepsilon $ 代表隐私度,$\varepsilon $ 越大代表数据可用性越高,越小代表隐私保护程度越高,相应地,添加的噪声越大,当$\varepsilon $ 为0时,代表没有添加差分隐私;$\delta $ 代表置信度参数,在严格差分隐私中,$\delta $ 为0,当$\delta > 0 $ 时,为近似差分隐私,在实际工业中,近似差分隐私被广泛使用。高斯机制:给定一个数据集 D和查询函数f,则提供差分隐私的机制 M满足:

$$ M(D) = f(D) + N(o,{\sigma ^2})$$ 式中,

$\sigma $ 代表标准差,需满足:$$ \sigma > \frac{{\sqrt {2\ln (1.25/\delta )} \Delta f}}{\varepsilon }$$ 式中,

$\Delta f $ 是数据集的敏感度;为相邻数据集的二范数。设u和v分别为不同边缘网关的 ID 号,则其密钥为

$ S\_\left(u,v\right)={\rm{KA}}.{\rm{agree}}\left({\rm{sSK}},{\rm{sPK}}\right) $ ,同维展开向量为$ {{\boldsymbol{P}}_{u,v}} = {\varDelta _{u,v}}*{\rm{PNG}}\left( {{S_{u,v}}} \right)\left( {u > v,{\varDelta _{u,v}} = 1;u < v,{\varDelta _{u,v}} = - 1} \right) $ 假设

${\varDelta _{{\rm{ansg}}}}$ 是联邦聚合梯度, U为边网关集,${\varDelta _{{\rm{yu}}}}$ 为边缘网关上传的参数,聚合规则如下:$$ {\varDelta }_{{\rm{ansg}}}=\displaystyle \sum _{u\in U}{\rm{yu}}=\displaystyle \sum _{u}\left( \begin{array}{l}{\varDelta }_{{\rm{yu}}}+\displaystyle \sum _{u\in u:u < v}{\rm{PRG}}\left({S}_{S,v}\right)-\\ \displaystyle \sum _{u\in u:u > v}{\rm{PRG}}\left({S}_{S,v}\right)\end{array} \right)=\displaystyle \sum _{u\in U}{\varDelta }_{{\rm{yu}}} $$ 假设在第t轮训练,之前r个边缘网关得到的共享模型训练为

${\theta _t}$ ,并且在${\theta _t}$ 上进行$\tau $ 次迭代。${\theta _{t,s}}$ 是第t轮训练、第s次迭代时边缘网关的本地模型。在每次迭代$s = 0,1, \cdots ,\theta - 1$ 时,边缘网关通过以下规则更新其模型:$ {\theta }_{\left(t,s+1\right) =}{\theta }_{\left(t,s\right)}-\eta g\left(\theta \left(t,s\right)\right) $ ,其中$ g\left(\theta \left(t,s\right)\right)=\dfrac{1}{B}{\displaystyle \sum _{\xi \in {X}_{i}}\nabla }l({\theta }_{i}^{t,s},\xi ) $ 表示基于从本地聚合数据集$ D_i $ 中采样的B个样本点$ X_i $ 计算的随机梯度。在第t轮训练中,共享模型的更新规则为:

$$ \theta = \frac{1}{r}\sum \limits \theta ,\;{\theta ^{t + 1}} = \frac{1}{r}\mathop \sum \limits_{i \in {{{\Omega }}_t}} \theta _i^{t,\tau }$$ 在第t轮训练中,传输的数据量为L,信道带宽为 B,因此传输时间为

$ {m_t} ={L /B} $ 。设 P 为第t轮训练的功率,那么产生的能量消耗为$ LP/B $ 。表1 描述了本文方案相关算法。

表 1 相关算法描述表

算法 含义 KA.param() 公共参数生成 KA.gen() 公私钥对生成算法 KA.agree() 私有共享密钥生成算法 SS.share() 秘密分享算法 SS.recon() 秘密重建算法 SIG.gen() 密钥生成算法 SIG.sign() 签名算法 SIG.ver() 验证算法 -

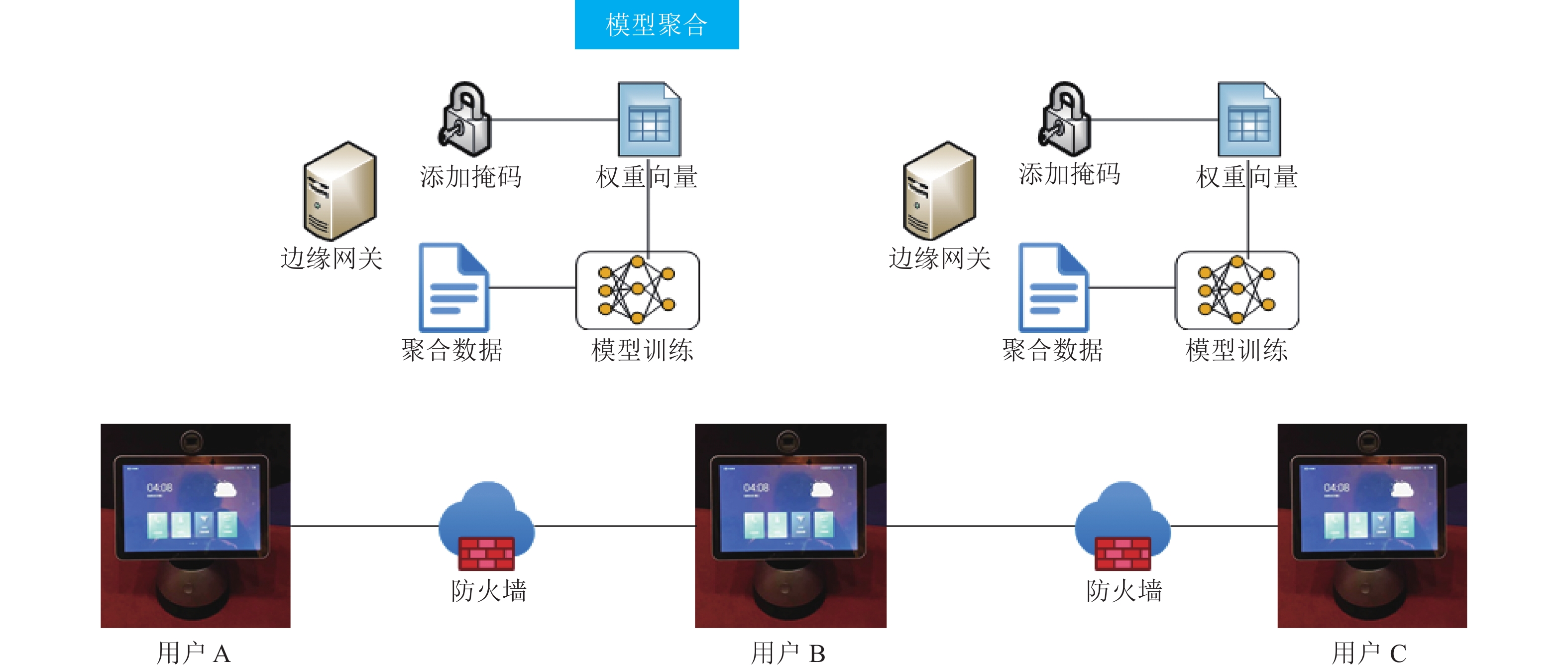

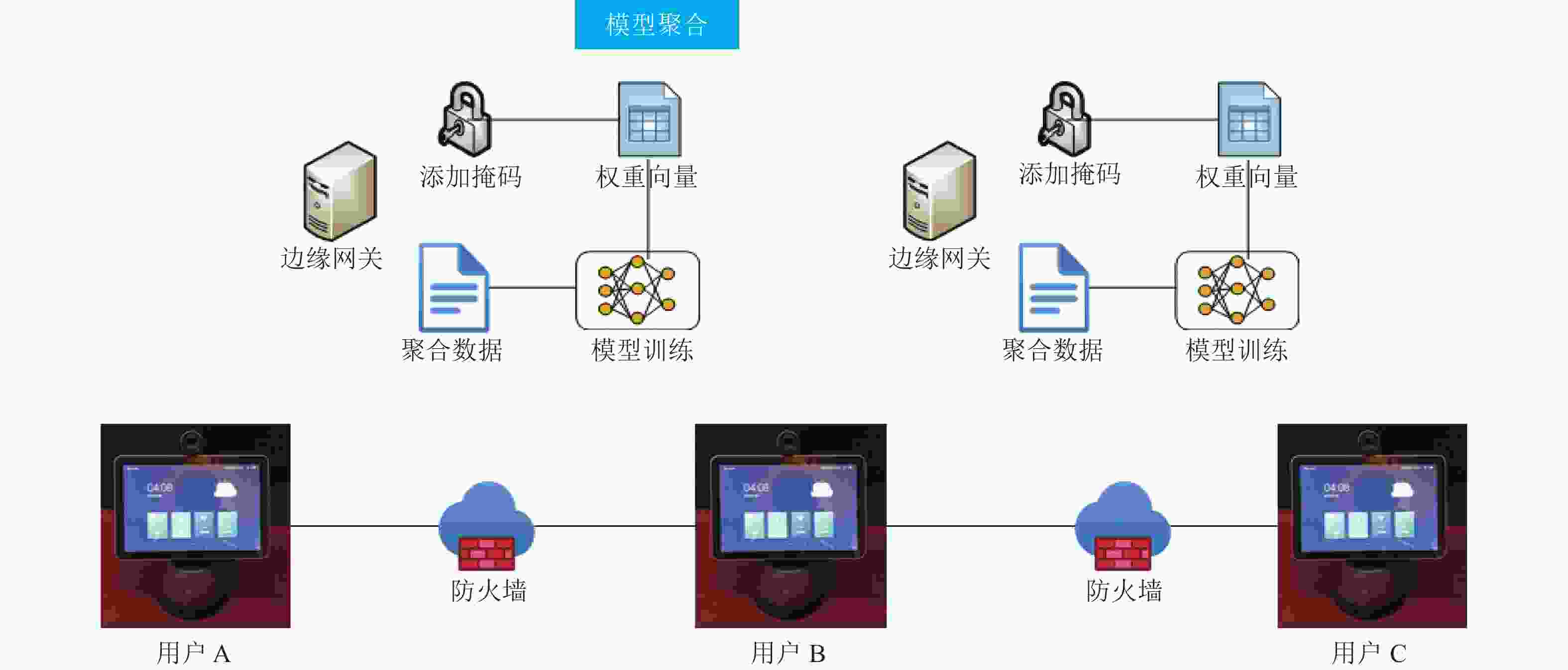

为了解决边缘计算场景下训练全局机器学习模型的隐私泄露问题,设计了一种使用安全多方计算框架的联邦学习系统。该系统包括一个云端和多个可以与之通信的边缘网关,且边缘网关和边缘智能终端可以相互通信。图1为该系统架构,系统中有3种实体。

1)边缘智能终端:作为联邦学习任务的参与者,有不同数量的数据集和不同的计算能力,它们的加密数据集旨在训练一个模型。

2)边缘网关:是边缘智能终端和云端的链接,具有更强的计算能力和更大的存储空间。它们从边缘智能终端收集加密数据并训练模型,并将训练好的模型参数发送到云端进行聚合。

3)云端:是本文方案中的参数服务器。负责分发初始训练模型、聚合和更新模型参数。

首先,边缘智能终端使用不同的本地数据隐私保护,然后上传到边缘网关进行数据聚合,边缘网关数据聚合后,对本地模型进行训练,并对模型进行PPCEF,然后上传到云端进行模型聚合,云端将模型聚合后,再下放到各边缘网关进行更新。

本文设计的PPCEF方案,首先使用基于DH密钥交换协议的KA.agree()函数使每个边缘网关使用私钥

$ {\text{sSK}} $ 与其他边缘网关公钥$ {\text{sPK}} $ 来协商一个密钥$ {S_{u,v}} $ ,使用该密钥作为随机数生成器种子$ {\text{PNG}}\left( {{S_{u,v}}} \right) $ 生成与模型梯度向量维数相同的扩展掩码$ {{\boldsymbol{p}}_{u,v}} = \displaystyle\sum {\varDelta _{u,v}}*{\text{PNG}}\left( {{S_{u,v}}} \right) $ (其中,u表示该网关ID,v表示其他所有网关ID),并且要求当u>v时,$ {\varDelta _{u,v}} = 1 $ ;当u<v时,$ {\varDelta _{u,v}} = - 1 $ 。同时,每个边缘网关使用秘密共享方案$ {\text{SS}}{\text{.share}}\left( {{\text{sSK}}} \right) $ ,并将每个秘密共享份额分发给其他边缘网关。以上过程就是添加个人掩码。为了防止云端直接获得聚合结果,每个边缘网关都需要使用PNG生成一个随机数$ {b_u} $ ,并将其扩展为相同维度的向量$ {{\boldsymbol{p}}_{u,{\rm{prav}}}} $ ,并分配到每个边缘网关。每个边缘网关计算$ {{\boldsymbol{p}}_{{\text{pub}}}} = \displaystyle\sum {{{\boldsymbol{p}}_{u,{\text{prav}}}}} $ 作为边缘网关的公共掩码。其次,如果每个边缘网关都参与训练,因为密钥交换协议使边缘网关u、v 协商了相同的

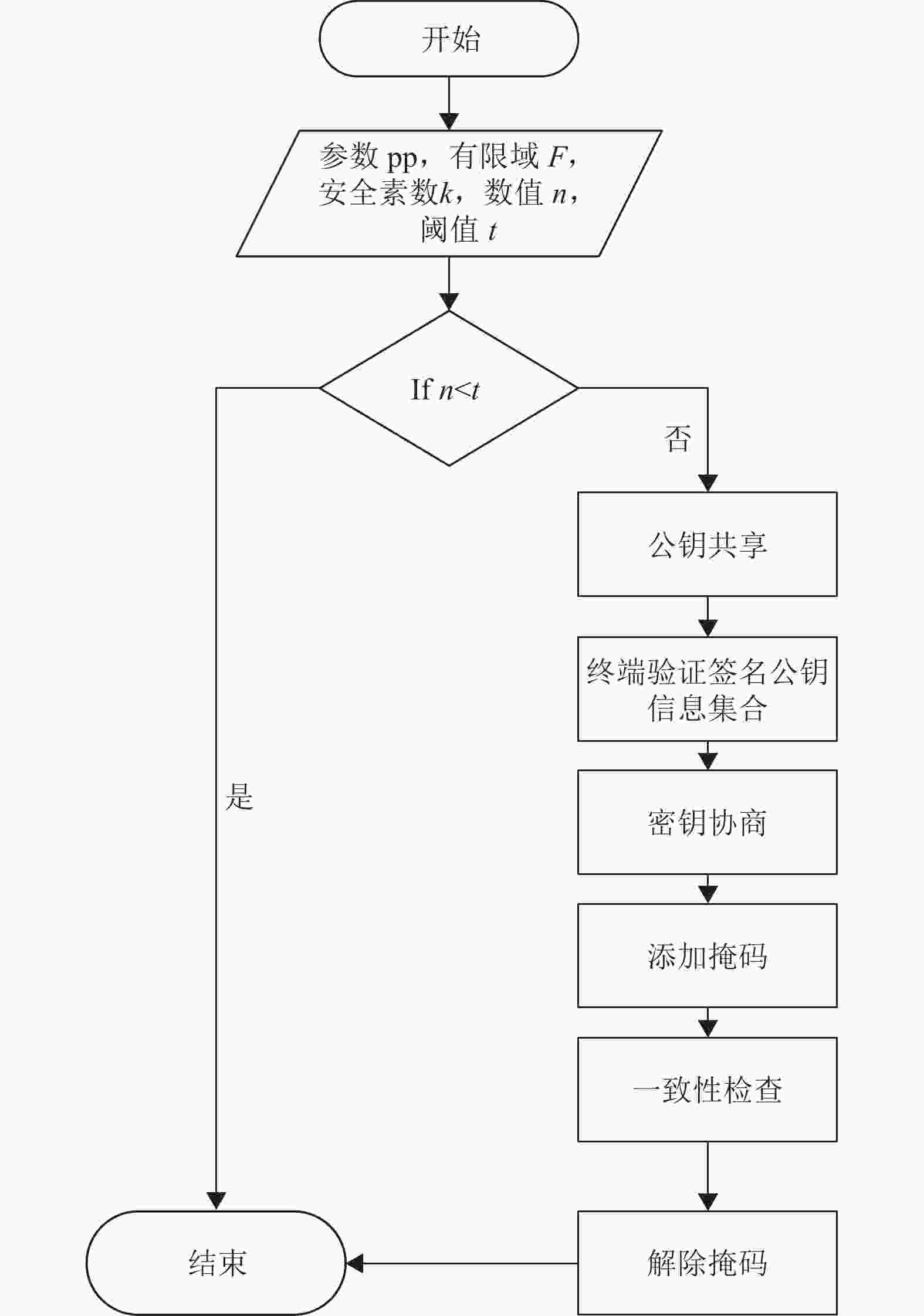

$ {S_{u,v}} $ ,且$ {\varDelta _{u,v}}*{\text{PNG}}\left( {{S_{u,v}}} \right) $ 。 当u>v时,$ {\varDelta _{u,v}} = 1 $ ;当u<v时,$ {\varDelta _{u,v}} = - 1 $ 。因此,云端聚合中所有个人掩码的总和为 0 向量;同时,云端可以收集掉线的边缘网关分发给其他边缘网关的私钥的秘密份额进行秘密重构$ \text{SS}\text{.recon}\left(\left\{{S}_{u,v}^{{\rm{SK}}}\right\}v\in U\right) $ (其中U为在线网关集合;u代表离线网关),恢复$ S_u^{{\rm{SK}}} $ ,云端通过$ S_u^{{\rm{SK}}} $ 、公开的公钥信息PNG和重构出掉线网关的$ {{\boldsymbol{p}}_{u,v}} $ ,这样个人掩码加和为0向量。 云端使用联邦平均算法完成全局梯度向量的聚合时,不用考虑个人掩码向量与0向量之和,返回给边缘网关的计算结果只需要减去公共掩码向量$ {{\boldsymbol{p}}_{{\rm{pub}}}} $ 就能得到全局梯度平均值。最后,由于个人掩码的存在,联邦学习的每个参与者无法知道单个边缘网关上传的本地模型梯度,这保证了每个边缘网关的隐私。 由于秘密共享算法的存在,恶意用户都不能通过共谋攻击来攻击系统中的参与者。 这种安全性在理论上是有保证的,同时边缘网关也有一定的冗余性。 因为公共掩码的存在,全局模型梯度在传输过程中不暴露,保证了全局模型梯度的安全性。其算法流程如图2所示。

-

在进行联合学习之前,系统需要设置一些必要的参数,以保证系统传输和安全的需要。

1) 生成云端边缘网关和云端公钥证书,进行身份认证,实现公钥与身份的唯一绑定关系。系统主要使用公钥和私钥对

$ \left( {{\text{dSK,dPK}}} \right) $ 进行身份认证和消息认证。2) 从云端生成一个安全质数k,k的位数必须大于1024。

3) 为秘密共享算法指定一个有限字段F。

4) 在各边缘终端与边缘网关、边缘网关与云端之间建立相应的通信路径。在实验中使用一个相对简单的socket机制来实现每个参与者之间的通信互连。

5) 设置秘密共享协议的参数n和t。

6) 所有参与训练的边缘网关都诚实地使用云端提供的安全质数k,来生成与DH密钥交换协议相关的参数

$ {\text{pp}} \leftarrow {\text{KA}}{\text{.param}}(k) $ 。 -

1) 边缘智能终端对原始数据d添加差分隐私保护机制,

$M(d) = f(d) + N(o,{\sigma ^2}) $ ,其中N是高斯分布, σ 是d的方差。然后将处理后的数据发送到附近的边缘网关进行多用户数据聚合。2) 训练好的边缘网关使用公钥生成算法生成两个公私钥对

$ ( {c_u^{{\text{PK}}},c_u^{{\text{SK}}}} ) \leftarrow {\text{KA}}{\text{.gen}}\left( {{\text{pp}}} \right) $ 和$ ( s_u^{{\text{pk}}},s_u^{{\text{SK}}} ) \leftarrow $ $ {\text{KA}}{\text{.gen(pp)}} $ ,并使用个人签名私钥对公钥进行签名${\sigma _u} \leftarrow $ $ {\text{SIG}}{\text{.sign}} (d_u^{{\text{SK}}},c_u^{{\text{PK}}}||s_u^{{\text{PK}}}) $ 。每个边缘网关拼接后得$ c_u^{{\text{PK}}}||s_u^{{\text{PK}}} \left| {\left| {{\sigma _u}} \right|} \right|{\text{timestamp}} $ 并经过base64编码后通过socket连接到云端。3) 云端收集参与训练的边缘网关发送的信息,当收集一定时间且记录的参与训练的边缘网关数量未达到t及以上时,聚合训练将被中断。 否则,云端广播训练网关集合U1和签名公钥信息。

-

1) 参加训练的边缘网关收到终端集U1和云端广播的签名公钥信息集后检查时间戳;验证

$ \forall v\in U1,\text{SIG}\text{.ver}({d}_{v}^{\text{PK}},{c}_{v}^{\text{PK}}||{s}_{v}^{\text{PK}},\sigma u)=1 $ ,如果验证通过,则生成秘密共享; 否则,训练中断。2) 参与训练的边缘网关使用随机数生成器 PRG 生成两个属于有限域 F的随机数

$ {b_u} $ 。3) 边缘网关生成一个秘密多项式:

$$ F(x){\text{ }} = Bu + {a_1}x + {a_2}x2 + \cdots $$ 4) 使用秘密共享算法生成秘密共享:

${( {v,s_{u,v}^{{\text{SK}}}} )_{v \in U1}} \leftarrow $ $ {\text{SS}}{\text{.share}}(s_u^{{\text{SK}}},t,U1) $ 。5) 边缘网关对于每个其他边缘网关

$ v \in U1 $ ,加密得到:${e_{u,v}} \leftarrow {\text{AE}}.{\rm{enc}}({\rm{KA}}{\text{.agree}}( {c_u^{{\text{SK}}},c_v^{{\text{PK}}}} ), $ $ u| {\left| v \right|} |{b_u}||s_{u,v}^{{\text{SK}}}) $ 。6) 边缘网关使用SHA128 算法取消息摘要并使用签名公钥

$ d_u^{{\text{PK}}} $ 进行签名$ {\theta _{u,v}} \leftarrow {\text{SIG}}{\text{.sign}}( {d_u^{{\text{SK}}},{\text{Hash}}\left( {{e_{u,v}}} \right)} ) $ 。7) 边缘网关发送消息

$ ( {{e_{u,v}} \left| {\left| {{\text{Hash}}\left( {{e_{u,v}}} \right)} \right|} \right| {\theta _{u,v}}||{\text{timestamp}}} ) $ 通过socket发送到云端。8) 从云端采集至少T条密文信息,参与训练的边缘网关记为U2。检查U2 ⊆ U1,如果不能证明,则终止,否则继续进行掩码添加。

9) 云端广播签名秘密消息

$( {e_{u,v}}\left| {\left| {{\text{Hash}}\left( {{e_{u,v}}} \right)} \right|} \right|{\theta _{u,v}}|| {\text{timestamp}} )$ 和边缘网关的集合U2。 -

1) 参与的边缘网关接收签名秘密来自云端的信息并将其保存为列表。

2) 边缘网关以每个网关的随机数

$ {b}_{u} $ 作为种子,用PRG 扩展为随机向量$ {{\boldsymbol{p}}}_{u,\text{prav} }\left(u\in U2\right) $ ,计算公共掩码向量$ {{\boldsymbol{p}}_{{\text{pub}}}} = \displaystyle\sum {{{\boldsymbol{p}}_{u,{\text{prav}}\;}}} $ 。3) 计算掩码梯度向量

${{\boldsymbol{y}}_u} \leftarrow {{\boldsymbol{x}}_u} + {{\boldsymbol{p}}_{{\text{pub}}}} + + $ $ \displaystyle\sum\limits_{v \in U2} {{{\boldsymbol{p}}_{u,v}}} ({\text{mod}}R)$ ,并添加到掩码。4) 对掩码梯度向量进行压缩并使用签名公钥进行签名,

$ {{\boldsymbol{\gamma }}_{u,v}} \leftarrow {\text{SIG}}{\text{.sign}}(d_u^{{\text{SK}}},{{\boldsymbol{y}}_u}) $ 5) 将

$ ( {{{\boldsymbol{y}}_u}\left| {\left| {{{\boldsymbol{\gamma }}_{u,v}}} \right|} \right|{\text{timestamp}}} ) $ 发送到云端,等待云端反馈。6) 云端接受至少t条签名掩码权重向量信息,并记录这些边缘网关为集合U3。检查U3

$ \subseteq $ U2,如果不成立,则终止,否则广播签名掩码梯度向量信息$ ( {{{\boldsymbol{y}}_u}\left| {\left| {{{\boldsymbol{\gamma }}_{u,v}}} \right|} \right|{{\rm{timestamp}}} } ) $ 和边缘网关集U3。 -

1) 边缘网关从云端接收边缘网关集U3,

$ \subseteq $ 如果U3<t,则中止。2) 边缘网关将

${\mu _u} \leftarrow ( U3||{\text{SIG}}{\text{.sign}}( d_u^{{\text{SK}}},\;U3||$ ${\text{timestamp}}) ) $ 发送到云端。3) 云端从至少t个边缘网关处收集

$ {\mu _u} $ (用$ U4 \subseteq U3 $ 表示这组用户),向U4中的每个边缘网关发送集$ {\left\{ {v,{\mu _u}} \right\}_{v \in U4}} $ 。 -

1) 从云端接收合

$ {\left\{ {v,{\mu _u}} \right\}_{v \in U4}} $ ,验证 U4$ \subseteq $ U3, U4>t和消息的新鲜性,根据每个边缘网关签名验证公钥来验证$ {\text{SIG}}{\text{.ver}}( {{d^{{\text{PK}}}},U3,{\mu _u}}) $ 是否等于1。2) 向云端发送掉线边缘网关秘密份额

$ s_{u,v}^{{\text{SK}}}\left( v \in U2\backslash U3 \right) $ 。3) 参与训练的边缘网关收到云端发来的消息,并进行签名验证。

4) 边缘网关计算联合聚合梯度

$ {\text{ans}} = {\boldsymbol{z}} - {{\boldsymbol{p}}_{{\text{pub}}}} $ 并将其加载到本地模型中,为下一轮联合训练做准备。 当训练取得良好效果时,向边缘终端提供服务反馈。5) 从至少t个边缘网关收集响应并将这些边缘网关记录在U5 中。

6) 对于 U

$ \in $ U2中的每个网关,重构$ S_u^{{\text{SK}}} \leftarrow $ ${\text{SS}}{\text{.recon}}( {\left\{ {s{{_{u,{v \in U5}}^{{\text{SK}}}}},t} \right\}} ) $ 并使用它(连同在AdvertiseKeys接收的公钥 )重新计算所有$ v \subseteq U{\text{3}} $ 的$ {{\boldsymbol{p}}_{u,v}} $ 。7) 对于每个网关U

$ \in $ U3,重构${b_u} \leftarrow $ $ {\text{SS}}{\text{.recon}} ( {\left\{ {{{\boldsymbol{b}}_{u,{v \in U5}}}} \right\},t} ) $ ,然后使用PRG重新计算$ {{\boldsymbol{p}}_u} $ 。8) 云端使用签名公钥进行广播压缩向量签名。

-

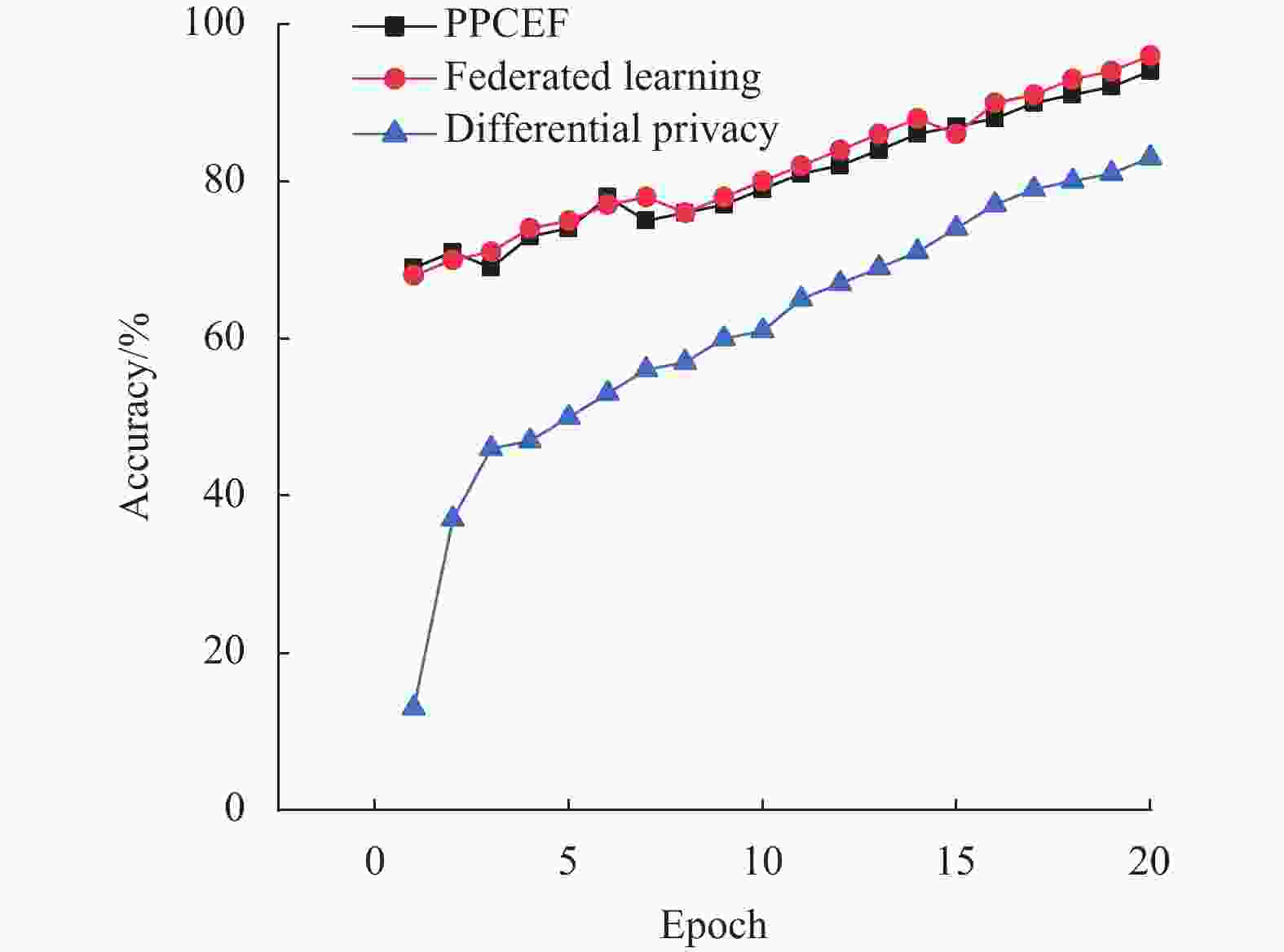

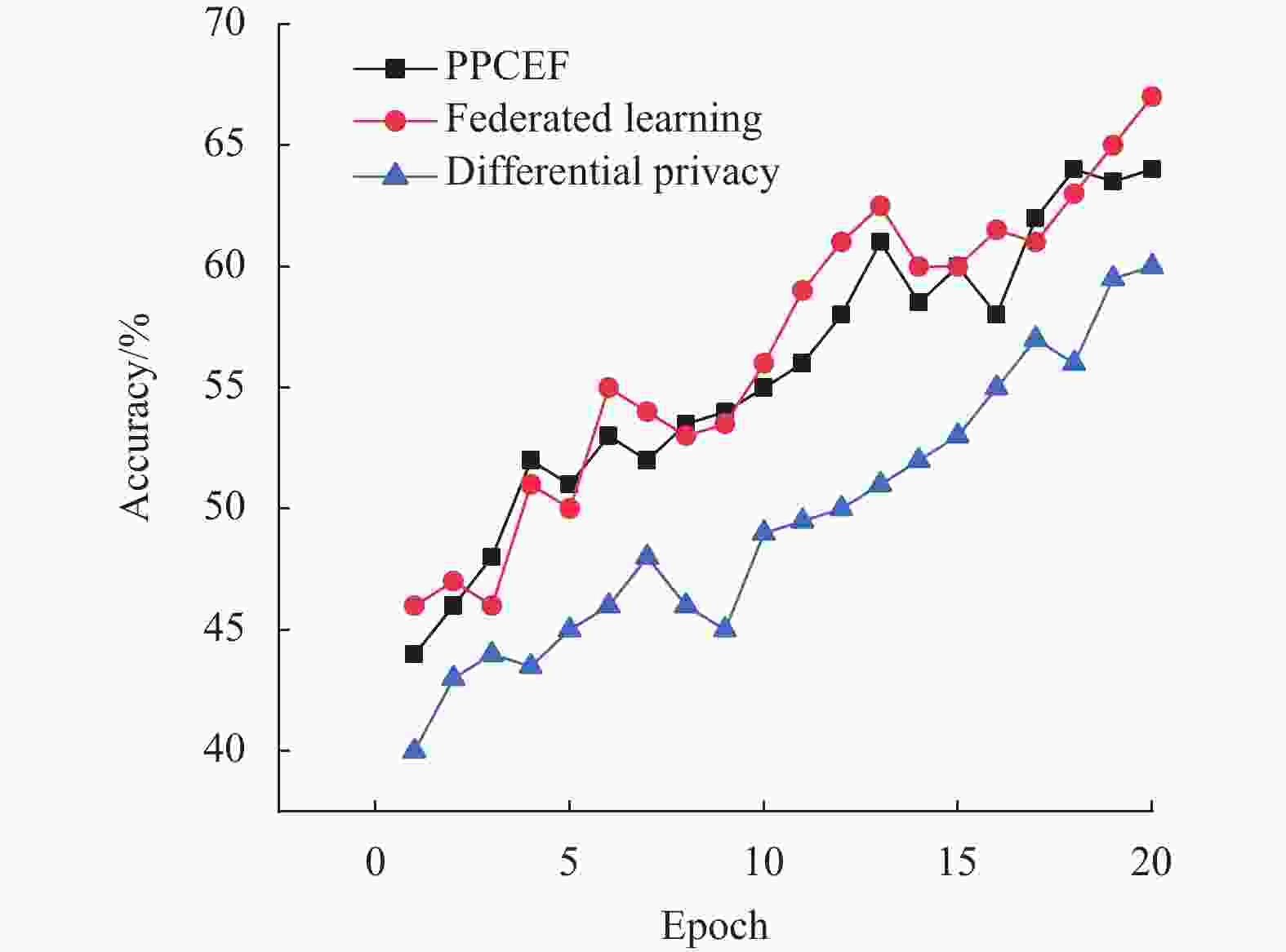

本实验采用MNIST[13-14]数据集和CIFAR10[15]数据集进行对比分析。将原有的联邦学习算法作为比较基准,并将基于主流隐私保护方案的联邦学习验证隐私方法与PPCEF进行比较,以实现对比分析。

-

3种方案在MNIST数据集上进行训练,得到图3所示的ACC(精度)曲线。可以看出,使用MNIST[12]数据集进行16轮训练后,本文的PPCEF模型准确率达到90%。在使用CIFAR10数据集时,从图4可以看到,经过30轮训练,PPCEF模型的准确率达到了95%,它更接近于原始的联合学习,但明显高于差异隐私方案。

可以看出,原始的联邦学习方案精度略高于PPCEF,但原始联邦学习没有添加隐私保护方案,存在隐私风险,而面对一个不安全的网络环境,隐私保护方案是必不可少的。

-

学习系统使用该安全方案,由于梯度添加掩码,使得即使在迭代后,虚拟梯度最大程度接近“真实梯度”,但“真实梯度”是添加掩码的虚假梯度,所以无论迭代多少次,攻击者只有无用的虚假梯度,因此,原始图像不能从梯度恢复。使用梯度泄漏攻击[14]来测试PPCEF的反隐私攻击能力,并将PPCEF攻击结果与原始联邦学习攻击结果进行比较。当原始联邦学习迭代次数为130时,原始图像基本恢复。但是,由于PPCEF在梯度上添加了掩码,原始图像不会暴露。

-

分析了FedAvg[15]、q-FedSGD[16]和PPCEF中各边缘网关参与联邦学习的总能量消耗,能量消耗描述了参与联邦学习的成本。

表2给出了3种算法中每个边缘网关学习的总能耗。3种算法下各边缘网关的能耗分布趋势和时间分布是相似的。

-

在当前的边缘计算网络中,隐私安全问题尤为突出。因此,如何将传统的隐私保护方案与边缘计算环境中的边缘数据处理特征相结合,从而实现多元化服务环境下的用户隐私保护就显得尤为重要。

本文以边缘计算为研究对象,介绍了联邦学习的训练框架,设计了一种基于秘密共享和权重掩码的轻量级隐私保护协议,能够很好地达到隐私保护的目的。

Privacy Protection Scheme Combining Edge Intelligent Computing and Federated Learning

-

摘要: 边缘智能设备、网关和云端在智能协同计算的过程中,存在隐私泄露、计算能力有限等问题。提高联邦学习可以大大提高智能协同计算的训练效率,但也会暴露边缘智能终端的训练集信息。基于此,提出了一种融合边缘智能计算和联邦学习的隐私保护方案(PPCEF)。首先,提出了一个基于共享秘密和权重掩码的轻量级隐私保护协议,该协议基于秘密共享的随机掩码方案,不仅可以在不损失模型精度的前提下保护梯度隐私,还可以抵抗设备掉线和设备间的共谋攻击,具有很强的实用性。其次,设计一种基于数字签名和哈希函数的算法,不仅可以实现消息的完整性和一致性,还能抵抗重放攻击。最后,使用MNIST和 CIFAR10 数据集,证明提出的PPCEF方案在实践中安全且高效。Abstract: Edge intelligent computing is widely used in the fields of Internet of things (IoT), industrial control UAV cluster and so on, which has the advantages of high data processing efficiency, strong real-time performance and low network delay. However, there are many problems when edge intelligent device, edge gateways and cloud complete the task unloading, scheduling and coordination. For example, there are problems that are privacy disclosure, limited calculation force. As is known to all, federated learning allows all training devices to complete training in parallel, which greatly improve training efficiency. However, traditional federated learning will expose the edge device’s information of the training set. So, this article propose a privacy protection scheme combining edge intelligent computing and federated learning (PPCEF). First of all, we propose a lightweight privacy protection protocol based on sharing secret and weight mask, which is based on a random mask scheme of secret sharing. It can not only protect gradient privacy without losing model accuracy, but also resist equipment dropping and collusion attacks between devices, which has strong practicability. Secondly, we design an algorithm based on digital signature and hash function, which can not only achieve the integrity and consistency of the message, but also resist replay attacks. Finally, we use MNIST and CIFAR 10 data sets to prove that our scheme is safe in practice.

-

Key words:

- edge calculation /

- edge gateway /

- federated learning /

- privacy protection

-

表 1 相关算法描述表

算法 含义 KA.param() 公共参数生成 KA.gen() 公私钥对生成算法 KA.agree() 私有共享密钥生成算法 SS.share() 秘密分享算法 SS.recon() 秘密重建算法 SIG.gen() 密钥生成算法 SIG.sign() 签名算法 SIG.ver() 验证算法 -

[1] XU G, LI H, REN H, et al. Data security issues in deep learning: Attacks, countermeasures, and opportunities[J]. IEEE Communications Magazine: Articles, News, and Events of Interest to Communications Engineers, 2019, 57(11): 116-122. [2] KIM T, JUNG I Y, HU Y C. Automatic, location-privacy preserving dashcam video sharing using blockchain and deep learning[J]. Human-centric Computing and Information Sciences, 2020, 10(11): 1-23. [3] SANTOS J, WAUTERS T, VOLCKAERT B, et al. Fog computing: Enabling the management and orchestration of smart city applications in 5G networks[J]. Entropy, 2018, 20(15): 138-144. [4] LU Y, HUANG X, ZHANG K, et al. Communication-efficient federated learning for digital twin edge networks in industrial IOT[J]. IEEE Transactions on Industrial Informatics, 2021, 17(13): 5709-5718. [5] MA X, ZHANG F, CHEN X, et al. Privacy preserving multi-party computation delegation for deep learning in cloud computing[J]. Information Sciences: An International Journal, 2018, 459(17): 103-116. [6] KUANG B Y, FU A M, YU S, et al. ESDRA: An efficient and secure distributed remote attestation scheme for IoT swarms[J]. IEEE Internet of Things Journal, 2019, 6(8): 8372-8383. [7] LAURA D A, BROMBERG F, DUJOVNE D, et al. Prediction of frost events using machine learning and IOT sensing devices[J]. IEEE Internet of Things Journal, 2018, 5(6): 4589-4597. doi: 10.1109/JIOT.2018.2867333 [8] WANG B, LI M, CHOW S S M, et al. Computing encrypted cloud data efficiently under multiple keys[C]//2013 IEEE Conference on Communications and Network Security (CNS). [S. l. ]: IEEE, 2013, 12: 504-513. [9] ZHAO L, WANG Q, ZOU Q, et al. Privacy-preserving collaborative deep learning with unreliable participants[J]. IEEE Transactions on Information Forensics and Security, 2020, 15(12): 1486-1500. [10] ZHANG J, ZHAO Y, WANG J, et al. Fedmec: Improving efficiencyof differentially private federated learning via mobile edge computing[J]. Mobile Networks and Applications, 2020, 10(9): 1-13. [11] ZHANG J, CHEN X, XU G, et al. Universal quantum circuit evaluation on encrypted data using probabilistic quantum homomorphic encryption scheme[J]. Chinese Physics B, 2021, 16(15): 1204-1209. [12] SCHOTT L, RAUBER J, BETHGE M, et al. Towards the first adversarially robust neural network model on mnist[EB/OL]. [2021-05-11]. https://arxiv.org/pdf/1805.09190.pdf. [13] LI H M, LIU H C, JI X Y, et al. CIFAR10-DVS: An event-stream dataset for object classification[J]. Frontiers in Neuroscience, 2017, 11(10): 847-858. [14] DENG J, WANG Y, LI J, et al. TAG: Gradient attack on transformer-based language models[EB/OL]. [2022-05-16]. https://www.xueshufan.com/publication/3199487019. [15] ZHOU Y, YE Q, LV J, et al. Communication-Efficient federated learning with compensated overlap-FedAvg[J]. IEEE Transactions on Parallel and Distributed Systems, 2022, 33(12): 192-205. [16] MEERZA S I A, LI Z H, LIU L Y, et al. Fair and privacy-preserving Alzheimer's disease diagnosis based on spontaneous speech analysis via federated learning[C]//2022 44th Annual International Conference of the IEEE Engineering in Medicine & Biology Society (EMBC). [S. l. ]: IEEE, 2022, 44: 1362-1365. -

ISSN

ISSN

下载:

下载: