-

尺寸小的低分辨率(low resolution, LR)图像恢复成大尺寸或原尺寸的高分辨率(high resolution, HR)图像的过程叫图像超分辨率(super-resolution, SR)重建,可以在有限的硬件设备条件下提高图像品质恢复和复原的效果,该技术目前已成功应用在医疗诊断、红外遥感、虹膜识别和安防监控等领域。

近些年,卷积神经网络(convolution neural network, CNN)受到广泛的研究与应用,并在姿态估计、目标检测和图像增强等计算机视觉任务中获得了优异的效果,被不断尝试应用于新的视觉任务中。SRCNN[1]首次被用于图像超分辨率重建就获得了比传统算法更好的重建效果。在此基础上,文献[2]提出快速超分辨率卷积神经网络,去除输入图像预处理步骤,采用反卷积进行上采样操作,加快了模型的训练速度。

随着研究人员的深入探索,卷积神经网络的层数不断增加以提升图像重建质量。受ResNet[3]残差思想的启发,文献[4]提出更深层的超分辨率网络(very deep convolutional networks, VDSR),利用残差结构加深网络层数,通过自适应梯度裁剪策略来加快模型训练的收敛速度,同时解决梯度爆炸问题,获得了优于SRCNN算法的图像质量评价。文献[5]整合残差块和密集块,提出残差密集网络(residual dense network, RDN),充分提取了特征信息。文献[6]提出超分辨率生成对抗网络(super-resolution generative adversarial network, SRGAN),使用16个残差块串联组成生成网络,利用VGG19[7]提出的感知损失优化函数提升了恢复图像的真实感。文献[8]提出增强深度残差网络(enhanced deep residual networks, EDSR),和SRGAN相比去除了ResNet上不必要的模块,如批量归一化层(batch normalization, BN)。EDSR采用L1Loss函数,提高了图像超分辨率效果。文献[9]在SRGAN上也做了去除生成器中BN的处理,同时加入高效通道注意力,从而获取更多的图像细节。

最近,一些研究使用编码器−解码器框架对降尺度和还原尺度过程进行联合建模从而实现图像超分辨率重建。在IRN[10]中,高频信息独立于LR图像进行建模,性能上受到局限。HCFlow[11]考虑了高频信息与LR图像关系,相比IRN恢复了较丰富的高频细节,但没有充分利用高频信息与LR图像之间的交互作用。文献[12]使用图像隐写的思想将高频信息嵌入到LR图像中,提出一种用于单幅图像的可逆隐写缩放网络(invertible steganography rescaling network, ISRN),该网络有效提取和分离了视觉上难以察觉的隐写信息,从而更好地嵌入到LR图像中,一定程度上提高了重建图像的质量。针对IRN的图像降尺度不适定问题,文献[13]引入新的下缩放潜变量,结合原始潜变量形成一个具有双潜变量的DLV-IRN,在不同的测试集和测试尺度上都提高了生成的HR图像的质量。文献[14]提出可逆任意图像缩放网络(invertible arbitrary rescaling network, IARN),利用位置感知尺度编码和抢占式信道分割等创新组件改进网络。结果表明,在双向任意缩放的情况下,该方法具有较好的性能。这些算法虽然提升了重建后的图像质量,但整个模型的复杂度较大,对承载的硬件要求较高。

针对上述问题,为了平衡模型复杂度和重建性能,本文提出一种改进的IRN算法。通过对IRN关键组件进行深入研究,发现IRN的特征提取模块能提取足够的特征信息,但参数量较大,影响模型的计算速度;模型的潜变量嵌入信息不足,影响逆向训练捕捉边缘信息的能力。所以利用注意力机制和密集连接网络结构设计特征提取模块,并使用小波域高频子带插值设计网络的潜变量,网络参数量较少,计算量低,同时保证了网络的超分辨重建性能,使网络能够部署在硬件要求不高的场景,具有较高的实用价值。

-

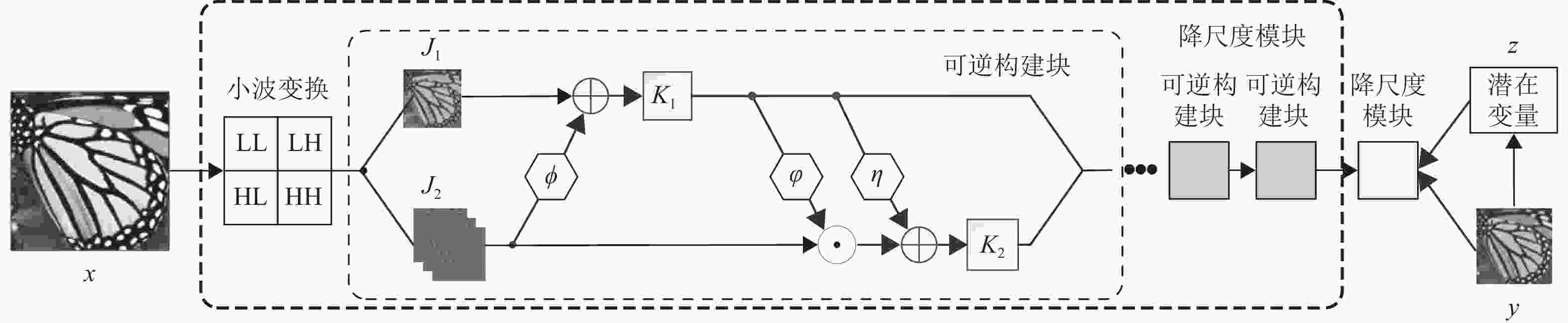

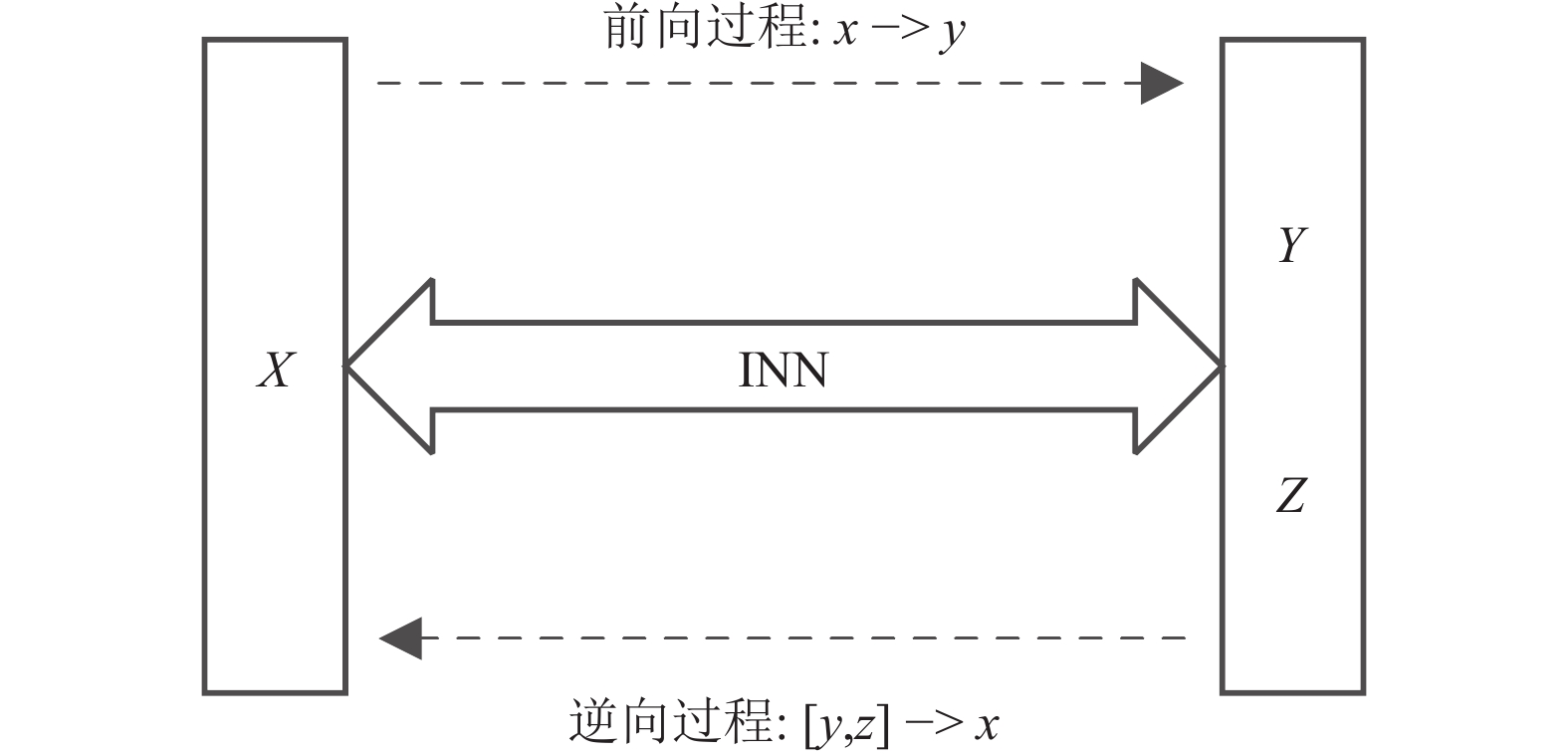

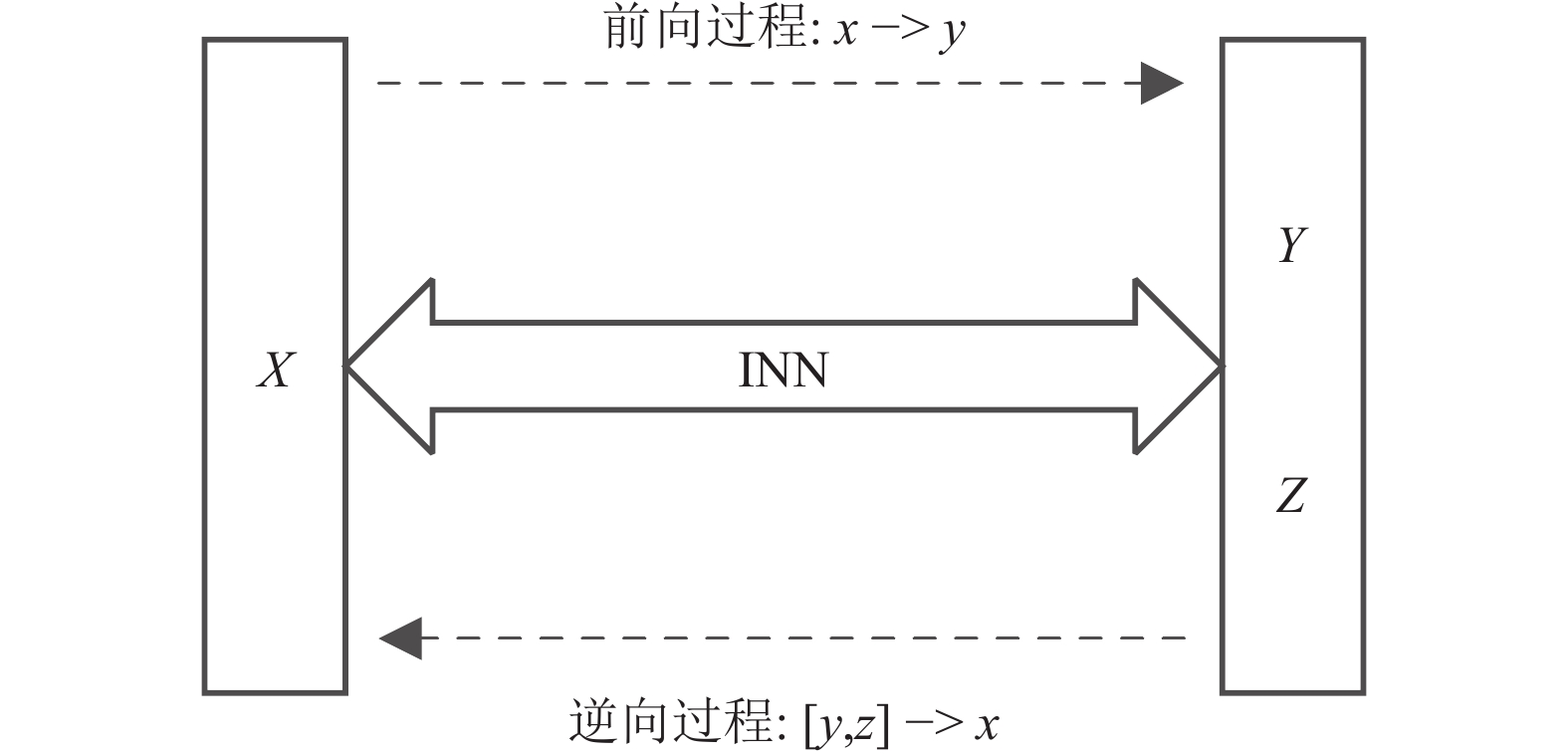

IRN是一种构造双射、有效可逆并且具有易处理雅可比行列式特点的神经网络。网络主要有两个任务:前向和逆向训练过程,如图1所示。

假设X ∈ ℝD,Y ∈ ℝL,数据在前向过程中损失部分信息,所以Y的固有维度L一定小于X的固有维度D,为训练捕获损失的信息,引入潜变量Z调整逆向过程,表示为:

$$ x = g(y,z;\theta )\;\;\;\; z\sim p(z) $$ (1) 式中,θ是网络参数;p(z)表示潜变量z的概率分布。相应的前向过程f(x;θ)可以表示为:

$$ [y,z] = f(x;\theta ) = [{f_y}(x;\theta ),{f_z}(x;\theta )] = {g^{ - 1}}(x,\theta ) $$ (2) 结合上述定义,X的模型分布可以表示为:

$$ {p_{{X}}}(x|y) = p(z){\left| {{J_{{X}}}} \right|^{ - 1}} $$ (3) 式中,JX是雅可比行列式

$ \det \left( {{{\left. {\dfrac{{\partial g(y,z;\theta )}}{{\partial [y,z]}}} \right|}_{y,{f_z}(x)}}} \right) $ 。该神经网络由一系列的构建块组成,本文使用文献[15]的仿射耦合层构建神经网络,如图2所示。输入被分成[J1, J2],经上/下三角的雅可比仿射变换:

$$ {K_1} = \phi ({J_2}) + {J_1} $$ (4) $$ {K_2} = {J_2} \odot \exp (\varphi ({K_1})) + \eta ({K_1}) $$ (5) 式中,输出[K1, K2]连接下一个构建块,内部函数

$\phi $ 、$\varphi $ 、η代表任意的神经网络,当耦合层反转时,有:$$ {J_1} = {K_1} - \phi ({J_2}) $$ (6) $$ {J}_{2}=({K}_{2}-\eta ({K}_{1}))\oslash \mathrm{exp}(\varphi ({K}_{1})) $$ (7) -

本文算法的网络结构如图3所示。整个网络结构由两个相同的降尺度模块串联组成。降尺度模块由一个小波变换和若干个可逆构建块串联而成。小波变换作为第一层把图像x分解成高低频两部分并输入到下一层构建块,同理构建块的输出作为下一层构建块的输入。构建块中

$\phi $ 、$\varphi $ 、η是图像特征提取模块,为了方便计算,三者使用相同的设计。 -

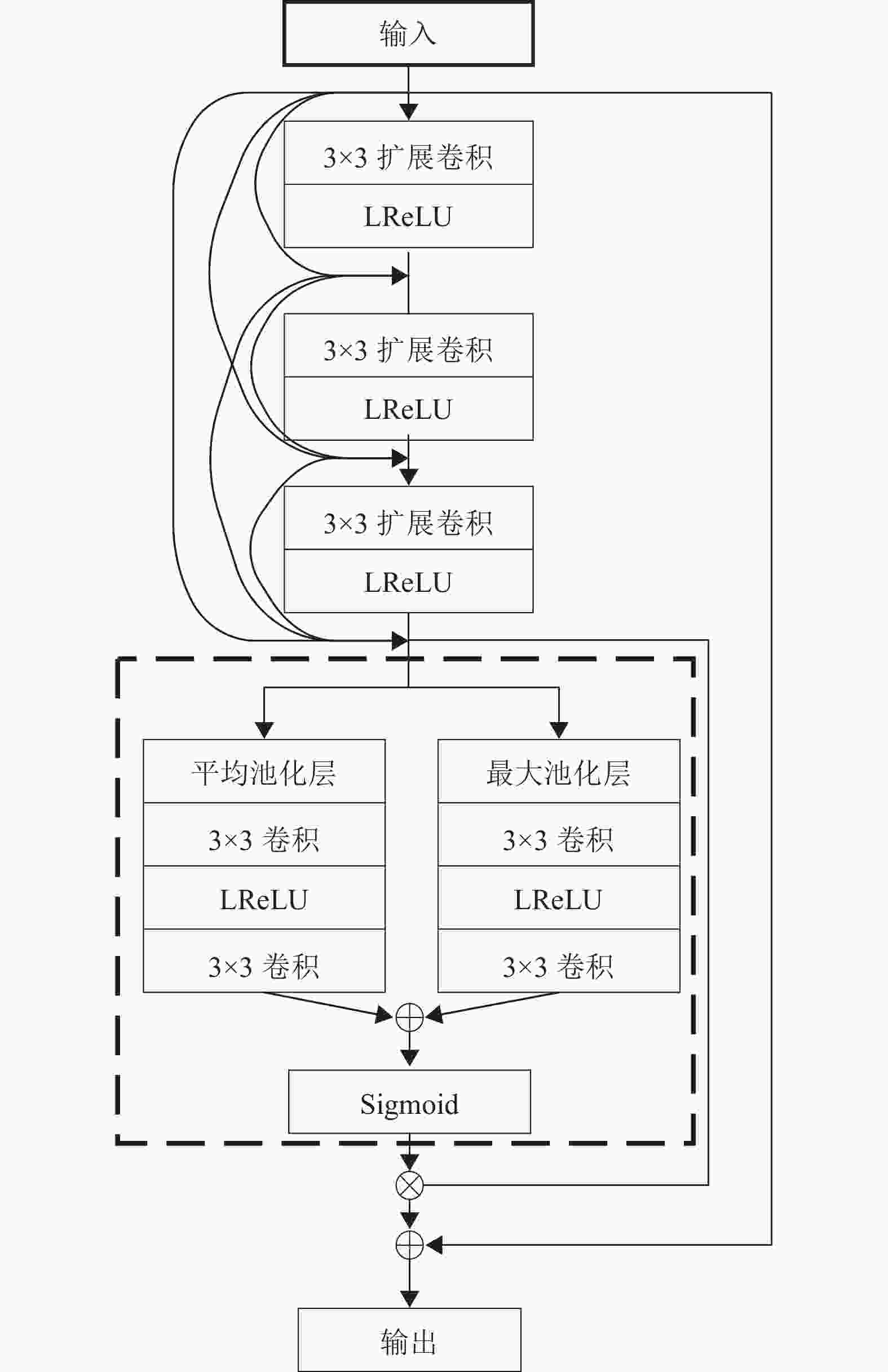

本文利用网络的密集连接结构和通道注意力设计特征提取模块,输入数据首先经过3层密集连接的空洞卷积[16],其卷积核为3×3,扩展率分别为1,2,4,如图4所示。然后每个卷积层再通过ReLU激活函数激活后输出。前面所有层的输出作为后一层的输入实现特征复用,空洞卷积增大了感受野,保证3层密集连接层能提取足够多的特征信息,同时减少模块的参数量。

经过密集连接层后,引入卷积注意力模块[17] (convolutional block attention module, CBAM)的通道域部分,聚合特征映射的空间信息,分配更多资源在关键特征信息上,整个特征提取网络如图5所示。三层密集连接的空洞卷积层提取输入数据的多层密集特征信息,将其输入到注意力通道域,由通道域计算各特征通道的比例系数,最后加到输入的特征信息上,实现网络自适应关注特征信息的重点区域。

-

潜变量的引入是为了捕获图像的高频信息,提高模型图像超分辨率重建的质量。受文献[18]启发,本文采用一种基于离散小波变换的高频子带插值的潜变量,如图5所示。

LR图像经双线性插值上采样2倍,再利用小波变换分解插值后的图像,通过LR图像与低频分量LL比值可获取修正系数:

$$ \alpha = {X_{{\rm{LR}}}}/{X_{{\rm{LL}}}} $$ (8) 式中,XLR和XLL分别代表LR图像和低频分量LL。

如图6所示,根据计算的修正系数α调整HH、HL、LH高频分量,将修正后的高频分量HHʹ、HLʹ、LHʹ通过concatenate函数得到潜变量。该潜变量能嵌入图像高频信息,使模型在逆向训练过程捕捉更多的图像边缘信息,提升重建图像质量。修正系数针对重建效果可进行微调,最终选取2时,效果最佳。

-

本文算法使用L2和L1损失函数计算网络的前向损失和逆向损失,分别为:

$$ {L_2}(\theta ) = \frac{1}{N}\sum\limits_{i = 1}^N {\left\| {{\rm{LR}} - {M_{\rm{f}}}({\rm{HR}},\theta )} \right\|_2^2} $$ (9) $$ {L_1}(\theta ) = \frac{1}{N}\sum\limits_{i = 1}^N {{{\left\| {{\rm{HR}} - {M_{\rm{I}}}({y_{\rm{L}}},z,\theta )} \right\|}_1}} $$ (10) 式中,θ代表网络的优化参数;N代表每次输入图像的数量;LR和HR代表低分辨率和高分辨率标签图像;Mf和MI代表模型的前向和逆向输出结果;yL和z代表前向训练产生的低分辨率图像和潜变量。整个网络的损失函数是前向损失和逆向损失之和,为:

$$ \mathop {\min }\limits_\theta {L_{{\rm{total}}}} = {L_2}(\theta ) + {L_1}(\theta ) $$ (11) 通过最小化损失函数优化网络参数。

-

本文使用DIV2K[19]数据集作训练集,对训练集图像进行随机平移、翻转90°和裁剪等操作实现数据增强,并且统一图像尺寸为480×480,满足训练需求。本文用超分辨率公开的基准数据集Set5,Set14,BSD100,Urban100作测试集。

-

实验平台配置为处理器Intel I5 10600KF,运行内存8 GB,显卡NVIDIA GeForce RTX2060。实验运行环境为Ubuntu18.04,深度学习框架为PyTorch,CUDA加速版本CUDA Toolkit 7.6.5。模型总迭代次数5×105,初始学习率2×10−4,每迭代1×104次,学习率衰减一次,衰减率γ=0.5,使用Adam不断优化网络参数直至模型收敛。

-

分别使用SE(squeeze-and-excitation)模块、CBAM和残差注意力模块(residual attention module, RAM)3种不同的注意机制来结合密集连接结构。SE注意力机制将特征图放到全局池化中,然后提高和降低通道维数,最后与原特征图相乘,生成一个新的特征图[20]。CBAM的通道域比SE模块多一个全局最大池化层,将不同池化后的两个特征图相加后与原特征图相乘,得到输出结果。RAM[21]的通道域采用方差池化,后续步骤与SE注意机制类似。对比分析以上3种不同特征提取模块引入到采用基于小波域高频自带插值的潜变量的可逆缩放网络中的效果。实验结果如表1所示。从表中的结果可以得出,SE和RAM的加入降低了算法的性能,而CBAM的加入在一定程度上提高了算法的性能。因此,CBAM是本算法注意机制的最佳选择。

表 1 不同注意力机制的对比

注意力机制 尺度因子 Set5 Set14 BSD100 PSNR/SSIM PSNR/SSIM PSNR/SSIM \ ×4 31.45/0.90 30.05/0.87 28.75/0.85 CBAM ×4 33.23/0.91 31.12/0.89 29.97/0.88 SE ×4 30.27/0.86 27.34/0.78 27.55/0.79 RAM ×4 30.15/0.85 27.45/0.78 27.65/0.78 -

为了测试和分析改进的IRN网络的重建性能,本文设计消融实验来验证效果。以尺度因子×4为例,在Set14数据集上比较是否引入CBAM和基于小波域高频子带插值的潜变量对图像超分辨率重建的影响。如表2所示,其中:√代表采用,×代表不采用。可以发现同时采用CBAM和基于小波域高频子带插值的潜变量的模型效果最好。

表 2 CBAM和小波域高频子带插值的潜变量消融实验

模型 CBAM 小波域高频子带

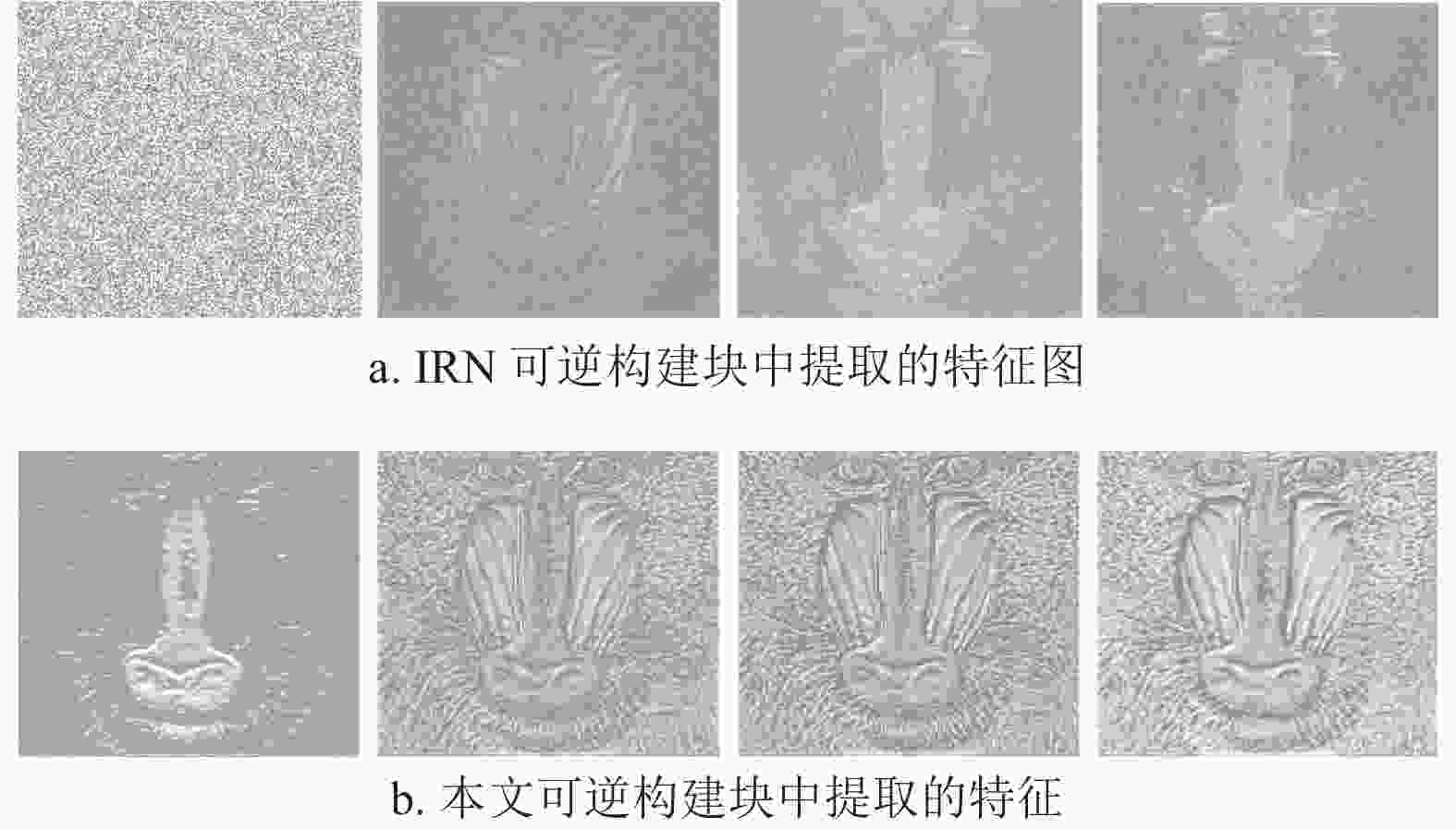

插值的潜变量PSNR/SSIM 1 × × 30.04/0.86 2 √ × 30.42/0.88 3 × √ 30.05/0.87 4 √ √ 31.12/0.89 为了进一步比较由高斯分布和小波域高频子带插值组成的潜变量的性能。使用Set14数据集进行测试,提取网络在执行可逆构建块时产生的特征图。之后对所有特征图进行相同处理,如增加曝光度、锐度使图像对比更加明显。图7均来自Img001,图7a为从IRN可逆构件块中提取的4张特征图,图7b为从本文模型可逆构件块中提取的对应特征图。明显看出由高斯分布构成的潜变量只能提取少量的高频信息,图像轮廓不够清晰。本文采用的小波域高频子带插值可以提取丰富的高频信息,较清晰地看到图像的轮廓。在其他网络组件和参数设置相同的情况下,对比采用高斯分布和小波域高频子带插值的网络在训练期间相同迭代的测试集的峰值信噪比。如图8所示,使用小波域高频子带插值的潜变量比高斯分布的潜变量的网络收敛更快、更稳定。因此,基于小波域高频子带插值的潜变量比采用高斯分布的潜变量性能好。

-

本文从主观人眼感受和客观数据评价两方面来评价重建图像质量。主观人眼感受通过人的视觉评判图像的优劣,客观数据评价通过对峰值信噪比(PSNR)和结构相似度(SSIM)数值大小来评价图像的优劣,本文主要评价RGB通道上的PSNR和SSIM。

PSNR基于图像间对应像素点的像素差值来评价图像质量,单位为dB,计算公式为:

$$ {\rm{PSNR}} = 10{\lg _{}}\left( {\frac{{{{({2^n} - 1)}^2}}}{{{\rm{MSE}}}}} \right) $$ (12) $$ {\rm{MSE}} = \frac{1}{{H W}}\sum\limits_{i = 1}^H {\sum\limits_{j = 1}^W {{{\left\| {{I^{{\rm{HR}}}}(i,j) - {I^{{\rm{SR}}}}(i,j)} \right\|}^2}} } $$ (13) 式中,2n−1表示图像像素范围;MSE是高分辨图像IHR和超分辨率重建图像ISR的均方差。PSNR的值越大则图像失真度越小。

SSIM根据输入图像与重建后的图像的亮度、对比度和结构来计算图像的相似性,数值范围为[0, 1],值越大表示图像相似性越高、失真度越小。计算公式为:

$$ {\rm{SSIM}}(x,y) = \frac{{(2{\mu _x}{\mu _y} + {{\rm{C}}_1})(2{\sigma _{xy}} + {{\rm{C}}_2})}}{{(\mu _x^2 + \mu _y^2 + {{\rm{C}}_1})(\sigma _x^2 + \sigma _y^2 + {{\rm{C}}_2})}} $$ (14) 式中,x为高分辨图像;y为超分辨率重建图像;

$ {\mu _x} $ 和$ {\mu _{{y}}} $ 分别为x和y的均值;$\sigma _x^2$ 和$\sigma _{{y}}^2$ 为x和y的方差;${\sigma _{xy}}$ 为x和y的协方差;C1和C2为常数,通常取C1=0.01×2552,C2=0.03×2552。本文算法与SRCNN、SRResNet、SRGAN、EDSR、RDN、IRN等方法作对比实验,各算法分别在尺度因子×2和×4下计算图像质量指标,在数据集Set5、Set14、BSD100和Urban100下的测试结果如表3、表4所示。数据加粗表示测试的最优值。本文算法在Set5、Set14、BSD100以及Urban100上均取得最高评价指标,客观说明本文算法重建的图像质量优异。

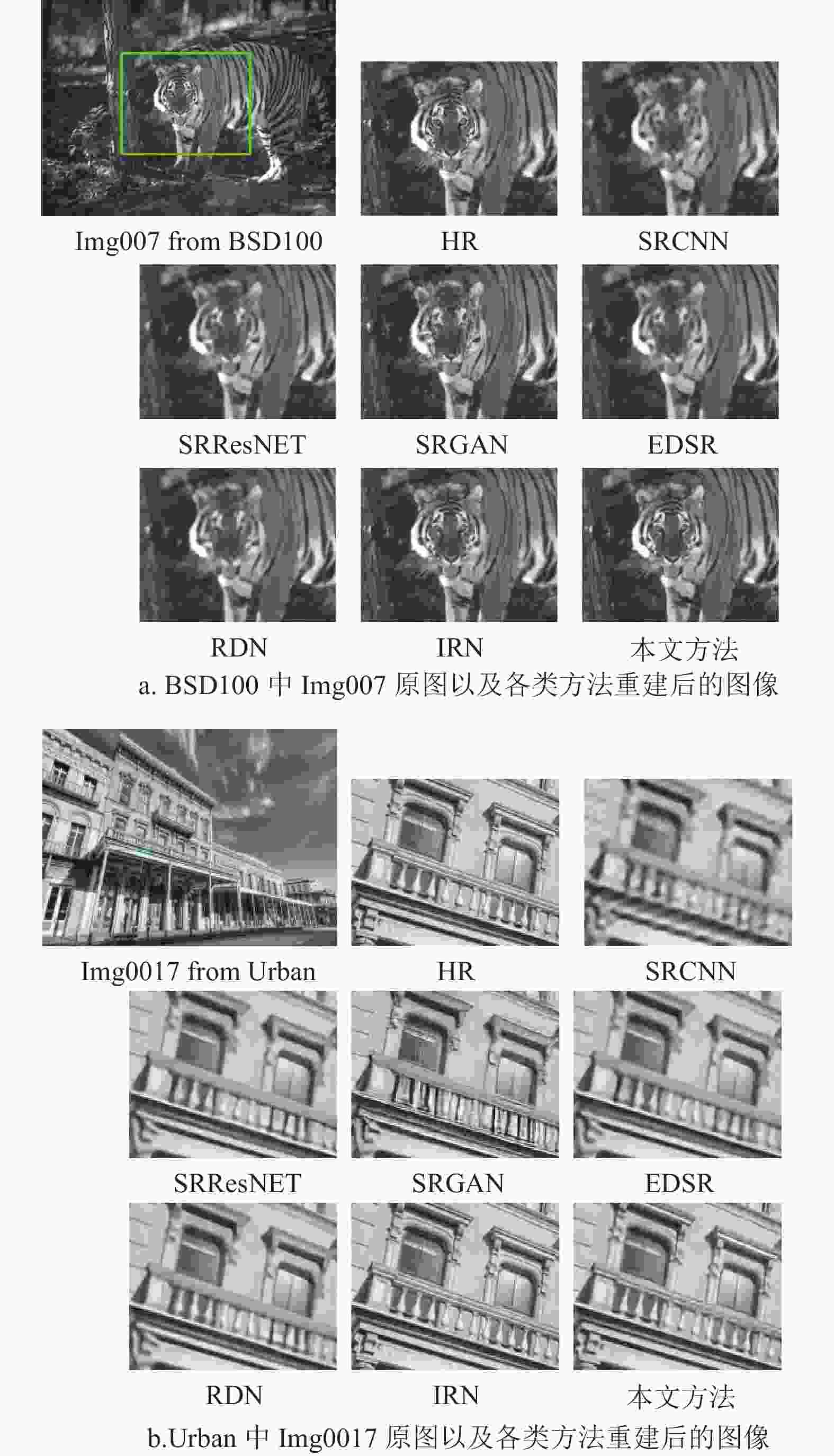

为了从主观上评价各方法的重建效果,在尺度因子×4结果中随机选择2张场景不同的图像,放大每张图像感兴趣的区域,其效果如图9所示,其中HR表示高分辨率参考图像。SRCNN、SRGAN、SRResNET算法重建的图像存在严重的伪影,缺失大量的图像边缘信息,RDNS和ESDN算法重建的图像视觉效果较好,但在纹理细节上较模糊。本文方法和IRN方法的视觉效果最好,两者难以分辨差异,说明本文方法重建图像的视觉效果较逼真。

表 3 测试集在尺度因子×2的PSNR/SSIM

方法 Set5 Set14 BSD100 Urban100 PSNR/dB SSIM PSNR/dB SSIM PSNR/dB SSIM PSNR/dB SSIM SRCNN 34.45 0.92 30.56 0.87 29.86 0.86 27.67 0.87 SRResNet 35.57 0.93 31.52 0.88 30.68 0.88 29.92 0.90 SRGAN 33.78 0.90 30.00 0.84 29.06 0.83 28.55 0.87 EDSR 35.77 0.93 31.69 0.88 30.79 0.88 30.30 0.91 RDN 35.98 0.93 31.85 0.89 30.96 0.88 31.05 0.92 IRN 39.36 0.96 36.30 0.94 38.12 0.96 35.92 0.95 本文方法 39.56 0.97 36.48 0.95 38.56 0.97 36.40 0.96 表 4 测试集在尺度因子×4的PSNR/SSIM

方法 Set5 Set14 BSD100 Urban100 PSNR/dB SSIM PSNR/dB SSIM PSNR/dB SSIM PSNR/dB SSIM SRCNN 28.43 0.81 25.51 0.71 25.43 0.67 22.76 0.68 SRResNet 30.23 0.85 26.75 0.75 26.22 0.70 24.57 0.76 SRGAN 27.94 0.78 24.75 0.67 24.21 0.61 22.76 0.69 EDSR 30.22 0.85 26.76 0.75 26.23 0.70 24.51 0.76 RDN 30.48 0.85 26.95 0.74 26.34 0.70 24.97 0.77 IRN 33.11 0.90 30.04 0.86 29.76 0.86 28.60 0.88 本文方法 33.23 0.91 31.12 0.89 29.97 0.88 28.93 0.89 -

模型的大小影响硬件的计算速度和内存占用率。为检验算法的参数量和运行时间,在4个测试集中随机选取50张图像,尺度因子×4进行测试,与SRCNN、SRResNet、SRGAN、EDSR、RDN、IRN算法对比,结果如表5所示。数据加粗表示最优值。从表中数据可知,本文方法的参数量排倒数第3,重建时间和计算量均为最低。说明本文方法的模型性能比其他算法更好。

表 5 模型复杂度对比结果

方法 参数量/×106 重建时间/ms 计算量/×109 SRCNN 0.0201 130 0.52 SRResNet 1.52 147 4.07 SRGAN 36.4 160 4.07 EDSR 1.52 139 3.18 RDN 22.27 168 36.4 IRN 4.35 88 0.94 本文方法 2.71 85 0.51 -

本文利用注意力机制和密集连接网络结构设计特征提取模块,采用基于小波域高频子带插值的潜变量这种改进可逆缩放网络的图像超分辨率重建算法,减小了计算量和重建时间,提升了模型训练时对图像细节的注意力,同时解决了潜变量保存高频信息较少的问题。实验结果表明,本文算法的重建图像效果和模型的性能整体优于现有的几种方法。

致谢:本文工作还得到桂林电子科技大学研究生教育创新计划(2021YCXS125)的支持,在此表示感谢!

Image Super-Resolution Reconstruction with Improved Invertible Rescaling Network

-

摘要: 可逆缩放网络(IRN)的潜变量采用高斯分布嵌入图像高频信息,因其独立随机性无法充分保存图像高频信息,嵌入效果一般,影响重建性能。通过改进可逆缩放网络来提高嵌入高频信息的能力并进一步降低模型的复杂度。首先,特征提取模块采用密集连接结构和通道注意力机制来获取足够的特征信息,同时减少模块参数量;其次,网络的潜变量采用小波域高频子带插值设计,改善高频信息嵌入能力。实验结果显示该算法相比IRN,在Set5、Set14、BSD100和Urban100这4个基准测试集上的PSNR和SSIM分别平均提升了0.380 dB和0.014,参数量减少约1.64×106,计算量减少约0.43×109,运行时间减少3 ms。表明该算法的重建性能优良,模型复杂度低,具有实用价值。Abstract: The latent variable of Invertible Rescaling Network (IRN) uses Gaussian distribution to embed the high-frequency information of the image. Because of the independence and randomness of this approach, the high-frequency information of the image cannot be fully preserved, and the embedding effect is general, which affects the performance of the reconstruction. In order to improve the ability of embedding high frequency information and further reduce the complexity of the model, this paper proposes an improved algorithm based on IRN. Firstly, the dense connection structure and channel attention mechanism are adopted to obtain sufficient feature information and reduce the number of parameters in the feature extraction module. Secondly, the latent variable of the network is designed by high frequency sub-band interpolation in wavelet domain to improve the embedding ability of high frequency information. The results show that compared with IRN, the average Peak Signal to Noise Ratio (PSNR) and Structure Similarity Index Measure (SSIM) of the proposed algorithm are improved by 0.380 dB and 0.014 on the four benchmark test sets Set5, Set14, BSD100 and Urban100, the algorithm parameters in this paper are reduced by about 1.64×106 M, the FLOPs are reduced by about 0.43×109 G, and the running time is reduced by 3 ms. It verifies that the reconstruction performance of the proposed algorithm is excellent and the model complexity is low, which has practical value.

-

表 1 不同注意力机制的对比

注意力机制 尺度因子 Set5 Set14 BSD100 PSNR/SSIM PSNR/SSIM PSNR/SSIM \ ×4 31.45/0.90 30.05/0.87 28.75/0.85 CBAM ×4 33.23/0.91 31.12/0.89 29.97/0.88 SE ×4 30.27/0.86 27.34/0.78 27.55/0.79 RAM ×4 30.15/0.85 27.45/0.78 27.65/0.78 表 2 CBAM和小波域高频子带插值的潜变量消融实验

模型 CBAM 小波域高频子带

插值的潜变量PSNR/SSIM 1 × × 30.04/0.86 2 √ × 30.42/0.88 3 × √ 30.05/0.87 4 √ √ 31.12/0.89 表 3 测试集在尺度因子×2的PSNR/SSIM

方法 Set5 Set14 BSD100 Urban100 PSNR/dB SSIM PSNR/dB SSIM PSNR/dB SSIM PSNR/dB SSIM SRCNN 34.45 0.92 30.56 0.87 29.86 0.86 27.67 0.87 SRResNet 35.57 0.93 31.52 0.88 30.68 0.88 29.92 0.90 SRGAN 33.78 0.90 30.00 0.84 29.06 0.83 28.55 0.87 EDSR 35.77 0.93 31.69 0.88 30.79 0.88 30.30 0.91 RDN 35.98 0.93 31.85 0.89 30.96 0.88 31.05 0.92 IRN 39.36 0.96 36.30 0.94 38.12 0.96 35.92 0.95 本文方法 39.56 0.97 36.48 0.95 38.56 0.97 36.40 0.96 表 4 测试集在尺度因子×4的PSNR/SSIM

方法 Set5 Set14 BSD100 Urban100 PSNR/dB SSIM PSNR/dB SSIM PSNR/dB SSIM PSNR/dB SSIM SRCNN 28.43 0.81 25.51 0.71 25.43 0.67 22.76 0.68 SRResNet 30.23 0.85 26.75 0.75 26.22 0.70 24.57 0.76 SRGAN 27.94 0.78 24.75 0.67 24.21 0.61 22.76 0.69 EDSR 30.22 0.85 26.76 0.75 26.23 0.70 24.51 0.76 RDN 30.48 0.85 26.95 0.74 26.34 0.70 24.97 0.77 IRN 33.11 0.90 30.04 0.86 29.76 0.86 28.60 0.88 本文方法 33.23 0.91 31.12 0.89 29.97 0.88 28.93 0.89 表 5 模型复杂度对比结果

方法 参数量/×106 重建时间/ms 计算量/×109 SRCNN 0.0201 130 0.52 SRResNet 1.52 147 4.07 SRGAN 36.4 160 4.07 EDSR 1.52 139 3.18 RDN 22.27 168 36.4 IRN 4.35 88 0.94 本文方法 2.71 85 0.51 -

[1] DONG C, LOY C C, HE K, et al. Image super-resolution using deep convolutional networks[J]. IEEE Trans Pattern Anal Mach Intell, 2016, 38(2): 295-307. doi: 10.1109/TPAMI.2015.2439281 [2] DONG C, LOY C C, TANG X. Accelerating the super-resolution convolutional neural network[C]//Proceedings of the European Conference on Computer Vision. Amsterdam: Springer, 2016: 391-407. [3] HE K, ZHANG X, REN S, et al. Deep residual learning for image recognition[C]//Proceedings of the 2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Las Vegas: IEEE, 2016: 770-778. [4] KIM J, LEE J K, LEE K M. Accurate image super-resolution using very deep convolutional networks[C]//Proceedings of the 2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Las Vegas: IEEE, 2016: 1646-1654. [5] ZHANG Y, TIAN Y, KONG Y, et al. Residual dense network for image super-resolution[C]//Proceedings of the 2018 IEEE Conference on Computer Vision and Pattern Recognition(CVPR). Salt Lake City: IEEE, 2018: 2472- 2481. [6] LEDIG C, THEIS L, HUSZAR F, et al. Photo-Realistic single image super-resolution using a generative adversarial network[C]//Proceedings of the 2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Honolulu: IEEE, 2017: 105-114. [7] SIMONYAN K, ZISSERMAN A. Very deep convolutional networks for large-scale image recognition[EB/OL]. [2015-4-15]. https://arxiv.org/pdf/ 1409.1556.pdf. [8] LIM B, SON S, KIM H, et al. Enhanced deep residual networks for single image super-resolution[C]// Proceedings of the 2017 IEEE Conference on Computer Vision and Pattern Recognition Workshops(CVPR). Honolulu: IEEE, 2017: 136-144. [9] 刘郭琦, 刘进锋, 朱东辉. 基于生成对抗网络的图像超分辨率重建算法[J]. 液晶与显示, 2021, 36(12): 1720-1727. doi: 10.37188/CJLCD.2021-0227 LIU G Q, LIU J F, ZHU D H. Image super-resolution reconstruction algorithm based on generative adversarial network[J]. Chinese Journal of Liquid Crystals and Displays, 2021, 36(12): 1720-1727. doi: 10.37188/CJLCD.2021-0227 [10] XIAO M Q, ZHENG S X, LIU C, et al. Invertible image rescaling [C]//Proceedings of the European Conference on Computer Vision. Glasgow: Springer, 2020: 126-144. [11] LIANG J Y, LUGMAYR A, ZHANG K, et al, Hierarchical conditional flow: A unified framework for image super-resolution and image rescaling[C]//Proceedings of the IEEE/CVF International Conference on Computer Vision. Montreal: IEEE, 2021: 4076-4085. [12] GUO M X, ZHAO S J, L Y, et al. Invertible single image rescaling via steganography[C]//2022 IEEE International Conference on Multimedia and Expo (ICME). Taipei, China: IEEE, 2022: 341-347. [13] ZHANG M, PAN Z, ZHOU X, et al. Enhancing image rescaling using dual latent variables in invertible neural network[EB/OL]. [2022-7-24]. https://arxiv.org/pdf/2207.11844.pdf. [14] PAN Z H, LI B P, HE D L, et al. Effective invertible arbitrary image rescaling[EB/OL]. [2022-9-26]. https://arxiv.org/pdf/2209.13055.pdf. [15] DINH L, SOHL-DICKSTEIN J, BENGIO S. Density estimation using real NVP[EB/OL]. [2017-2-17]. https://arxiv.org/pdf/1605.08803.pdf. [16] WANG Y, HU S, WANG G, et al. Multi-Scale dilated convolution of convolutional neural network for crowd counting[J]. Multimedia Tools Applications, 2020, 79(1): 1057-1073. [17] WOO S, PARK J, LEE J Y, et al. CBAM: Convolutional block attention module[C]//Proceedings of the European Conference on Computer Vision. Munich: Springer , 2018: 3-19. [18] ANBARJAFARI G, DEMIREL H. Image super resolution based on interpolation of wavelet domain high frequency subbands and the spatial domain input image[J]. ETRI J, 2010, 32(3): 390-394. doi: 10.4218/etrij.10.0109.0303 [19] AGUSTSSON E, TIMOFTE R. NTIRE 2017 challenge on single image super-resolution: dataset and study[C]//Proceedings of the 2017 IEEE Conference on Computer Vision and Pattern Recognition Workshops (CVPR). Honolulu: IEEE, 2017: 1122-1131. [20] HU J, SHEN L, ALBANIE S, et al. Squeeze-and- excitation networks[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2020, 42(8): 2011-2023. doi: 10.1109/TPAMI.2019.2913372 [21] WANG F, JIANG M Q, QIAN C, et al. Residual attention network for image classification[C]//Proceedings of the 2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Honolulu: IEEE, 2017: 3156-3164. -

ISSN

ISSN

下载:

下载: