-

近年来,深度学习在计算机视觉感知[1]、语音识别[2]、文本理解[3]等领域取得巨大成功,引起了研究者的极大关注。然而,当前大部分深度学习方法需要海量的标注样本才能学习到泛化性较好的智能识别模型,单纯依靠数据驱动的建模方式使得基于深度学习的目标识别面临新的挑战。一方面,仅采用数据驱动方式难以解决标注样本较少的问题。对于很多实际问题,要么是很难采集到大量样本,要么是标注样本的成本极高,仅依靠少量标注数据,使用数据驱动建模很难得到可靠的模型;另一方面,模型的不稳定性和难解释性一直是深度学习理论面临的难点问题,伴随海量标注数据的大量噪声导致深度学习不稳定,深度学习模型提取的特征很难直观地理解和解释。这些问题和挑战限制了深度学习解决更复杂、更抽象问题的可能性。

导致这些问题和局限的根本原因在于当前人工智能方法与人类智能存在较大差异,人类自身学习识别并不需要大量的标注样本,而是通过已有知识、经验,对照少量样例归纳总结并进行分析与判断,实现目标的稳定识别。缩小人工智能与人类智能的鸿沟,仍然是现代人工智能面临的巨大挑战。

将外部可理解的语义空间知识引入识别建模过程,采用知识与数据联合驱动的方式进行智能模型构建是解决上述问题的一条重要途径。一方面知识与数据联合驱动建模,需要统一先验知识和数据信息的表征形式,实现相互补充,一定程度上解耦深度学习模型训练对海量数据的强依赖性,缓解小样本问题;另一方面,相比于数据,知识的稳定性和可靠性更高,基于知识与数据联合驱动模型更符合真实的人类思维与思考习惯,有利于提高识别算法的稳定性、可靠性与鲁棒性,能够进一步提高识别效果,为后续更上层的智能化应用(推理、决策等)提供基础感知模型。知识与数据联合驱动的识别建模能够突破当前基于深度学习的目标识别建模的瓶颈,解决深度学习在小样本、模型可解释性问题上的局限性。

如何摆脱深度学习模型对海量标注样本的依赖,突破人工智能在小样本问题上的瓶颈,提高模型可解释性,正逐渐成为重要的研究方向。本文首先以外部知识在智能识别模型构建中的引入方式为区分准则,提出一种模型构建方法的分类标准;然后对每类构建方法在解决小样本、模型可解释性问题方面的探索进行了综述总结;最后,提出了一种知识与数据联合驱动建模方式,并基于此提出了需要进一步研究的问题与未来的研究方向。

-

外部认知经验与知识一直是智能识别建模的重要要素。根据外部认知经验与知识在智能识别模型构建过程中的引入方式,可以将模型构建方法分为3类:基于显式知识的建模方法、基于隐式知识的建模方法以及基于融合知识的建模方法。

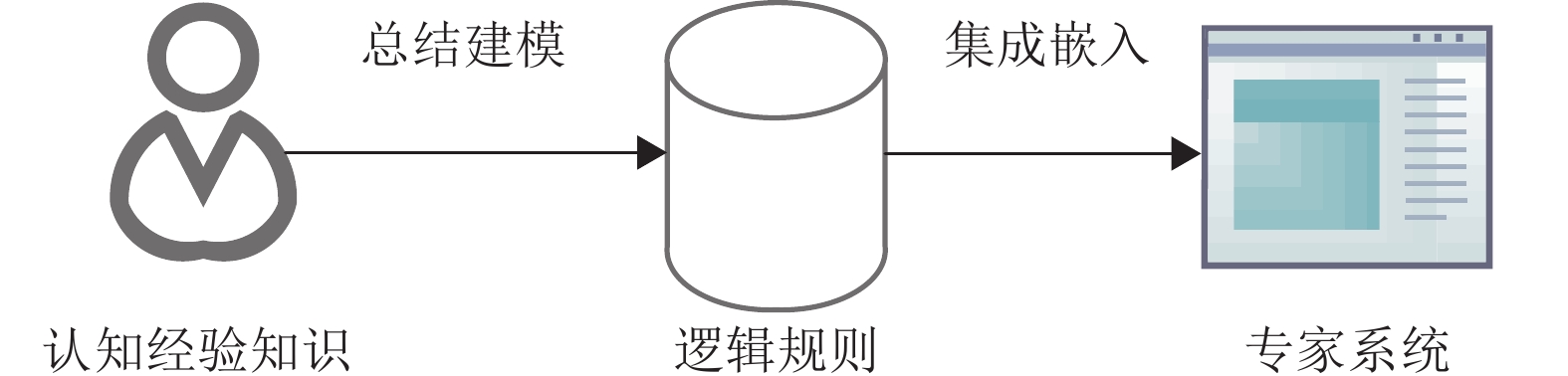

基于显式知识的建模方法直接对显式的目标特征知识进行建模。早期的专家系统就属于这类方式。本质上是将外部认知经验与知识总结建模为形式化的逻辑规则,然后将这些规则集成嵌入系统运行流程中,如图1所示。

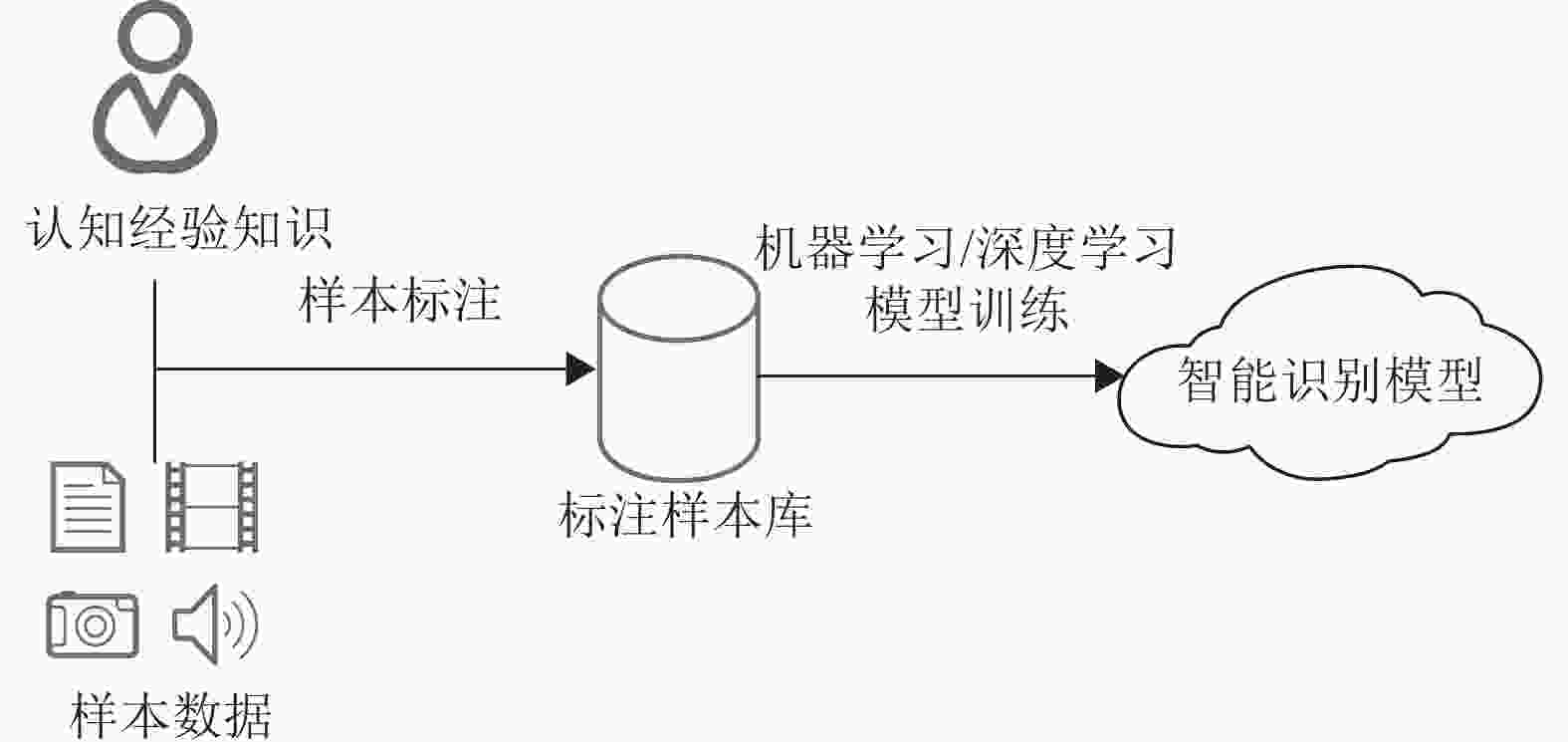

基于隐式知识的建模方法是现阶段较常用的建模方式,其特点在于外部的认知经验与知识通过样本数据的标签信息引入建模过程中。这类方式不直接对认知经验知识进行建模,需要在模型训练过程中通过有监督方式归纳学习目标特征,完成识别建模。典型的基于隐式知识的建模方式如图2所示。

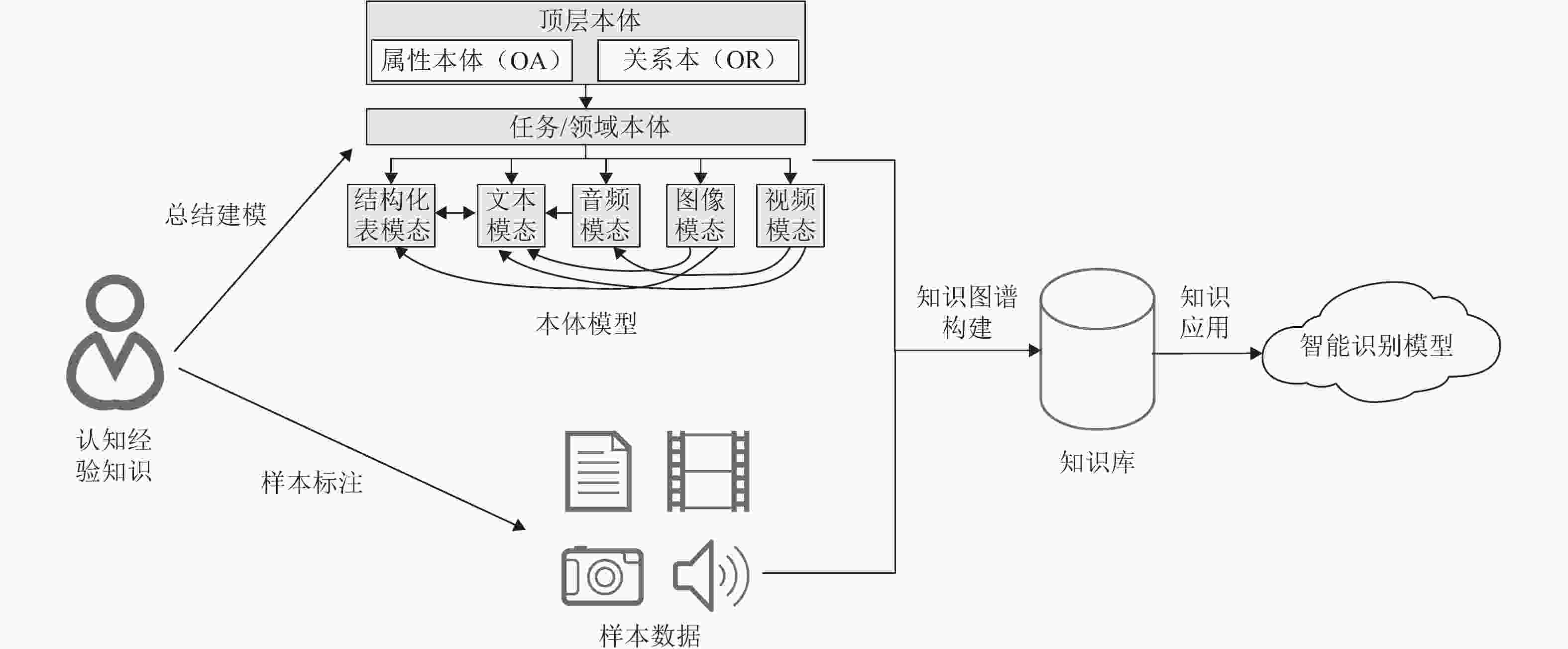

基于融合知识的建模方法同时结合了上述两种建模方式,近年来得到广泛研究的知识图谱相关技术就是采用这种建模方法,如图3所示。外部认知经验与知识通过显式和隐式两种方式引入模型。如知识图谱构建过程中的本体模型就是典型的显式知识引入方式,直接对目标知识进行建模;隐式知识引入通过样本标签体现,用于知识提取、消歧、融合等构建过程。这类方式通常先从数据中挖掘提取知识,构建形成知识库,然后基于知识库构建各类识别应用模型。

-

直接对经验和认知知识进行建模可以追溯到20世纪[4-7]。当时,符号主义主导着人工智能的发展,1955年文献[8]提出了基于知识与经验的推理模型,然后逐渐演化为专家系统[9-10]。

这类模型无需标注训练样本,通过追踪模型运行逻辑,模型输出结果就能得到较好的解释,较低的数值计算复杂度使得模型具有良好的稳定性。

然而,早期的专家系统将经验知识建模为规则或逻辑程序,虽然便于计算机处理,但这类方式往往只能建模较为简单的知识,表达复杂知识与逻辑的能力有限,很难刻画复杂和不确定的知识。此外,由于缺乏自动化的知识获取和表征方法,导致专家系统效率很低,可移植性和鲁棒性差,逐渐被基于数据驱动的人工智能模型替代。

-

基于隐式知识的建模方法应用较为广泛,传统的机器学习方法(支持向量机、决策树、随机森林等)与深度学习方法(卷积神经网络、循环神经网络、生成对抗网络等)都属于这种建模方法。不同的是传统的机器学习方法是寻求建立人工设计的特征与数据标签之间的映射关系,而深度学习方法采用一种端到端的方式直接对数据本身进行建模,通过深度神经网络自动学习提取特征并建立深度特征与数据标签之间的映射关系。

近年来,为了能够在监督信息有限的情况下基于隐式知识进行建模,弥合人工智能与人类智能之间的鸿沟,针对小样本学习(few-shot learning, FSL)的研究应运而生。

传统的机器学习方法在面对小样本问题时,通常采用特征工程相关方法进行处理,如对有限的样本进行采样,扩充数据集或对特征进行增强,使得样本特征分布更趋近于真实的特征分布。这类处理方法虽然一定程度上缓解了小样本问题,但由于方法对特征选择和提取的依赖性,导致传统机器学习方法在处理复杂、高维的数据时具有一定的局限性。因此,在处理图像、音视频等数据方面逐渐被深度学习模型所替代。而在深度学习方面,对小样本深度学习相关的研究已经比较深入,也取得了一系列极有价值的研究成果。

当前的小样本深度学习可以视为一种先验知识与数据的联合,即寻求在海量基类数据上学习提炼先验知识(元学习),然后在只有少量样本的测试类上应用。但是,从度量学习训练模式不难发现,现有的小样本深度学习方法所使用的先验知识通常来自与测试类别类似或同质且具有海量标注数据的基类,本质上并没有解耦模型对海量样本的强依赖性,只是转移了海量数据的需求方向(从目标类转移到基类,从目标知识的学习转移到先验知识的学习)。此外,元学习得到的类语义空间无法与真实语义符号空间关联,导致模型可解释性不高,难以有效实现知识的持续积累和更新扩展。目前,小样本学习方法主要分为数据增强和度量学习(元学习)两类。

-

数据增强是利用先验知识扩充数据集。早期的FSL从相似的类中学习几何变换进行数据扩展[11],后续不少工作从特征和属性的合成及迁移角度间接对数据进行扩展[12-18],其中,文献[15]基于自编码网络结构,采用无监督预训练的方式增强模型对数据特征的感知能力,利用少量标注样本实现了较好的识别效果。此外,还有不少工作[19-23]建立生成模型实现样本的生成扩展。近几年,基于数据的分布[24-26]以及模型注意力分布[27]等统计信息的方法也引起了研究人员的关注并取得了较好的效果,如文献[27]针对小样本场景下的知识蒸馏提出了一种基于教师模型响应的数据增强方法,有效地提升了小样本知识蒸馏效果。

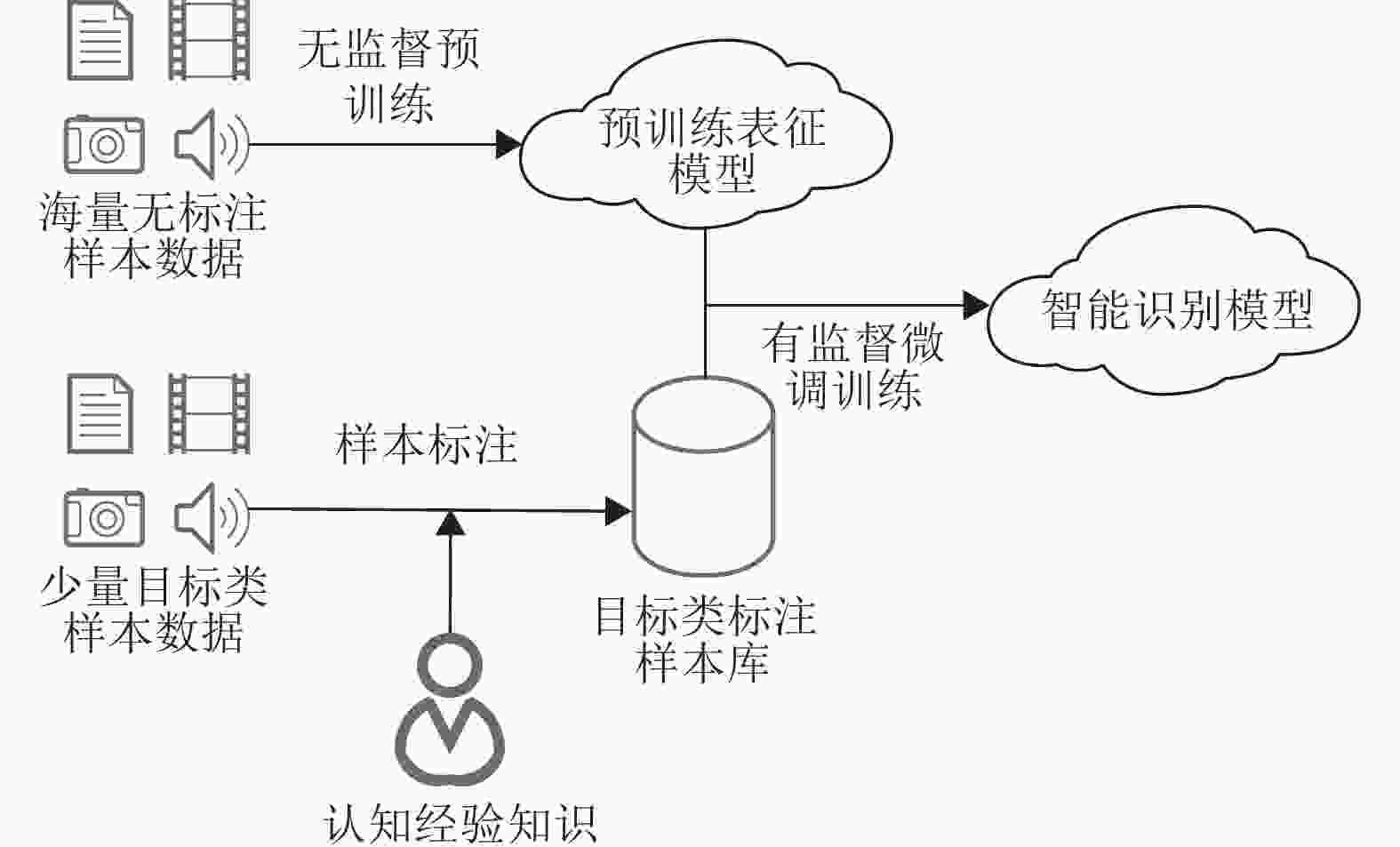

此外,文献[28-30]将数据增强融合到弱监督对比学习框架中,如图4所示,在无标注数据上使用不同的数据增强方法产生多个数据视图,然后通过对比数据视图使得模型学习到目标特征,完成表征模型的预训练,然后利用下游识别任务对应的少量标注样本,进行有监督微调训练,以降低模型对海量标注样本的依赖性。

-

度量学习是一种元学习方法,其目标是学习一种相似性度量,通常采用跨任务的N-way K-shot训练范式。在训练过程中,从基类数据集中随机抽取N个类别,每个类别随机选择K个样本作为支持集,再从这N个类的剩余样本中随机抽取部分样本作为查询集。这种学习方式如图5所示。

度量学习的目的就是使模型学会识别查询集。典型的度量学习工作包括:孪生神经网络[31]、三元组排序网络[32]、原型网络[33-34]、基于注意力自适应模块[35]、组合特征聚合模块[36]、主特征网络[37]、匹配网络[38-41]、关系网络[42]及其改进网络[43-44]以及协方差度量网络[45-46]等。此外,文献[47-51]对特征间的关系进行建模以实现度量学习。其中,文献[51]提出了基于多尺度的标签传播网络,利用多尺度生成器生成多个尺度的图像特征,并集成关系度量模块获得多个不同尺度特征下的样本相似性得分。除了度量学习外,还有部分工作采用基于记忆的元学习方法将小样本学习任务表示为序列学习任务[52-55]。最近,文献[56]基于集成学习思想,提出了一种集成度量学习方法,综合考虑图像级和局部特征级子度量以及标签传播度量,最后将多个子度量融合作为最终度量输出。

-

基于隐式知识的建模将所有的处理都放在向量空间进行计算。这类模型将数据标签嵌入映射到一个标签向量空间(如one-hot编码),学习特征向量空间与标签向量空间之间的映射关系。当前基于数据挖掘的知识驱动相关方法大多采用这一类模式。这种模式具有较好的数学特性,能充分利用算力开展大规模运算。

对于传统机器学习方法,由于人工设计的特征本身具有较为明确的含义,因此,模型的可解释性较好。如支持向量机中模型的决策结果来自于支持向量与目标向量的距离,决策树中模型的决策结果来自于节点的条件判断。

然而深度学习方法却具有可解释性不高、依赖海量数据以及鲁棒性不强等局限性。因此,如何使得深度学习模型突破这些瓶颈,逐渐成为深度学习模型研究的重点。事实上,美国国防部高级研究计划局(DARPA)在2016年发布了“可解释的人工智能”(explainable artificial intelligence, XAI)项目[57-59],其目标就是建立一套新的机器学习技术,生成可解释的模型,结合有效的解释技术,使得最终用户能够理解、一定程度的信任并有效地管理未来的人工智能系统。2018年,DARPA启动“下一代人工智能”(AI Next)项目,用于构建能够进行类似人类交流和逻辑推理的人工智能工具。我国在2020年度国家自然科学基金指南引导类原创探索——面向复杂对象的人工智能理论基础研究项目中,计划通过信息科学与数学、物理学、化学等基础学科的深度交叉融合,从复杂性与多尺度视角探索人工智能基础理论与方法,突破现有人工智能可解释性瓶颈,推动动态、稳健与可信的智能模型与方法体系的构建。2022年,国家自然科学基金委员会发布了“可解释、可通用的下一代人工智能方法重大研究计划”,旨在建立规则和学习的有效融合机制,打破现有深度学习“黑箱算法”的现状,建立一套适用于不同领域、不同场景(语音、图像、视频等)的通用方法体系。

近年来,相关方向也有不少研究工作[60-66],其中,文献[62]利用有限状态机探索循环神经网络(RNN)的内在机制,将RNN的内部流程表达为有物理意义的模型。文献[66]提出基于心智理论(theory of mind, ToM)的可解释性AI模型,提高对深度学习模型输出的信心。

-

基于融合知识的建模方法首先从数据中挖掘提取知识,构建形成知识库,然后应用于各类场景。当前得到广泛研究的知识图谱就是采用这类技术路线,大致包含4个方向:知识建模、知识提取、知识表征以及知识应用。

当前,基于融合知识的建模已经有不少研究工作,如何从数据中建模、提取知识并进行表征和应用已得到广泛关注。基于融合知识的建模方法本质上属于一种双空间模型,其中符号空间(语义空间)模拟认知知识,亚符号空间(向量空间)模拟感知状态。文献[67-72]提出的模型寻求学习特征向量空间和语义符号空间的对应关系,使两个空间能够直接相互映射以支撑应用。这类模式对样本的标注要求很高,需要尽可能精确到每一个语义符号,模型才有可能学习得到映射关系。

此外,当前大多数知识的提取和表征方法都还是依赖于海量的标注数据,仅在知识应用层考虑了小样本,整体来看,并没有从根本上解决深度学习模型对海量样本的依赖问题。此外,由于知识图谱最早是由语义任务推动发展的,因此大部分知识图谱的设计能够很好地描述事物间的逻辑关系,但在属性特征表达方面偏弱,很难支撑图像、语音等相关的任务。

-

知识建模的核心是本体构建,其目的是为了确定知识图谱能描述的知识。本体被广泛认可的定义为“共享概念模型的明确形式化规范说明”[73]。本体构建的主要方法有:IDEF5法、骨架法、TOVE法、METHONLOGY法、KACTUS法、七步法和SENSUS法等。此外,文献[74]结合隐式狄利克雷分布和关联规则算法,提出了一种半自动的领域本体构建方法。文献[75]在知识建模方面开展了深入的探索,研究了关联图谱的定义、架构以及构建的关键技术,并深度分析了关联图谱分析与研究所面临的若干挑战问题。并围绕装备目标及其关联标准知识,研究了装备−标准知识图谱建模[76]、标准化管控建模[77]以及装备标准关联图谱可视化应用[78],在此基础上,针对装备目标及其标准构建了异构信息关联图谱[79],并在此基础上定义了通用化、系列化和模块化等评价指标[80]。

-

知识提取的目的是从非结构化的文本和其他结构化或半结构化的数据源中发现和识别实体和关系。知识提取的主要任务包括实体识别与对齐、关系提取以及知识图谱补全。实体识别一直都是研究的热点问题[81-83],特别是近几年,预训练语言模型已应用于实体识别并取得了很好的识别效果和性能[84-85]。关系提取方面,不少工作者采用图卷积神经网络及其变体建模实现关系提取任务[86-89]。此外,相关的小样本与元学习问题也有相应的研究[90-93]。早期的信息抽取没有考虑到实体抽取和关系抽取两个任务之间的相关性,近年来,不少研究将两个任务进行联合建模[94-97],如文献[97]提出了一个基于跨度和图模块的混合模型KSBERT,引入领域字典、依存关系结构等外部句法、语义知识,针对特定领域的实体和关系联合抽取实现了较好的效果。知识图谱补全方面,近年来,也有不少的研究工作注意到了小样本问题,并提出了相应的解决方案[98-103]。

-

知识表征学习,也称为知识图谱嵌入[104],是使用低维向量表示实体和关系信息的过程。当前的知识表征方法根据嵌入的核心思想可分为几何表征模型和神经网络表征模型。几何表征模型将关系解释为语义空间中的几何变换,典型方法如基于莫比乌斯变换的嵌入方法[105]、KDCoE模型[106]、ATTH模型[107]、DensE模型[108]、BiQUE模型[109]、ChronoR模型[110]以及对偶四元数知识图嵌入方法[111]。神经网络表征模型方面,也取得了大量优秀的研究成果[112-120],其中,文献[119]提出了一种时序图信息的嵌入方法,然后基于图神经网络,提出了一种结合图的邻接矩阵与卷积神经网络的关键节点挖掘算法[120],可以有效地将图中节点的邻域信息嵌入到矩阵中。

-

知识应用方面,数据和知识联合驱动的方法在越来越多的领域得到了应用[121-136],这种结合已逐步成为理论指导数据科学的新模式。

文献[121]引入图搜索神经网络(graph search neural network, GSNN)有效地将大量知识图合并到视觉分类任务中,并使用这些结构化先验知识提高图像分类性能。文献[123]使用一个视觉语义嵌入模型,从知识库和文本中挖掘语义嵌入,并进一步训练一个端到端CNN框架,从而将图像特征线性映射到丰富的语义嵌入空间。文献[124]使用包含外部知识的显式知识模块和隐式知识模块实现知识的学习,融合知识整合模块与目标检测网络,利用全局推理提高目标检测性能。文献[125]在给定一个已学习的知识图谱下,将每个节点(即视觉类别)的语义嵌入作为输入,经过一系列图卷积,预测每个类别的视觉分类器。文献[127]使用GCN训练知识图谱,并将其用于小样本甚至零样本的动作识别任务。文献[128]利用一幅图像中所有对象对之间的视觉上下文关系和几何关系(关系信息由关系知识图谱定义),捕获有用的信息来推断不可见类别,并使用条件随机场将该方法集成到传统的零样本学习方法中。文献[129]以结构化的知识图谱形式表示语义关联,并将该图谱集成到深度神经网络中,通过知识图谱迁移网络(knowledge graph transfer network, KGTN)实现小样本学习。文献[132]提出了知识传输网络(knowledge transfer network, KTN)体系结构,提出的框架将视觉特征学习、知识推断和分类器学习结合到一起。文献[133]提出了一种稠密图传播(dense graph propagation, DGP)模块,利用知识图谱提供的类别语义描述及关系信息扩展原有的图像分类器,使之能够适应新类别。文献[135]提出了一种图的小样本学习算法,融合了从辅助图中学习的先验知识,同时在图之间传输节点级和图级结构。文献[136]通过语义嵌入,由语义之间的差距生成用于属性传播网络的语义知识图谱,随后使用注意力机制进行图像分类。

-

早期的基于显式知识的建模方法、当前广泛使用的基于隐式知识的建模方法,以及现阶段基于融合知识的建模方法都存在各自的局限性。因此,文献[137]提出发展“第三代人工智能”,即融合知识驱动和数据驱动的人工智能模型,利用知识、数据、算法和算力4个要素,建立新的可解释和鲁棒的人工智能理论与方法。

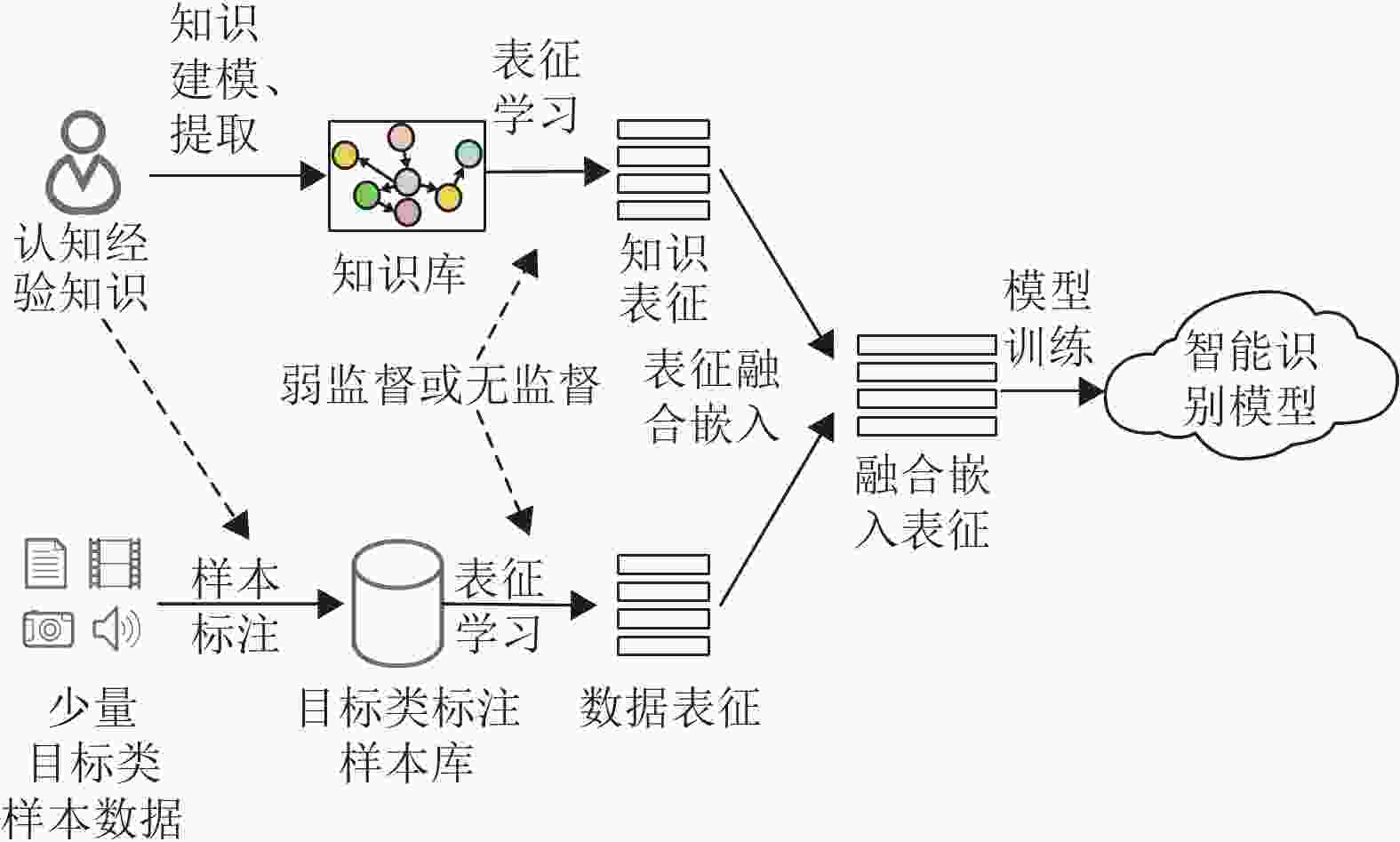

新一代的知识和数据联合驱动建模方式本质上属于融合知识建模方式,但不再寻求语义符号空间和特征向量空间的相互映射,而是将其分别映射到同一个连续的高维空间并进行融合,即将特征向量空间以及语言符号空间融合映射到同一个连续的类语义空间中,在此空间中完成语义符号和特征向量的关联融合。一种知识和数据的联合驱动建模方式如图6所示。

认知经验知识和数据分别通过弱监督或无监督的方式进行表征学习,学习到的表征模型能够将知识或数据映射到各自的向量空间,然后通过表征融合模型,将两个空间进行融合嵌入,最后基于融合表征进行建模。

相比于显式知识建模方法,知识将不再建模为具体的规则语句,而是建模为图谱等形式。相比于规则化的语句,图谱更容易映射、转换为连续数值进行计算,且能够表达更为复杂的逻辑关系,并进行一定程度的推理。此外,本文提出的建模方式解耦了认知经验知识的建模和数据表征的建模,根据实际情况可选择联合驱动建模,也可以选择单一途径(只有经验知识或只有数据)进行建模,一定程度上兼容了基于显式知识的建模方法和基于隐式知识的建模方法,同时也克服了显式知识建模方法和隐式知识建模方法的局限性。

采用知识和数据联合驱动建模的工作还鲜有报道,其有效性还有待进行更多的实践验证。此外,如何根据模型的输出,有效追溯到认知知识,使得模型输出和中间特征可解释,也还有待进一步研究与探索。

-

当前,无论是小样本深度学习还是基于数据挖掘的知识驱动技术都已经引起了学术界的广泛关注。这个方向的兴起,既来源于学术界对人工智能接近人类智能的追求,又受到工业界对廉价机器学习的需求推动。在此背景下,本文提出了一种模型构建方法的分类标准;然后对每类构建方法在解决小样本、模型可解释性问题方面的探索进行了综述总结;最后,设想了一种知识与数据联合驱动建模方式。

目前,对知识与数据联合驱动的识别技术研究已取得许多极具价值的成果,尽管如此,以下几方面还需进一步研究。

1)现有的小样本深度学习方法先验知识的来源途径有限,本质上仍然依赖与目标类相似或同质的海量样本,仅转移了海量数据的需求方向。

2)元学习得到的类语义空间无法与真实语义符号空间关联,导致模型可解释性不高,难以有效实现知识的持续积累和更新扩展。

3)当前基于数据挖掘的知识驱动方法都还依赖于海量的标注数据,仅在知识的应用层考虑了小样本的情况,如何在小样本或零样本情况下生成知识还有待进一步研究。

4)虽然在知识图谱领域,利用自然语言文本提取实体、关系与属性构建知识库已有大量研究,但是这类知识库往往是为了解决语义搜索和语义理解相关应用而构建的,而面向目标识别应用的知识库还没有得到很好的研究。

5)在知识与数据联合驱动模型中,知识的质量如何度量,知识的质量与数据的质量如何影响模型,以及二者产生的交互效应,还缺乏定性和定量的研究。

A Review of Modeling Techniques Jointly Driven by Knowledge and Data

-

摘要: 当前,基于深度学习的目标识别建模技术面临标注样本不足、模型可解释性不高、稳定性不够等新的挑战,限制了深度学习解决更复杂、更抽象问题的可能性。采用知识与数据联合驱动的方式进行智能模型构建是突破现有瓶颈的一条重要途径。该文以外部经验与认知知识在模型构建中的引入方式为区分准则,提出了模型构建方法的分类标准,包括基于显式知识的建模方法、基于隐式知识的建模方法以及基于融合知识的建模方法;然后围绕每类方法在解决小样本、模型可解释性等问题上的探索进行综述,并总结设想了一种未来的知识与数据联合驱动建模方式。这种方式吸取了不同建模方式的优点,通过解耦知识建模与数据建模,以无监督、弱监督为核心训练方式,可以有效解决小样本条件下模型构建问题,提高模型可解释性。最后,该文总结了需要进一步研究的问题和未来的研究方向,以促进目标识别模型构建技术的发展。Abstract: In recent years, object recognition modeling techniques based on deep learning face new challenges such as insufficient annotated samples, low interpretability of models, and insufficient stability. All these challenges limit the possibility of deep learning to solve more complex and abstract problems. Constructing intelligent model jointly driven by knowledge and data is an important way to break through the existing bottleneck. This paper presents a classification standard of model constructing methods according to the way of introduction of external experience and cognitive knowledge during model constructing, including modeling methods based on explicit knowledge, modeling methods based on implicit knowledge and modeling methods based on fusion knowledge. Then, following the proposed classification standard, the explorations in each class of methods about solving the problems of few samples and model interpretability are reviewed. Subsequently, taking advantage of different model constructing methods, a future model constructing method jointly driven by knowledge and data is proposed. The proposed method can effectively solve the problem of model construction under the condition of few samples and improve the interpretability of the model by decoupling knowledge modeling and data modeling and taking unsupervised and weak supervised training as the core training patterns. Finally, some research issues which need further study as well as future research directions are drawn in conclusion for promote the object recognition model constructing.

-

[1] KRIZHEVSKY A, SUTSKEVER I, HINTON G E. Imagenet classification with deep convolutional neural networks[J]. Advances in Neural Information Processing Systems, 2012, 25: 1097-1105. [2] HINTON G, DENG L, YU D, et al. Deep neural networks for acoustic modeling in speech recognition: The shared views of four research groups[J]. IEEE Signal Processing Magazine, 2012, 29(6): 82-97. doi: 10.1109/MSP.2012.2205597 [3] CONNEAU A, SCHWENK H, BARRAULT L, et al. Very deep convolutional networks for text classification[C]//European Chapter of the Association for Computational Linguistics. Stroudsburg, PA: ACL, 2017(1): 1107-1116. [4] SIMON H A. Models of man: Social and rational[M]. New York: Wiley & Sons, 1957. [5] NEWELL A, SIMON H A. Computer science as empirical inquiry: Symbols and search[J]. Communications of the ACM, 1976, 19(3): 113-126. doi: 10.1145/360018.360022 [6] NEWELL A. Physical symbol systems[J]. Cognitive Science, 1980, 4(2): 135-183. [7] FODOR J A. Methodological solipsism considered as a research strategy in cognitive psychology[J]. Behavioral and Brain Sciences, 1980, 3(1): 63-73. doi: 10.1017/S0140525X00001771 [8] MCCARTHY J, MINSKY M L, ROCHESTER N, et al. A proposal for the Dartmouth summer research project on artificial intelligence[J]. AI Magazine, 2006, 27(4): 12. [9] LINDSAY R K, BUCHANAN B G, FEIGENBAUM E A, et al. Applications of artificial intelligence for organic chemistry: The dendral project[M]. New York: McGraw-Hill Book Company, 1980. [10] BUCHANAN B G, SHORTLIFFE E H. Rule-based expert systems: The MYCIN experiments of the stanford heuristic programming project[M]. Boston: Addison Wesley, 1984. [11] MILLER E G, MATSAKIS N E, VIOLA P A. Learning from one example through shared densities on transforms[C]//IEEE Conference on Computer Vision and Pattern Recognition. Los Alamitos, CA: IEEE Computer Society, 2000(1): 464-471. [12] KWITT R, HEGENBART S, NIETHAMMER M. One-shot learning of scene locations via feature trajectory transfer[C]//IEEE Conference on Computer Vision and Pattern Recognition. Los Alamitos, CA: IEEE Computer Society, 2016: 78-86. [13] DIXIT M, KWITT R, NIETHAMMER M, et al. AGA: Attribute-guided augmentation[C]//IEEE Conference on Computer Vision and Pattern Recognition. Los Alamitos, CA: IEEE Computer Society, 2017: 7455-7463. [14] CHEN Z T, FU Y W, ZHANG Y D, et al. Multi-level semantic feature augmentation for one-shot learning[J]. IEEE Trans on Image Processing, 2019, 28(9): 4594-4605. doi: 10.1109/TIP.2019.2910052 [15] 汪航, 陈晓, 田晟兆, 等. 基于小样本学习的SAR 图像识别[J]. 计算机科学, 2020, 47(5): 124-128. doi: 10.11896/jsjkx.190400136 WANG H, CHEN X, TIAN S Z, et al. SAR image recognition based on few-shot learning[J]. Computer Science, 2020, 47(5): 124-128. doi: 10.11896/jsjkx.190400136 [16] LU J, LI J, YAN Z, et al. Attribute-based synthetic network (ABS-Net): Learning more from pseudo feature representations[J]. Pattern Recognition, 2018, 80: 129-142. doi: 10.1016/j.patcog.2018.03.006 [17] HARIHARAN B, GIRSHICK R. Low-shot visual recognition by shrinking and hallucinating features[C]//IEEE International Conference on Computer Vision. Los Alamitos, CA: IEEE Computer Society, 2017: 3018-3027. [18] SCHWARTZ E, KARLINSKY L, SHTOK J, et al. Delta-encoder: An effective sample synthesis method for few-shot object recognition[J]. Advances in Neural Information Processing Systems, 2018, 31: 2845-2855. [19] WANG Y X, GIRSHICK R, HEBERT M, et al. Low-shot learning from imaginary data[C]//IEEE Conference on Computer Vision and Pattern Recognition. Los Alamitos, CA: IEEE Computer Society, 2018: 7278-7286. [20] GAO H, SHOU Z, ZAREIAN A, et al. Low-shot learning via covariance-preserving adversarial augmentation networks[J]. Advances in Neural Information Processing Systems, 2018, 31: 975-985. [21] ANTONIOU A, STORKEY A, EDWARDS H. Data augmentation generative adversarial networks[EB/OL]. [2022-08-28]. https://arxiv.org/abs/1711.04340. [22] CHEN Z, FU Y W, WANG Y X, et al. Image deformation meta-networks for one-shot learning[C]//IEEE/CVF Conference on Computer Vision and Pattern Recognition. Los Alamitos, CA: IEEE Computer Society, 2019: 8680-8689. [23] LUO Q X, WANG L F, LV J G, et al. Few-shot learning via feature hallucination with variational inference[C]//IEEE Winter Conference on Applications of Computer Vision. Los Alamitos, CA: IEEE Computer Society, 2021: 3962-3971. [24] YANG S, WU S H, LIU T L, et al. Bridging the gap between few-shot and many-shot learning via distribution calibration[J]. IEEE Trans on Pattern Analysis and Machine Intelligence, 2022, 44(12): 9830-9843. doi: 10.1109/TPAMI.2021.3132021 [25] CHI Z Q, WANG Z, YANG M P, et al. Learning to capture the query distribution for few-shot learning[J]. IEEE Trans on Circuits and Systems for Video Technology, 2021, 32(7): 4163-4173. [26] LAZAROU M, STATHAKI T, AVRITHIS Y. Tensor feature hallucination for few-shot learning[C]//IEEE/CVF Winter Conference on Applications of Computer Vision. Piscataway, NJ: IEEE, 2022: 3500-3510. [27] TIAN S Z, CHEN D B. Attention based data augmentation for knowledge distillation with few data[C]//Journal of Physics: Conference Series. Bristol, England: IOP Publishing, 2022(2171): 012058. [28] SOHN K, BERTHELOT D, CARLINI N, et al. Fixmatch: Simplifying semi-supervised learning with consistency and confidence[J]. Advances in Neural Information Processing Systems, 2020, 33: 596-608. [29] CHEN T, KORNBLITH S, NOROUZI, et al. A simple framework for contrastive learning of visual representations[C]//International Conference on Machine Learning. New York: ACM, 2020: 1597-1607. [30] CHEN T, KORNBLITH S, SWERSKY K, et al. Big self-supervised models are strong semi-supervised learners[J]. Advances in Neural Information Processing Systems, 2020, 33: 22243-22255. [31] KOCH G, ZEMEL R, SALAKHUTDINOV R. Siamese neural networks for one-shot image recognition[C]//International Conference on Machine Learning. New York: ACM, 2015(2): 1-30. [32] YE M, GUO Y H. Deep triplet ranking networks for one-shot recognition[EB/OL]. [2022-09-15]. https://doi.org/10.48550/arXiv.1804.07275. [33] SNELL J, SWERSKY K, ZEMEL R. Prototypical networks for few-shot learning[C]//Conference on Neural Information Processing Systems. Cambridge, MA: MIT Press, 2017: 4077-4087. [34] DVORNIK N, SCHMID C, MAIRAL J. Diversity with cooperation: Ensemble methods for few-shot classification[C]//IEEE/CVF International Conference on Computer Vision. Los Alamitos, CA: IEEE Computer Society, 2019: 3723-3731. [35] HAO F S, CHENG J, WANG L, et al. Instance-level embedding adaptation for few-shot learning[J]. IEEE Access, 2019, 7: 100501-100511. doi: 10.1109/ACCESS.2019.2906665 [36] HU P, SUN X M, SAENKO K, et al. Weakly-supervised compositional feature aggregation for few-shot recognition[EB/OL]. [2022-09-15]. https://doi.org/10.48550/arXiv.1906.04833. [37] ZHENG Y, WANG R G, YANG J, et al. Principal characteristic networks for few-shot learning[J]. Journal of Visual Communication and Image Representation, 2019, 59: 563-573. doi: 10.1016/j.jvcir.2019.02.006 [38] VINYALS O, BLUNDELL C, LILLICRAP T, et al. Matching networks for one shot learning[C]//Conference on Neural Information Processing Systems. Cambridge, MA: MIT Press, 2016: 3630-3638. [39] BARTUNOV S, VETROV D. Few-shot generative modelling with generative matching networks[C]//International Conference on Artificial Intelligence and Statistics. Brookline, MA: Microtome Publishing, 2018: 670-678. [40] CAI Q, PAN Y W, YAO T, et al. Memory matching networks for one-shot image recognition[C]//IEEE/CVF Conference on Computer Vision and Pattern Recognition. Los Alamitos, CA: IEEE Computer Society, 2018: 4080-4088. [41] ZHANG L L, LIU J, LUO M N, et al. Scheduled sampling for one-shot learning via matching network[J]. Pattern Recognition, 2019, 96: 106962. doi: 10.1016/j.patcog.2019.07.007 [42] SUNG F, YANG Y X, ZHANG L, et al. Learning to compare: Relation network for few-shot learning[C]//IEEE/CVF Conference on Computer Vision and Pattern Recognition. Los Alamitos, CA: IEEE Computer Society, 2018: 1199-1208. [43] HILLIARD N, PHILLIPS L, HOWLAND S, et al. Few-shot learning with metric-agnostic conditional embeddings[EB/OL]. [2022-09-15]. https://doi.org/10.48550/arXiv.1802.04376. [44] ZHANG X T, SUNG F, QIANG Y T, et al. RelationNet2: Deep comparison network for few-shot learning[C]//International Joint Conference on Neural Networks. Los Alamitos, CA: IEEE Computer Society, 2020: 1-8. [45] LI W B, XU J L, HUO J, et al. Distribution consistency based covariance metric networks for few-shot learning[C]//AAAI Conference on Artificial Intelligence. Palo Alto, CA: AAAI, 2019, 33(1): 8642-8649. [46] LI W B, WANG L, XU J L, et al. Revisiting local descriptor based image-to-class measure for few-shot learning[C]//IEEE/CVF Conference on Computer Vision and Pattern Recognition. Los Alamitos, CA: IEEE Computer Society, 2019: 7260-7268. [47] ZHANG H G, KONIUSZ P. Power normalizing second-order similarity network for few-shot learning[C]//IEEE Winter Conference on Applications of Computer Vision. Los Alamitos, CA: IEEE Computer Society, 2019: 1185-1193. [48] HUI B Y, ZHU P F, HU Q H, et al. Self-attention relation network for few-shot learning[C]//IEEE International Conference on Multimedia and Expo Workshops. Piscataway, NJ: IEEE, 2019: 198-203. [49] LI W B, WANG L, HUO J, et al. Asymmetric distribution measure for few-shot learning[C]//International Joint Conference on Artificial Intelligence. San Francisco, CA: Margan Kaufmann, 2021: 2957-2963. [50] DONG C Q, LI W B, HUO J, et al. Learning task-aware local representations for few-shot learning[C]//International Joint Conference on Artificial Intelligence. San Francisco, CA: Margan Kaufmann, 2021: 716-722. [51] 汪航, 田晟兆, 唐青, 等. 基于多尺度标签传播的小样本图像分类[J]. 计算机研究与发展, 2022, 59(7): 1486-1495. WANG H, TIAN S Z, TANG Q, et al. Few-shot image classification based on multi-scale label propagation[J]. Journal of Computer Research and Development, 2022, 59(7): 1486-1495. [52] SANTORO A, BARTUNOV S, BOTVINICK M, et al. Meta-learning with memory-augmented neural networks[C]//International Conference on Machine Learning. New York: ACM, 2016: 1842-1850. [53] SHYAM P, GUPTA S, DUKKIPATI A. Attentive recurrent comparators[C]//International Conference on Machine Learning. New York: ACM, 2017: 3173-3181. [54] MISHRA N, ROHANINEJAD M, CHEN X, et al. A simple neural attentive meta-learner[EB/OL]. [2022-09-15]. https://doi.org/10.48550/arXiv.1707.03141. [55] ZHANG L, ZUO L Y, DU Y J, et al. Learning to adapt with memory for probabilistic few-shot learning[J]. IEEE Trans on Circuits and Systems for Video Technology, 2021, 31(11): 4283-4292. doi: 10.1109/TCSVT.2021.3052785 [56] WANG H, CHEN D B. Few-shot image classification based on ensemble metric learning[C]//Journal of Physics: Conference Series. Bristol, England: IOP Publishing, 2022(2171): 012027. [57] DW G D A. DARPA’s explainable artificial intelligence program[J]. AI Magazine, 2019, 40(2): 44. doi: 10.1609/aimag.v40i2.2850 [58] GUNNING D, VORM E, WANG J Y, et al. DARPA’s explainable AI (XAI) program: A retrospective[J]. Applied AI Letters, 2021, 2(4): e61. doi: 10.1002/ail2.61 [59] CLANCEY W J, HOFFMAN R R. Methods and standards for research on explainable artificial intelligence: Lessons from intelligent tutoring systems[J]. Applied AI Letters, 2021, 2(4): e53. doi: 10.1002/ail2.53 [60] MURDOCH W J, SINGH C, KUMBIER K, et al. Definitions, methods, and applications in interpretable machine learning[J]. Proceedings of the National Academy of Sciences, 2019, 116(44): 22071-22080. doi: 10.1073/pnas.1900654116 [61] TJOA E, GUAN C. A survey on explainable artificial intelligence (XAI): Toward medical XAI[J]. IEEE Trans on Neural Networks and Learning Systems, 2020, 32(11): 4793-4813. [62] HOU B J, ZHOU Z H. Learning with interpretable structure from gated RNN[J]. IEEE Trans on Neural Networks and Learning Systems, 2020, 31(7): 2267-2279. [63] VILONE G, LONGO L. Explainable artificial intelligence: A systematic review[EB/OL]. [2022-09-15]. https://doi.org/10.48550/arXiv.2006.00093. [64] ISLAM S R, EBERLE W, GHAFOOR S K, et al. Explainable artificial intelligence approaches: A survey[EB/OL]. [2022-09-22]. https://doi.org/10.48550/arXiv.2101.09429. [65] BURKART N, HUBER M F. A survey on the explainability of supervised machine learning[J]. Journal of Artificial Intelligence Research, 2021, 70: 245-317. doi: 10.1613/jair.1.12228 [66] AKULA A R, WANG K Z, LIU C S, et al. CX-ToM: Counterfactual explanations with theory-of-mind for enhancing human trust in image recognition models[J]. Iscience, 2022, 25(1): 103581. doi: 10.1016/j.isci.2021.103581 [67] CHEN X, DUAN Y, HOUTHOOFT R, et al. InfoGAN: Interpretable representation learning by information maximizing generative adversarial nets[C]//Conference on Neural Information Processing Systems. Cambridge, MA: MIT Press, 2016: 2172-2180. [68] LIU Y, WEI F Y, SHAO J, et al. Exploring disentangled feature representation beyond face identification[C]//IEEE/CVF Conference on Computer Vision and Pattern Recognition. Los Alamitos, CA: IEEE Computer Society, 2018: 2080-2089. [69] HIGGINS I, MATTHEY L, PAL A, et al. Beta-VAE: Learning basic visual concepts with a constrained variational framework[C]//International Conference on Learning Representations. Ithaca, NY: [s.n.], 2016: 1-12. [70] SIDDHARTH N, PAIGE B, DESMAISON A, et al. Inducing interpretable representations with variational autoencoders[EB/OL]. [2022-09-15]. https://doi.org/10.48550/arXiv.1611.07492. [71] LI C X, XU K, ZHU J, et al. Triple generative adversarial nets[C]//Conference on Neural Information Processing Systems. Cambridge, MA: MIT Press, 2017: 4088-4098. [72] HU X L, ZHANG J W, LI J M, et al. Sparsity-regularized HMAX for visual recognition[J]. PLoS One, 2014, 9: e81813. doi: 10.1371/journal.pone.0081813 [73] GRUBER T R. Toward principles for the design of ontologies used for knowledge sharing?[J]. International Journal of Human-Computer Studies, 1995, 43(5-6): 907-928. doi: 10.1006/ijhc.1995.1081 [74] LIU J F, DONG Y, LIU Z X, et al. Applying ontology learning and multi-objective ant colony optimization method for focused crawling to meteorological disasters domain knowledge[J]. Expert Systems with Applications, 2022, 198: 116741. doi: 10.1016/j.eswa.2022.116741 [75] 尹亮, 袁飞, 谢文波, 等. 关联图谱的研究进展及面临的挑战[J]. 计算机科学, 2018, 45(S1): 1-10. YIN L, YUAN F, XIE W B, et al. Research progress and challenges on association graph[J]. Computer Science, 2018, 45(S1): 1-10. [76] 尹亮, 何明利, 谢文波, 等. 装备-标准知识图谱的过程建模研究[J]. 计算机科学, 2018, 45(S1): 502-505. YIN L, HE M L, XIE W B, et al. Process modeling on knowledge graph of equipment and standard[J]. Computer Science, 2018, 45(S1): 502-505. [77] 尹亮, 何明利, 谢文波, 等. 基于装备标准关联图谱的标准化管控建模[J]. 装甲兵工程学院学报, 2018, 32(1): 38-41. YIN L, HE M L, XIE W B, et al. Standardization management and control modeling based on correlative graph of equipment standards[J]. Journal of Academy of Armored Force Engineering, 2018, 32(1): 38-41. [78] 史力晨, 赵俊严, 谢文波, 等. 装备标准关联图谱建模与可视化应用研究[J]. 系统仿真学报, 2017, 29(S1): 39-44. SHI L C, ZHAO J Y, XIE W B, et al. Research on modeling and visualization of equipment-standard association graph[J]. Journal of System Simulation, 2017, 29(S1): 39-44. [79] YIN L, SHI L C, ZHAO J Y, et al. Heterogeneous information network model for equipment-standard system[J]. Physica A: Statistical Mechanics and its Applications, 2018, 490: 935-943. doi: 10.1016/j.physa.2017.08.055 [80] YIN L, HE M L, XIE W B, et al. A quantitative model of universalization, serialization and modularization on equipment systems[J]. Physica A: Statistical Mechanics and its Applications, 2018, 508: 359-366. doi: 10.1016/j.physa.2018.05.120 [81] XIA C Y, ZHANG C W, YANG T, et al. Multi-grained named entity recognition[C]//Annual Meeting of the Association for Computational Linguistics. New York: ACM, 2019: 1430-1440. [82] HU A W, DOU Z C, NIE J Y, et al. Leveraging multi-token entities in document-level named entity recognition[C]//AAAI Conference on Artificial Intelligence. Palo Alto, CA: AAAI, 2020, 34(5): 7961-7968. [83] LI X Y, FENG J R, MENG Y X, et al. A unified MRC framework for named entity recognition[C]//Annual Meeting of the Association for Computational Linguistics. New York: ACM, 2020: 5849-5859. [84] SUN Y, WANG S H, LI Y K, et al. Ernie 2.0: A continual pre-training framework for language understanding[C]//AAAI Conference on Artificial Intelligence. Palo Alto, CA: AAAI, 2020, 34(5): 8968-8975. [85] QIU X, SUN T, XU Y, et al. Pre-trained models for natural language processing: A survey[J]. Science China Technological Sciences, 2020, 63(10): 1872-1897. [86] ZHANG Y H, QI P, MANNING C D. Graph convolution over pruned dependency trees improves relation extraction[C]//Conference on Empirical Methods in Natural Language Processing. Stroudsburg, PA: ACL, 2018: 2205-2215. [87] ZHAO Y, WAN H Y, GAO J W, et al. Improving relation classification by entity pair graph[C]//Asian Conference on Machine Learning. Cambridge, MA: MITPress, 2019: 1156-1171. [88] GUO Z J, ZHANG Y, LU W. Attention guided graph convolutional networks for relation extraction[C]//Annual Meeting of the Association for Computational Linguistics. Stroudsburg, PA: ACL, 2019: 241-251. [89] ZHANG N Y, DENG S M, SUN Z L, et al. Long-tail relation extraction via knowledge graph embeddings and graph convolution networks[C]//North American Chapter of the Association for Computational Linguistics. Stroudsburg, PA: ACL, 2019: 3016-3025. [90] LIU T Y, ZHANG X S, ZHOU W H, et al. Neural relation extraction via inner-sentence noise reduction and transfer learning[C]//Conference on Empirical Methods in Natural Language Processing. Stroudsburg, PA: ACL, 2018: 2195-2204. [91] LI Z G, CHEN H, QI R H, et al. DocR-BERT: document-level R-BERT for chemical-induced disease relation extraction via Gaussian probability distribution[J]. IEEE Journal of Biomedical and Health Informatics, 2022, 26(3): 1341-1352. doi: 10.1109/JBHI.2021.3116769 [92] GAO T Y, HAN X, LIU Z Y, et al. Hybrid attention-based prototypical networks for noisy few-shot relation classification[C]//AAAI Conference on Artificial Intelligence. Palo Alto, CA: AAAI, 2019, 33(1): 6407-6414. [93] QU M, GAO T Y, XHONNEUX L P, et al. Few-shot relation extraction via bayesian meta-learning on relation graphs[C]//International Conference on Machine Learning. New York: ACM, 2020: 7867-7876. [94] NGUYEN D Q, VERSPOOR K. End-to-end neural relation extraction using deep biaffine attention[C]//European Conference on Information Retrieval. Berlin: Springer, 2019: 729-738. [95] BEKOULIS G, DELEU J, DEMEESTER T, et al. Joint entity recognition and relation extraction as a multi-head selection problem[J]. Expert Systems with Applications, 2018, 114: 34-45. doi: 10.1016/j.eswa.2018.07.032 [96] LI X Y, YIN F, SUN Z J, et al. Entity-relation extraction as multi-turn question answering[C]//Annual Meeting of the Association for Computational Linguistics. Stroudsburg, PA: ACL, 2019: 1340-1350. [97] DING K, LIU S S, ZHANG Y H, et al. A knowledge-enriched and span-based network for joint entity and relation extraction[J]. CMC-Computers Materials & Continua, 2021, 68(1): 377-389. [98] XIONG W H, YU M, CHANG S Y, et al. One-shot relational learning for knowledge graphs[C]//Conference on Empirical Methods in Natural Language Processing. Stroudsburg, PA: ACL, 2018: 1980-1990. [99] LV X, GU Y X, HAN X, et al. Adapting meta knowledge graph information for multi-hop reasoning over few-shot relations[C]//Conference on Empirical Methods in Natural Language Processing. Stroudsburg, PA: ACL, 2019: 3376-3381. [100] CHEN M Y, ZHANG W, ZHANG W, et al. Meta relational learning for few-shot link prediction in knowledge graphs[C]//Conference on Empirical Methods in Natural Language Processing. Stroudsburg, PA: ACL, 2019: 4217-4226. [101] ZHANG C X, YAO H X, HUANG C, et al. Few-shot knowledge graph completion[C]//AAAI Conference on Artificial Intelligence. Palo Alto, CA: AAAI, 2020, 34(3): 3041-3048. [102] QIN P D, WANG X, CHEN W H, et al. Generative adversarial zero-shot relational learning for knowledge graphs[C]//AAAI Conference on Artificial Intelligence. Palo Alto, CA: AAAI, 2020, 34(5): 8673-8680. [103] BAEK J, LEE D B, HWANG S J. Learning to extrapolate knowledge: Transductive few-shot out-of-graph link prediction[C]//Conference on Neural Information Processing Systems. Cambridge, MA: MIT Press, 2020, 33: 546-560. [104] JI S X, PAN S R, CAMBRIA E, et al. A survey on knowledge graphs: Representation, acquisition, and applications[J]. IEEE Trans on Neural Networks and Learning Systems, 2021, 33(2): 494-514. [105] NAYYERI M, VAHDATI S, AYKUL C, et al. 5* knowledge graph embeddings with projective transformations[C]//AAAI Conference on Artificial Intelligence. Palo Alto, CA: AAAI, 2021, 35(10): 9064-9072. [106] CHEN M H, TIAN Y T, CHANG K W, et al. Co-training embeddings of knowledge graphs and entity descriptions for cross-lingual entity alignment[C]//International Joint Conference on Artificial Intelligence. San Francisco, CA: Margan Kaufmann, 2018: 3998-4004. [107] CHAMI I, WOLF A, JUAN D C, et al. Low-dimensional hyperbolic knowledge graph embeddings[C]//Annual Meeting of the Association for Computational Linguistics. Stroudsburg, PA: ACL, 2020: 6901-6914. [108] LU H N, HU H L, LIN X D. DensE: An enhanced non-commutative representation for knowledge graph embedding with adaptive semantic hierarchy[J]. Neurocomputing, 2022, 476: 115-125. doi: 10.1016/j.neucom.2021.12.079 [109] GUO J, KOK S. BiQUE: Biquaternionic embeddings of knowledge graphs[C]//Conference on Empirical Methods in Natural Language Processing. Stroudsburg, PA: ACL, 2021: 8338-8351. [110] SADEGHIAN A, ARMANDPOUR M, COLAS A, et al. ChronoR: Rotation based temporal knowledge graph embedding[C]//AAAI Conference on Artificial Intelligence. Palo Alto, CA: AAAI, 2021, 35(7): 6471-6479. [111] CAO Z S, XU Q Q, YANG Z Y, et al. Dual quaternion knowledge graph embeddings[C]//AAAI Conference on Artificial Intelligence. Palo Alto, CA: AAAI, 2021, 35(8): 6894-6902. [112] REN H Y, LESKOVEC J. Beta embeddings for multi-hop logical reasoning in knowledge graphs[C]//Conference on Neural Information Processing Systems. Cambridge, MA: MIT Press, 2020: 19716-19726. [113] WANG P F, HAN J L, LI C L, et al. Logic attention based neighborhood aggregation for inductive knowledge graph embedding[C]//AAAI Conference on Artificial Intelligence. Palo Alto, CA: AAAI, 2019, 33(1): 7152-7159. [114] LIU W J, ZHOU P, ZHAO Z, et al. K-bert: Enabling language representation with knowledge graph[C]//AAAI Conference on Artificial Intelligence. Palo Alto, CA: AAAI, 2020, 34(3): 2901-2908. [115] CHEN S X, LIU X D, GAO J F, et al. HittER: Hierarchical transformers for knowledge graph embeddings[C]//Conference on Empirical Methods in Natural Language Processing. Stroudsburg, PA: ACL, 2021: 10395-10407. [116] ZHANG Y, WANG J, YU L C, et al. MA-BERT: Learning representation by incorporating multi-attribute knowledge in transformers[C]//Annual Meeting of the Association for Computational Linguistics. Stroudsburg, PA: ACL, 2021: 2338-2343. [117] WANG P, XIE X, WANG X H, et al. Reasoning through memorization: Nearest neighbor knowledge graph embeddings[C]//International Conference on Natural Language Processing and Chinese Computing. Cham, Switzerland: Springer Nature, 2023: 111-122. [118] CHE F, ZHANG D, TAO J, et al. ParamE: Regarding neural network parameters as relation embeddings for knowledge graph completion[C]//AAAI Conference on Artificial Intelligence. Palo Alto, CA: AAAI, 2020, 34(3): 2774-2781. [119] YU E Y, FU Y, CHEN X, et al. Identifying critical nodes in temporal networks by network embedding[J]. Scientific Reports, 2020, 10(1): 1-8. doi: 10.1038/s41598-019-56847-4 [120] YU E Y, WANG Y P, FU Y, et al. Identifying critical nodes in complex networks via graph convolutional networks[J]. Knowledge-Based Systems, 2020, 198: 105893. doi: 10.1016/j.knosys.2020.105893 [121] MARINO K, SALAKHUTDINOV R, GUPTA A. The more you know: Using knowledge graphs for image classification[C]//IEEE Conference on Computer Vision and Pattern Recognition. Los Alamitos, CA: IEEE Computer Society, 2017: 2673-2681. [122] CHEN T S, LIN L, CHEN R Q, et al. Knowledge-embedded representation learning for fine-grained image recognition[C]//International Joint Conference on Artificial Intelligence. San Francisco, CA: Margan Kaufmann, 2018: 627-634. [123] XU H P, QI G L, LI J J, et al. Fine-grained image classification by visual-semantic embedding[C]//International Joint Conference on Artificial Intelligence. San Francisco, CA: Margan Kaufmann, 2018: 1043-1049. [124] JIANG C H, XU H, LIANG X D, et al. Hybrid knowledge routed modules for large-scale object detection[C]//Conference on Neural Information Processing Systems. Cambridge, MA: MIT Press, 2018: 1559-1570. [125] WANG X L, YE Y F, GUPTA A. Zero-shot recognition via semantic embeddings and knowledge graphs[C]//IEEE/CVF Conference on Computer Vision and Pattern Recognition. Los Alamitos, CA: IEEE Computer Society, 2018: 6857-6866. [126] WANG H, XU M H, NI B B, et al. Learning to combine: Knowledge aggregation for multi-source domain adaptation[C]//European Conference on Computer Vision. Berlin: Springer, 2020: 727-744. [127] GHOSH P, SAINI N, DAVIS L S, et al. All about knowledge graphs for actions[EB/OL]. [2022-09-15]. https://doi.org/10.48550/arXiv.2008.12432. [128] LUO R T, ZHANG N, HAN B Y, et al. Context-aware zero-shot recognition[C]//AAAI Conference on Artificial Intelligence. Palo Alto, CA: AAAI, 2020, 34(7): 11709-11716. [129] CHEN R Q, CHEN T S, HUI X L, et al. Knowledge graph transfer network for few-shot recognition[C]//AAAI Conference on Artificial Intelligence. Palo Alto, CA: AAAI, 2020, 34(7): 10575-10582. [130] CHEN T S, LIN L, HUI X L, et al. Knowledge-guided multi-label few-shot learning for general image recognition[J]. IEEE Trans on Pattern Analysis and Machine Intelligence, 2020, 44(3): 1371-1384. [131] HUANG H, CHEN Y W, TANG W, et al. Multi-label zero-shot classification by learning to transfer from external knowledge[EB/OL]. [2022-09-15]. https://doi.org/10.48550/arXiv.2007.15610. [132] PENG Z M, LI Z C, ZHANG J G, et al. Few-shot image recognition with knowledge transfer[C]//IEEE/CVF International Conference on Computer Vision. Los Alamitos, CA: IEEE Computer Society, 2019: 441-449. [133] KAMPFFMEYER M, CHEN Y B, LIANG X D, et al. Rethinking knowledge graph propagation for zero-shot learning[C]//IEEE/CVF Conference on Computer Vision and Pattern Recognition. Los Alamitos, CA: IEEE Computer Society, 2019: 11487-11496. [134] GARCIA V, BRUNA J. Few-shot learning with graph neural networks[EB/OL]. [2022-09-15]. https://doi.org/10.48550/arXiv.1711.04043. [135] YAO H X, ZHANG C X, WEI Y, et al. Graph few-shot learning via knowledge transfer[C]//AAAI Conference on Artificial Intelligence. Palo Alto, CA: AAAI, 2020, 34(4): 6656-6663. [136] LIU L, ZHOU T Y, LONG G D, et al. Attribute propagation network for graph zero-shot learning[C]//AAAI Conference on Artificial Intelligence. Palo Alto, CA: AAAI, 2020, 34(4): 4868-4875. [137] 张钹, 朱军, 苏航. 迈向第三代人工智能[J]. 中国科学: 信息科学, 2020, 50(9): 1281-1302. doi: 10.1360/SSI-2020-0204 ZHANG B, ZHU J, SU H. Toward the third generation of artificial intelligence[J]. Scientia Sinica Informationis, 2020, 50(9): 1281-1302. doi: 10.1360/SSI-2020-0204 -

ISSN

ISSN

下载:

下载: