Deep Learning in NLP:Methods and Applications

-

摘要: 该文围绕特征表示和模型原理,以神经网络语言模型与词向量作为深度学习与自然语言处理结合的切入点,概述了当前主要深度神经网络的模型原理和相关应用。之后综述了当前研究人员在自然语言处理热点领域上所使用的最新深度学习方法并及所取得的成果。最后总结了深度学习方法在当前自然语言处理研究应用中所遇到的瓶颈,并对未来可能的研究重点做出展望。Abstract: With the rise of deep learning waves, the full force of deep learning methods has hit the Natural Language Process (NLP) and ushered in amazing technological advances in many different application areas of NLP. In this article, we firstly present the development history, main advantages and research situation of deep learning. Secondly, in terms of both feature representation and model theory, we introduces the neural language model and word embedding as the entry point, and present an overview of modeling and implementations of Deep Neural Network (DNN). Then we focus on the newest deep learning models with their wonderful and competitive performances related to different NLP tasks. At last, we discuss and summarize the existing problems of deep learning in NLP with the possible future directions.

-

Keywords:

- deep learning /

- deep neural networks /

- language models /

- nature language process /

- word embedding

-

作为机器学习和人工智能领域发展最为迅速的研究方向,深度学习受到学术界和工业界的高度关注。深度学习是基于特征自学习和深度神经网络(DNN)的一系列机器学习算法的总称。目前深度学习的研究有了长足的发展,在传统特征选择与提取框架上取得了巨大突破,对包括自然语言处理、生物医学分析、遥感影像解译在内的诸多领域产生越来越重要的影响,并在计算机视觉和语音识别领域取得了革命性的成功。

当前,如何应用深度学习技术解决自然语言处理(NLP)相关任务是深度学习的研究热点。NLP作为计算机科学与人工智能交叉领域中的重要研究方向,综合了语言学、计算机科学、逻辑学、心理学、人工智能等学科的知识与成果。其主要研究任务包括词性标注、机器翻译、命名实体识别、机器问答、情感分析、自动文摘、句法分析和共指消解等。自然语言作为高度抽象的符号化系统,文本间的关系难以度量,相关研究高度依赖人工构建特征。而深度学习方法的优势恰恰在于其强大的判别能力和特征自学习能力,非常适合自然语言高维数、无标签和大数据的特点。为此,本文将对当前深度学习如何应用在NLP领域展开综述性讨论,并进一步分析其中的应用难点和未来可能的突破方向。

1. 深度学习研究现状

深度学习源于人工神经网络的研究。人工神经网络(artificial neural network, ANN)作为计算工具是由文献[1]引入。之后,Hebb自组织学习规则、感知机模型、Hopfield神经网络、玻尔兹曼机、误差反向传播算法和径向基神经网络等也相继被提出。文献[2]利用逐层贪心算法初始化深度信念网络,开启了深度学习的浪潮,指出深度学习的本质是一种通用的特征学习方法,其核心思想在于提取低层特征,组合形成更高层的抽象表示,以发现数据的分布规律。文献[2]的方法有效地缓解了DNN层数增加所带来的梯度消失或者梯度爆炸问题。随后文献[3]使用自动编码机取代深度信念网络的隐藏层,并通过实验证明了DNN的有效性。同时,研究发现人类信息处理机制需要从丰富的感官输入中提取复杂结构并重新构建内部表示,使得人类语言系统和感知系统都具有明显的层结构[4],这从仿生学的角度,为DNN多层网络结构的有效性提供了理论依据。

此外,深度学习的兴起还有赖于大数据和机器计算性能的提升。大数据是具有大量性、多样性、低价值密度性的数据的统称,深度学习是处理大数据常用的方法论,两者有紧密的联系。以声学建模为例,其通常面临的是十亿到千亿级别的训练样本,实验发现训练后模型处于欠拟合状态,因此大数据需要深度学习[5]。另外,随着图形处理器(graphics processing unit, GPU)的发展,有效且可扩展的分布式GPU集群的使用大大加速了深度模型的训练过程,极大地促进了深度学习在业界的使用。

目前,NLP应用逐渐成为深度学习研究中又一活跃热点。2013年,随着词向量word2vec[6]的兴起,各种词的分布式特征相关研究层出不穷。2014年开始,研究者使用不同的DNN模型,例如卷积网络,循环网络和递归网络,在包括词性标注、情感分析、句法分析等传统NLP应用上取得重大进展。2015年后,深度学习方法开始在机器翻译、机器问答、自动文摘、阅读理解等自然语言理解领域攻城略地,逐渐成为NLP的主流工具。在未来几年,深度学习将持续在自然语言理解领域做出巨大影响[7]。

2. 分布式特征表示

分布式特征表示(distributional representation)是深度学习与NLP相结合的切入点,这些分布式特征是通过神经网络语言模型学习得到的。

2.1 神经网络语言模型

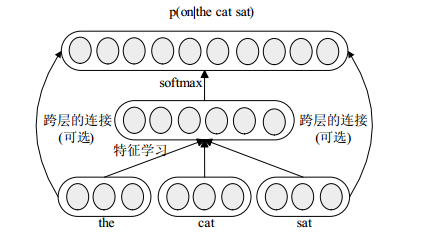

语言模型是计算任意词序在文本中出现的概率的统计模型,是NLP的基础性课题,对语音识别、词性标注、机器翻译、句法分析等研究都有至关重要的作用。神经网络生成的语言模型称为神经网络语言模型,由文献[8]提出。之后文献[9]等对神经网络语言模型进行了深入研究,其成果引起广泛关注。文献[9]构建的神经网络语言模型如图 1所示,仅有一层隐藏层络,使用softmax计算词序的概率,并通过随机梯度上升法最大惩罚似然估计以训练网络参数。

在文献[9]的基础上,文献[10]从语料中自动学习出词的层次结构,并结合受限玻尔兹曼机提出了HLBL模型。文献[11]又在文献[10]的基础上提出SENNA模型,通过对一个句子的合理性进行打分以训练词向量,在多项NLP任务上成功应用。之后文献[12]复现了HLBL模型和SENNA模型,并比较了二者的优劣。文献[13]在SENNA的基础上,对每个词向量的训练加入了相应的全局信息,并用多个词向量对应一个词以解决词的多义性问题。不同于其他人的工作,文献[6]使用了循环神经网络来训练语言模型,并在2013年开源word2vec。从HLBL模型开始,研究语言模型的目的不再是获得真正的语言模型而在于获得可用的词向量。

2.2 词向量

词向量通常指通过语言模型学习得到的词的分布式特征表示,也被称为词编码,可以非稀疏的表示大规模语料中复杂的上下文信息。目前最为人所熟知的有以下6种公开发布的词向量:HLBL、SENNA、Turian’s、Huang’s、word2vec、Glove[14]。文献[15]发现word2vec词向量间具有语义上的联系,即词向量的加减存在明显的语义关系,并在SemEval 2012 task上取得超过Turian词向量的结果,证明了word2vec的高可用性。文献[16]证明了当word2vec词向量使用skip-gram模型配合负采样技术训练时,与基于SVD的共现矩阵分解的词向量具有相同的最优解。同年文献[14]提出了Glove词向量,并证明基于矩阵的词向量可以取得远比word2vec优异的性能,但根据文献[17]提出的测评指标显示word2vec在大部分测评指标优于Glove和SENNA。除了使用词向量解决当前自然语言测评任务外,也有许多学者对词向量进行了其他广泛而深入地研究,如文献[18]研究了语种的差异对词向量的影响,文献[19]就如何生成更好的词向量进行深入讨论,文献[20]利用词向量计算了文档的相似度。

3. 深度神经网络模型

3.1 深度信念网络和堆叠自编码

深度信念网络(deep belief nets, DBN)是由受限玻尔兹曼机(restricted Boltzmann machine, RBM)堆叠而生成的一种模型。DBN通过训练网络的权重,使网络具有还原输入层训练数据的能力。DBN采用的训练步骤如下:

1) 当前层RBM为可见层则接收原始数据输入,否则接收上一层RBM的输出,并训练当前层RBM;

2) 网络总层数满足要求则执行步骤4),否则置下一层RBM为当前层;

3) 重复步骤1)和步骤2);

4) 微调网络,使用有监督学习算法将模型收敛到局部最优解。

文献[21]讨论了RBM和DBN网络的层数设置、网络泛化能力以及可能的扩展,并使用自编码器(auto-encoder, AE)取代DBN网络中每一层的RBM,由此简单堆叠数个AE得到的神经网络在文献[3]中被称为堆叠自编码网络(stacked auto-encoders, SAE)。目前SAE有两种典型的改进:1)在隐藏神经元加入稀疏性限制,使网络中大部分神经元处于抑制状态,形成稀疏自编码网络[22];2)在SAE网络的编码过程加入噪音,增加SAE网络的抗噪性,形成堆叠降噪自编码网络[23]。SAE网络由于强大的特征学习能力[24],被广泛使用在多模态检索[25]、图像分类[26]、情感分析[27]等诸多领域中。

3.2 循环神经网络与长短时记忆模型

循环神经网络(recurrent neural networks, RNN)是隐藏层和自身存在连接的一类神经网络。相较于前馈神经网络,循环神经网络可将本次隐藏层的计算结果用于下次隐藏层的计算,因此可以用来处理时间序列问题,比如文本生成[28]、机器翻译[29]和语音识别[30]。循环神经网络的优化算法为BPTT算法(backpropagation through time)[31]。由于梯度消失的原因,循环神经网络的反馈误差往往只能向后传递5~10层,因此文献[32]在循环神经网络的基础上提出长短时记忆模型(long-short term memory, LSTM)。LSTM使用Cell结构记忆之前的输入,使得网络可以学习到合适的时机重置Cell结构。LSTM有诸多结构变体,文献[33]给出了其中8种流行变体的比较。文献[34]则在超过1万种循环网络架构上进行了测试,发现并列举在某些任务上可能比LSTM更好的架构。

循环神经网络和LSTM具有许多NLP应用。文献[35]将门控循环网络用于情感分析,在IMDB等影评数据集上较SVM和CNN方法在准确率上有5%左右的提升。文献[36]使用双向LSTM网络结合卷积神经网络和条件随机场解决词性标注和命名实体识别问题,分别取得97.55%和91.21%的最好结果。

3.3 递归神经网络和卷积神经网络

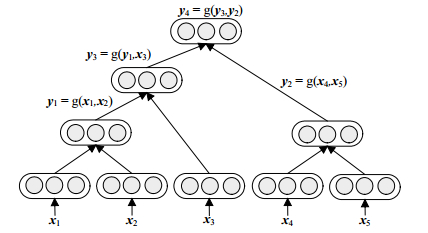

递归神经网络(recursive neural networks)是利用树形神经网络结构递归构造而成,用于构建句子语义信息的深度神经网络[37]。递归神经网络所用的树形结构一般是二叉树,典型的递归神经网络如图 2所示。对于句法分析任务,图 2中x表示词向量,y表示合并而成的子树向量。定义全局参数W,b和U,以及子树合理性评分变量s,对于合并节点(x1, x2→y1),有:

$$ {\mathit{\boldsymbol{y}}_1} = \tanh \left( {\mathit{\boldsymbol{W}}\left( {\begin{array}{*{20}{c}} {{\mathit{\boldsymbol{x}}_1}}\\ {{\mathit{\boldsymbol{x}}_2}} \end{array}} \right) + \mathit{\boldsymbol{b}}} \right) $$ (4) $$ {s_1} = {\mathit{\boldsymbol{U}}^{\rm{T}}}{\mathit{\boldsymbol{y}}_1} $$ (5) 随机初始全局参数,使用贪心算法,相邻的叶子节点(或子树)两两合并成子树并计算评分,取分最高者合并,直到最终形成句法树。句法分析任务是有标定的,即存在一个正确的句法树构造,因此训练目标是优化网络参数使得整个网络的评分损失最小。除了句法分析,递归神经网络还可用于关系分类[38]和情感分析[39]中。

卷积神经网络(convolutional neural networks, CNN)是由文献[40]提出并由文献[41]改进的深度神经网络。在一般前馈神经网络中,输入层和隐藏层之间采用全连接结构,而在CNN中每一个卷积层节点只与一个固定大小的区域有连接,连接的权重矩阵称为卷积核。池化(pooling)是CNN所采用的另一项关键技术,在固定大小的区域使用平均值或最大值代替原有的矩阵区域,既减少了特征数目又增加了网络的鲁棒性。

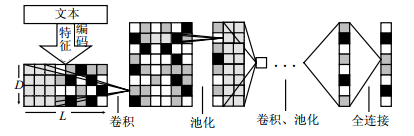

目前CNN在NLP领域的应用有许多新的尝试。文献[6]将CNN用于语义角色标注,文献[42]使用字符作为语义特征,采用大规模文本语料训练CNN模型用于本体分类、情感分析和文本分类,所用的CNN模型如图 3所示。

4. NLP应用研究进展

深度学习方法在诸多NLP领域中得到广泛应用。在机器翻译领域,文献[43]将DNN和词编码用于机器翻译,困惑度下降15%。文献[44]利用双语词向量作为特征,对应的BLEU值提升了0.48。同时用于解决机器翻译问题(如词语对齐[45]、语序问题[46])的循环神经网络也被广泛用于文本生成。文献[28]只使用字符序列训练循环神经网络文本生成器,效果接近加入了大量人工规则的文本生成系统。关于如何使用循环网络生成文本,文献[47-48]提供了丰富有趣的案例。近来,关于图片的解释性文本生成也受到广泛关注[49]。

词性标注、组块分析、语义角色标注和命名实体识别在SENNA系统[11]中给出了统一的解决框架,即基于词向量特征的深度网络判别模型。在此基础上,文献[50]将字符特征加入词性标注任务中,准确率略有提升(0.3%)。组块分析与词性标注任务类似,算法准确率的提升也已陷入瓶颈[51]。对于语义角色标注任务,文献[52]提出使用半监督学习训练词编码,有效地提升了准确率。命名实体(人名、地名、时间和数字等的识别)是许多NLP应用的基础,受到众多学者关注。相较于传统的特征工程方法[53],文献[54]使用了词和字符作为特征,并将LSTM与条件随机场相结合,采用dropout策略,在实体识别上取得了更好的识别率。

在结构句法分析上,文献[55]对比了不同递归神经网络对结构句法分析的影响,发现递归神经网络句法分析的最好效果也略逊于斯坦福大学的句法分析工具(Stanford Parser)。因此文献[38]将Stanford Parser原理与递归神经网络相结合,使得算法准确率进一步提升(0.855~0.904)。至于文本分类任务,使用字符特征和词编码的卷积网络[11]、基于张量组合的递归网络模型[39]和基于树形结构的循环网络模型[56]是当前卓有成效的混合深度网络。

机器问答是一项极其困难的NLP任务。文献[57]给出了使用神经网络求解机器问答的一般流程。文献[58]提出了记忆神经网络,以经过语义分析和人为筛选的先验事实文本为输入,有监督学习循环神经网络权重。近年来针对图像内容的多模态问答任务也受到了广泛的关注[59]。

在国内,将深度学习方法应用于NLP的研究也越来越多的受到学者的关注。文献[60]将自适应递归神经网络用于情感分析,文献[61]将情感信息直接嵌入词向量并用于情感分类,文献[62]将DBN用于代词指代消极。国内研究团队也不约而同地使用深度学习解决NLP热点问题。华为诺亚方舟实验室将CNN用于机器翻译[63]和多模态问答[64]。微软亚洲研究院致力于利用不同的深度网络实现机器问答、机器翻译和聊天机器人[65-67]。清华大学自然语言处理与社会人文计算实验室将深度学习方法用于机器翻译,关系抽取以及知识的分布式表示中[68-70],苏州大学自然语言组则侧重于中文信息抽取和多语情感分析[71-72]。哈工大、中科院、北京大学等高校的自然语言组也屡次在国际会议上发表高水平学术论文[73-75],越来越多的中国学者对深度学习结合NLP领域的研究做出了卓越的贡献。

5. 结束语

尽管深度学习已经在诸多应用领域取得巨大成功,但深度学习作为一项正在蓬勃发展的新兴技术,仍然有许多研究难点需要攻克。其中最大的瓶颈在于,除了仿生学的角度,目前深度学习的理论依据还处于起步阶段,大部分的研究成果都是经验性的,没有足够的理论来指导实验,研究者无法确定网络架构、超参数设置是否已是最优的组合。除此之外,目前仍没一种通用的深度网络或学习策略可以适用于大多数的应用任务,因此深度学习领域的研究者正在不断尝试新的网络架构和学习策略,以提升网络的泛化性能。

目前,深度学习用于NLP领域的主要步骤可以归结为如下3步:1)将原始文本作为输入,自学习得到文本特征的分布表示。2)将分布式向量特征作为深度神经网络的输入。3)针对不同的应用需求,使用不同的深度学习模型,有监督的训练网络权重。目前深度学习结合NLP的应用前景及其广泛。深度学习模型在文法分析和信息抽取等研究的基础上,被灵活地运用在多语言机器翻译、机器问答、多模态应用、聊天机器人等一系列自然语言任务上。

然而深度学习在NLP研究上尚未取得像语音识别和计算机视觉那样巨大的成功。本文认为深度学习方法在NLP应用上的难点和可能的突破统一于以下4个方面:1)可广泛适用于不同NLP任务的通用语义特征。2)超参数设置相关研究。3)新型网络架构和学习策略的提出和研究(如注意力模型[76])。4)基于自然语言的逻辑推理和多模态应用。前者将提升机器的“智能”,后者扩展“智能”的应用领域。

综上,本文认为深度学习方法在NLP领域已经有许多很有价值的尝试,在不久的将来,将取得更大的成功。但未来依旧充满了挑战,值得更多的研究者进行广泛而深入地研究。

-

[1] LANDAHL H D, MCCULLOCH W S, PITTS W. A statistical consequence of the logical calculus of nervous nets[J]. Bulletin of Mathematical Biology, 1943, 5(4):135-137. DOI: 10.1007/BF02478260

[2] HINTON G E, SALAKHUTDINOV R R. Reducing the dimensionality of data with neural networks[J]. Science, 2006, 313(5786):504-507. DOI: 10.1126/science.1127647

[3] BENGIO Y, LAMBLIN P, POPOVICI D, et al. Greedy layer-wise training of deep networks[C]//Proceedings of NIPS. Vancouver, Canada:MIT Press, 2007:153-160. DOI: 10.1007/BF02478260

[4] MATSUGU M, MORI K, MITARI Y, et al. Subject independent facial expression recognition with robust face detection using a convolutional neural network[J]. Neural Networks, 2003, 16(5):555-559. http://europepmc.org/abstract/MED/12850007

[5] 余凯, 贾磊, 陈雨强, 等.深度学习的昨天、今天和明天[J].计算机研究与发展, 2013, 9:1799-1804. DOI: 10.7544/issn1000-1239.2013.20131180 YU Kai, JIA Lei, CHEN Yu-qiang, et al. Deep learning:Yesterday, today, and tomorrow[J]. Journal of Computer Research and Development, 2013, 9:1799-1804. DOI: 10.7544/issn1000-1239.2013.20131180

[6] MIKOLOV T, CHEN K, CORRADO G, et al. Efficient estimation of word representations in vector space[C]//Proceedings of ICLR. Scottsdale, Arizona, USA:arXiv Press, 2013:1301.3781. http://arxiv.org/abs/1301.3781

[7] LECUN Y, BENGIO Y, HINTON G. Deep learning[J]. Nature, 2015, 521(7553):436-444. DOI: 10.1038/nature14539

[8] XU W, RUDNICKY A I. Can artificial neural networks learn language models?[C]//Proceedings of International Conference on Speech and Language Processing. Beijing, China:Speech Communication Press. 2000. http://cpfd.cnki.com.cn/Article/CPFDTOTAL-OGSM200010004055.htm

[9] BENGIO Y, DUCHARME R, VINCENT P, et al. A neural probabilistic language model[J]. Journal of Machine Learning Research, 2003, 3:1137-1155. https://dl.acm.org/citation.cfm?id=944966

[10] MNIH A, HINTON G E. A scalable hierarchical distributed language model[C]//Proceedings of NIPS. New York:Curran Associates Inc, 2008.

[11] COLLOBERT R, WESTON J, BOTTOU L, et al. Natural language processing (almost) from scratch[J]. The Journal of Machine Learning Research, 2011, 12:2493-2537. http://dl.acm.org/citation.cfm?id=2078183.2078186

[12] TURIAN J, RATINOV L, BENGIO Y. Word representations:a simple and general method for semisupervised learning[C]//Proceedings of ACL. Uppsala, Sweden:ACL Press, 2010:384-394. http://dl.acm.org/citation.cfm?id=1858721

[13] HUANG E H, SOCHER R, MANNING C D, et al. Improving word representations via global context and multiple word prototypes[C]//Proceedings of ACL. Jeju, Korea:ACL Press, 2012:873-882. http://dl.acm.org/citation.cfm?id=2390645

[14] PENNINGTON J, SOCHER R, MANNING C D. Glove:Global vectors for word representation[C]//Proceedings of EMNLP. Doha, Qatar:ACL Press, 2014, 14:1532-1543. https://www.researchgate.net/publication/284576917_Glove_Global_Vectors_for_Word_Representation

[15] MIKOLOV T, SUTSKEVER I, CHEN K, et al. Distributed representations of words and phrases and their compositionality[C]//Proceedings of NIPS. Nevada, USA:MIT Press, 2013:3111-3119. http://dl.acm.org/citation.cfm?id=2999959

[16] LEVY O, GOLDBERG Y. Neural word embedding as implicit matrix factorization[C]//Proceedings of NIPS. Montreal, Quebec:MIT Press, 2014:2177-2185. https://www.researchgate.net/publication/287514944_Neural_word_embedding_as_implicit_matrix_factorization

[17] SCHNABEL T, LABUTOV I, MIMNO D, et al. Evaluation methods for unsupervised word embeddings[C]//Proceedings of EMNLP. Lisbon, Portugal:ACL Press, 2015. https://www.researchgate.net/publication/301445790_Evaluation_methods_for_unsupervised_word_embeddings?ev=auth_pub

[18] AL-RFOU R, PEROZZI B, SKIENA S. Polyglot:Distributed word representations for multilingual nlp[C]//Proceedings of CoNLL. Sofia, Bulgaria:ACL Press, 2013:183. http://arxiv.org/abs/1307.1662

[19] LAI S, LIU K, XU L, et al. How to generate a good word embedding?[J]. IEEE Intelligent Systems, 2016, 31(6):5-14. DOI: 10.1109/MIS.2016.45

[20] KUSNER M, SUN Y, KOLKIN N, et al. From word embeddings to document distances[C]//Proceedings of ICML. Lille, France:Omni Press, 2015:957-966. http://dl.acm.org/citation.cfm?id=3045118.3045221

[21] Le ROUX N, BENGIO Y. Representational power of restricted Boltzmann machines and deep belief networks[J]. Neural Computation, 2008, 20(6):1631-1649. DOI: 10.1162/neco.2008.04-07-510

[22] LEE H, EKANADHAM C, NG A Y. Sparse deep belief net model for visual area V2[C]//Proceedings of NIPS. New York, USA:ACM Press, 2008:873-880. http://dl.acm.org/citation.cfm?id=2981672

[23] VINCENT P, LAROCHELLE H, BENGIO Y, et al. Extracting and composing robust features with denoising autoencoders[C]//Proceedings of ICML. New York, USA:ACM Press, 2008:1096-1103. http://dl.acm.org/citation.cfm?id=1390294

[24] GEHRING J, MIAO Y, METZE F, et al. Extracting deep bottle-neck features using stacked auto-encoders[C]//Proceedings of IEEE International Conference on Acoustics, Speech and Signal Processing. Vancouver, BC, Canada:IEEE, 2013:3377-3381. http://ieeexplore.ieee.org/document/6638284

[25] WANG W, OOI B C, YANG X, et al. Effective multimodal retrieval based on stacked auto-encoders[J]. Proceedings of the Vldb Endowment, 2014, 7(8):649-660. DOI: 10.14778/2732296

[26] XIE J, XU L, CHEN E. Image denoising and inpainting with deep neural networks[C]//Proceedings of NIPS. Nevada, USA:MIT Press, 2012:341-349. http://dl.acm.org/citation.cfm?id=2999173

[27] GLOROT X, BORDES A, BENGIO Y. Domain adaptation for large-scale sentiment classification:a deep learning approach[C]//Proceedings of ICML. Bellevue, Washington, USA:ACM Press, 2011:513-520. http://dl.acm.org/citation.cfm?id=3104547

[28] SUTSKEVER I, MARTENS J, HINTON G E. Generating text with recurrent neural networks[C]//Proceedings of ICML. Bellevue, Washington, USA:ACM Press, 2011, 1017-1024. https://www.researchgate.net/publication/221345823_Generating_Text_with_Recurrent_Neural_Networks

[29] CHO K, VAN MERRIËNBOER B, GULCEHRE C, et al. Learning phrase representations using rnn encoder-decoder for statistical machine translation[C]//Proceedings of EMNLP Processing. Doha, Qatar:ACL Press, 2014:1724-1734. http://arxiv.org/abs/1406.1078

[30] GRAVES A, JAITLY N. Towards end-to-end speech recognition with recurrent neural networks[C]//Proceedings of ICML. Bejing, China:[s.n.], 2014:1764-1772. https://www.researchgate.net/publication/288623601_Towards_end-to-end_speech_recognition_with_recurrent_neural_networks

[31] WERBOS P J. Backpropagation through time:What it does and how to do it[J]. Proceedings of the IEEE, 1990, 78(10):1550-1560. DOI: 10.1109/5.58337

[32] HOCHREITER S, SCHMIDHUBER J. Long short-term memory[J]. Neural Computation, 1997, 9(8):1735-1780. DOI: 10.1162/neco.1997.9.8.1735

[33] GREFF K, SRIVASTAVA R K, KOUTNÍK J, et al. LSTM:a search space odyssey[J]. IEEE Transactions on Neural Networks and Learning Systems, 2016, 99:1-11.

[34] JOZEFOWICZ R, ZAREMBA W, SUTSKEVER I. An empirical exploration of recurrent network architectures[C]//Proceedings of ICML. Lille, France:Omni Press, 2015:2342-2350. http://dl.acm.org/citation.cfm?id=3045367

[35] TANG D, QIN B, LIU T. Document modeling with gated recurrent neural network for sentiment classification[C]//Proceedings of EMNLP. Lisbon, Portugal:ACL Press, 2015:1422-1432. https://www.researchgate.net/publication/301446024_Document_Modeling_with_Gated_Recurrent_Neural_Network_for_Sentiment_Classification

[36] MA X, HOVY E. End-to-end sequence labeling via bi-directional lstm-cnns-crf[C]//Proceedings of ACL. Berlin, Germany:ACL Press, 2016:1064-1074. http://arxiv.org/abs/1603.01354

[37] LIU S, YANG N, LI M, et al. A recursive recurrent neural network for statistical machine translation[C]//Proceedings of EMNLP. Doha, Qatar:ACL Press, 2014:1491-1500. https://www.researchgate.net/publication/270878065_A_Recursive_Recurrent_Neural_Network_for_Statistical_Machine_Translation

[38] SOCHER R, HUVAL B, MANNING C D, et al. Semantic compositionality through recursive matrix-vector spaces[C]//Proceedings of the EMNLP-CoNLL. Jeju Island, Korea:ACL Press, 2012:1201-1211. http://dl.acm.org/citation.cfm?id=2391084

[39] SOCHER R, CHEN D, MANNING C D, et al. Reasoning with neural tensor networks for knowledge base completion[C]//Proceedings of Advances in Neural Information Processing Systems. Nevada, USA:MIT Press, 2013:926-934. http://dl.acm.org/citation.cfm?id=2999611.2999715

[40] FUKUSHIMA K. Neocognitron:a self-organizing neural network model for a mechanism of pattern recognition unaffected by shift in position[J]. Biological Cybernetics, 1980, 36(4):193-202. DOI: 10.1007/BF00344251

[41] LECUN Y, BOTTOU L, BENGIO Y, et al. Gradient-based learning applied to document recognition[J]. Proceedings of the IEEE, 1998, 86(11):2278-2324. DOI: 10.1109/5.726791

[42] ZHANG X, ZHAO J, LECUN Y. Character-level convolutional networks for text classification[C]//Proceedings of NIPS. Montreal, Quebec, Canada:MIT Press, 2015:649-657. http://arxiv.org/abs/1509.01626

[43] SCHWENK H. Continuous space translation models for phrase-based statistical machine translation[C]//Proceedings of COLING. Mumbai, India:ACL Press, 2012:1071-1080. https://www.researchgate.net/publication/270878785_Continuous_Space_Translation_Models_for_Phrase-Based_Statistical_Machine_Translation

[44] ZOU W Y, SOCHER R, CER D, et al. Bilingual word embeddings for phrase-based machine translation[C]//Proceedings of EMNLP. Seattle, USA:ACL Press, 2013:1393-1398. https://www.researchgate.net/publication/290650943_Bilingual_word_embeddings_for_phrase-based_machine_translation

[45] YANG N, LIU S, LI M, et al. Word alignment modeling with context dependent deep neural network[C]//Proceedings of ACL. Sofia, Bulgaria:ACL Press, 2013:166-175. https://www.researchgate.net/publication/270877853_Word_Alignment_Modeling_with_Context_Dependent_Deep_Neural_Network

[46] ZHANG J, LIU S, LI M, et al. Mind the gap:Machine translation by minimizing the semantic gap in embedding space[C]//AAAI Conference on Artificial Intelligence. Québec, Canada:AAAI Press, 2014. http://dl.acm.org/citation.cfm?id=2892753.2892783

[47] KARPATHY A. The unreasonable effectiveness of recurrent neural networks[EB/OL].[2015-05-21]. https://karpathy.github.io/2015/05/21/rnn-effectiveness/.

[48] 郑炜秩. 让神经网络会做唐诗[EB/OL]. [2016-02-01]. http://zhengwy.com/neural-network-for-tangshi/. ZHENG Wei-Zhi. Let the neural network write poetry of Tang Dynasty[EB/OL].[2016-02-01]. http://zhengwy.com/neural-network-for-tangshi/.

[49] KARPATHY A, LI Fei-fei. Deep visual-semantic alignments for generating image descriptions[C]//Proceedings of CVPR. Boston, USA:IEEE, 2015. http://ieeexplore.ieee.org/xpls/icp.jsp?arnumber=7298932

[50] SANTOS C D, ZADROZNY B. Learning character-level representations for part-of-speech tagging[C]//Proceedings of ICML. Beijing, China, 2014:1818-1826. http://dl.acm.org/citation.cfm?id=3045095

[51] DAHL G E, ADAMS R P, LAROCHELLE H. Training restricted boltzmann machines on word observations[C]//Proceedings of ICML. Edinburgh, UK:Omni Press, 2012:679-686. http://arxiv.org/abs/1202.5695

[52] WESTON J, RATLE F, MOBAHI H, et al. Deep learning via semi-supervised embedding[M]//Neural Networks:Tricks of the Trade.[S.l.]:Springer Heidelberg, 2012:639-655.

[53] TKACHENKO M, SIMANOVSKY A. Named entity recognition:Exploring features[C]//Proceeding of KONVENS. Vienna, Austria:Wien, 2012:118-127. http://www.oegai.at/konvens2012/proceedings/17_tkachenko12o/

[54] LAMPLE G, BALLESTEROS M, SUBRAMANIAN S, et al. Neural architectures for named entity recognition[C]//Proceedings of NAACL. San Diego, USA:ACL Press, 2016:260-270. http://arxiv.org/abs/1603.01360

[55] SOCHER R, MANNING C D, NG A Y. Learning continuous phrase representations and syntactic parsing with recursive neural networks[C]//Proceedings of the NIPS-2010 Deep Learning and Unsupervised Feature Learning Workshop. British Columbia, Canada:MIT Press, 2010:2550-2558. http://www.researchgate.net/publication/228569700_Learning_continuous_phrase_representations_and_syntactic_parsing_with_recursive_neural_networks

[56] TAI K S, SOCHER R, MANNING C D. Improved semantic representations from tree-structured long short-term memory networks[C]//Proceedings of ACL. Beijing, China:ACL Press, 2015:1556-1566. http://www.oalib.com/paper/4070890

[57] SAGARA T, HAGIWARA M. Natural language neural network and its application to question-answering system[J]. Neurocomputing, 2014, 142:201-208. DOI: 10.1016/j.neucom.2014.04.048

[58] WESTON J, CHOPRA S, BORDES A. Memory networks[C]//Proceedings of ICLR. San Diego, California, USA:arXiv Press, 2015. http://www.oalib.com/paper/4047781

[59] ANDREAS J, ROHRBACH M, DARRELL T, et al. Learning to compose neural networks for question answering[C]//Proceedings of NAACL-HLT. San Diego California, USA:ACL Press, 2016:1545-1554. http://arxiv.org/abs/1601.01705

[60] DONG L, WEI F, ZHOU M, et al. Adaptive multicomposit-ionality for recursive neural models with applications to sentiment analysis[C]//AAAI Conference on Artificial Intelligence. Québec, Canada:AAAI Press, 2014:1537-1543. https://www.researchgate.net/publication/289108770_Adaptive_multi-compositionality_for_recursive_neural_models_with_applications_to_sentiment_analysis

[61] TANG D, WEI F, QIN B, et al. Coooolll:a deep learning system for Twitter sentiment classification[C]//Proceedings of the 8th International Workshop on Semantic Evaluation. Dublin, Ireland:ACL Press, 2014:208-212. https://www.researchgate.net/publication/288013084_Coooolll_A_Deep_Learning_System_for_Twitter_Sentiment_Classification

[62] 奚雪峰, 周国栋.基于deep learning的代词指代消解[J].北京大学学报(自然科学版), 2014, 50(1):100-110. http://kns.cnki.net/KCMS/detail/detail.aspx?filename=bjdz201401015&dbname=CJFD&dbcode=CJFQ XI Xue-feng, ZHOU Guo-dong. Pronoun resolution based on deep learning[J]. Acta Scientiarum Naturalium Universitatis Pekinensis, 2014, 50(1):100-110. http://kns.cnki.net/KCMS/detail/detail.aspx?filename=bjdz201401015&dbname=CJFD&dbcode=CJFQ

[63] MENG F, LU Z, WANG M, et al. Encoding source language with convolutional neural network for machine translation[C]//Proceedings of ACL. Beijing, China:ACL Press, 2015. http://www.oalib.com/paper/4072112

[64] MA L, LU Z, LI H. Learning to answer questions from image using convolutional neural network[C]//AAAI Conference on Artificial Intelligence. Phoenix, USA:[s.n.], 2016. http://arxiv.org/abs/1506.00333

[65] DONG L, WEI F, ZHOU M, et al. Question answering over freebase with multi-column convolutional neural networks[C]//Proceedings of ACL. Beijing, China:ACL Press, 2015:260-269. http://www.researchgate.net/publication/301404590_Question_Answering_over_Freebase_with_Multi-Column_Convolutional_Neural_Networks

[66] FENG S, LIU S, YANG N, et al. Improving attention modeling with implicit distortion and fertility for machine translation[C]//Proceedings of COLING. Osaka, Japan:ACL Press, 2016:3082-3092.

[67] YAN Z, DUAN N, BAO J, et al. DocChat:an information retrieval approach for chatbot engines using unstructured documents[C]//Proceedings of ACL. Berlin, Germany:ACL Press, 2016:516-525. http://www.researchgate.net/publication/306093305_DocChat_An_Information_Retrieval_Approach_for_Chatbot_Engines_Using_Unstructured_Documents

[68] CHENG Y, XU W, HE Z, et al. Semi-supervised learning for neural machine translation[C]//Proceedings of ACL. Berlin, Germany:ACL Press, 2016:1965-1974. http://arxiv.org/abs/1606.04596

[69] LIN Y, SHEN S, LIU Z, et al. Neural relation extraction with selective attention over instances[C]//Proceedings of ACL. Berlin, Germany:ACL Press, 2016, 1:2124-2133. http://www.researchgate.net/publication/306093646_Neural_Relation_Extraction_with_Selective_Attention_over_Instances

[70] 刘知远, 孙茂松, 林衍凯, 等.知识表示学习研究进展[J].计算机研究与发展, 2016, 2:247-261. DOI: 10.7544/issn1000-1239.2016.20160020 LIU Zhi-yuan, SUN Mao-song, LIN Yan-kai, et al. Knowledge representation learning:a review[J]. Journal of Computer Research and Development, 2016, 2:247-261. DOI: 10.7544/issn1000-1239.2016.20160020

[71] LI P, ZHOU G. Joint argument inference in Chinese event extraction with argument consistency and event relevance[J]. IEEE/ACM Transactions on Audio, Speech, and Language Processing, 2016, 24(4):612-622. DOI: 10.1109/TASLP.2015.2497148

[72] WANG Z, ZHANG Y, LEE S Y M, et al. A bilingual attention network for code-switched emotion prediction[C]//Proceedings of COLING. Osaka, Japan:ACL Press, 2016:1624-1634.

[73] GUO J, CHE W, WANG H, et al. Revisiting embedding features for simple semi-supervised learning[C]//Proceedings of EMNLP. Doha, Qatar:ACL Press, 2014:110-120. https://www.researchgate.net/publication/301404891_Revisiting_Embedding_Features_for_Simple_Semi-supervised_Learning

[74] LI X, ZHANG J, ZONG C. Towards zero unknown word in neural machine translation[C]//Proceedings of IJCAI. New York, USA:AAAI Press, 2016:2852-2858. http://dl.acm.org/citation.cfm?id=3061020

[75] PEI W, GE T, CHANG B. An effective neural network model for graph-based dependency parsing[C]//Proceedings of ACL. Beijing, China:ACL Press, 2015. https://www.researchgate.net/publication/283556656_An_Effective_Neural_Network_Model_for_Graph-based_Dependency_Parsing

[76] BAHDANAU D, CHO K, BENGIO Y. Neural machine translation by jointly learning to align and translate[C]//International Conference on Learning Representations. San Diego, California, USA:arXiv Press, 2015:1409.0473V7. http://www.oalib.com/paper/4068727

-

期刊类型引用(55)

1. 董志勇,邱瀚,陈泓运. 智慧高速系统中大语言模型的集成与应用研究. 中国交通信息化. 2024(S1): 67-71 .  百度学术

百度学术

2. 毛延生,王一航. 生成式预训练语言模型汉语语用能力的实证研究——以ChatGPT为例. 外国语言文学. 2024(06): 40-55+130+137 .  百度学术

百度学术

3. 黄涛,陈颖悦,陈玉明,曾念峰. 一种适用于卷积结构的非图像数据预处理方法. 河北师范大学学报(自然科学版). 2023(03): 232-238 .  百度学术

百度学术

4. 李振宇,方天宇,关龙艳. 终身教育背景下新一代信息技术在开放大学教学平台的应用研究. 互联网周刊. 2023(20): 24-26 .  百度学术

百度学术

5. 颜戚冰,周先春,昝明远,王博文,张杰. 基于残差连接的并行网络去噪. 计算机与数字工程. 2023(09): 2103-2108 .  百度学术

百度学术

6. 陈亚敏,程露颖,郑卿勇,张艳,张玉琴,田金徽. 人工智能与神经科学研究主题分析. 兰州大学学报(医学版). 2022(03): 59-65 .  百度学术

百度学术

7. 闫宗一,任德均,李鑫,任秋霖,曹林杰. 基于B/S架构的图像处理深度学习平台设计. 现代电子技术. 2022(16): 60-66 .  百度学术

百度学术

8. 李启行,廖薇,孟静雯. 基于注意力机制的双通道DAC-RNN文本分类模型. 计算机工程与应用. 2022(16): 157-163 .  百度学术

百度学术

9. 雒续源. 移动互联网视域下的传统文化馆数字化转型探讨. 文化创新比较研究. 2022(21): 112-115 .  百度学术

百度学术

10. 陈秀明,储天启,王先传. 基于LSTM-CNN-Attention的新闻分类研究. 阜阳师范大学学报(自然科学版). 2022(04): 62-69 .  百度学术

百度学术

11. ZHANG Zhimin,YIN Rui,NING Huansheng. Internet of Brain, Thought, Thinking, and Creation. Chinese Journal of Electronics. 2022(06): 1025-1042 .  必应学术

必应学术

12. 朱福勇,龙依雯,王凯. 基于诉讼风险分析的智能推理应用探究. 重庆邮电大学学报(社会科学版). 2021(01): 73-83 .  百度学术

百度学术

13. 潘志倩. 基于树莓派的智能“魔镜”设计. 电子技术应用. 2021(02): 45-48 .  百度学术

百度学术

14. 顾星海,鲍劲松,吕超凡. 基于知识图谱的装配语义信息建模. 航空制造技术. 2021(04): 74-81 .  百度学术

百度学术

15. 王县县,禹龙,田生伟,王瑞锦. 独立RNN和胶囊网络的维吾尔语事件缺失元素填充. 自动化学报. 2021(04): 903-912 .  百度学术

百度学术

16. 喻超,孙健武,高军波. 从政府公开信息看脱贫攻坚与乡村振兴有机衔接——基于河南省53个贫困县的大数据分析. 信阳师范学院学报(哲学社会科学版). 2021(04): 38-44 .  百度学术

百度学术

17. 刘炜. 堆叠式非对称深度自编码器检测网络入侵. 控制工程. 2021(09): 1879-1885 .  百度学术

百度学术

18. 赵磊,高联丽,宋井宽. 面向视觉对话的自适应视觉记忆网络. 电子科技大学学报. 2021(05): 749-753 .  本站查看

本站查看

19. 李红,林珊,欧阳勇. 基于深度学习的自然语言处理课程教学探索与实践. 计算机教育. 2021(11): 147-151 .  百度学术

百度学术

20. 郭棚跃,刘振丙. 一种基于栈式压缩自编码的高光谱图像分类方法. 桂林电子科技大学学报. 2021(04): 298-304 .  百度学术

百度学术

21. 叶符明. 深度学习在自然语言处理NLP中的应用研究. 信息记录材料. 2021(11): 148-149 .  百度学术

百度学术

22. 刘家兵,林桂,倪渊,傅小龙. 基于文献挖掘局限期小细胞肺癌放疗热点的研究. 中华肿瘤防治杂志. 2021(21): 1660-1665 .  百度学术

百度学术

23. 王鹏,朱韦龙. 基于大数据的产品族本体造型意象挖掘方法研究. 图学学报. 2021(06): 1051-1060 .  百度学术

百度学术

24. 黄伍,龙文浩,刘铸,舒展,田文洪. 多维度智能心理测评系统. 计算机应用. 2021(S2): 192-197 .  百度学术

百度学术

25. 杨云,王全. 层聚合的对抗机器翻译模型的方法研究. 陕西科技大学学报. 2020(01): 164-170 .  百度学术

百度学术

26. 李国强,张露. 全卷积多并联残差神经网络. 小型微型计算机系统. 2020(01): 30-34 .  百度学术

百度学术

27. 姚红革,王诚,喻钧,白小军,李蔚. 复杂卫星图像中的小目标船舶识别. 遥感学报. 2020(02): 116-125 .  百度学术

百度学术

28. 熊回香,杨梦婷,李玉媛. 基于深度学习的信息组织与检索研究综述. 情报科学. 2020(03): 3-10 .  百度学术

百度学术

29. 张芳. 关于深度学习技术融合图书馆智慧服务平台研究. 知识经济. 2020(04): 139-140 .  百度学术

百度学术

30. 付聪,李六武,杨振国,刘文印. 基于自学习近邻图策略的短文本匹配方法. 计算机应用研究. 2020(06): 1697-1701 .  百度学术

百度学术

31. 王海涛,宋文,王辉. 一种基于LSTM和CNN混合模型的文本分类方法. 小型微型计算机系统. 2020(06): 1163-1168 .  百度学术

百度学术

32. 潘文浩,李金津,何必凯,赵守盈. 突发公共卫生事件中网络用户的情感与心理动态分析——以“新冠肺炎”事件为例. 传媒观察. 2020(07): 13-22 .  百度学术

百度学术

33. 魏宇,邢剑华. 自然语言处理视角下分散化政策情报信息量化研究——以1986-2018年旅游交通政策演进为例. 情报杂志. 2020(08): 16-23+121 .  百度学术

百度学术

34. 张云翔,李智诚. 面向电力行业的热词语音识别技术. 现代计算机. 2020(22): 14-17 .  百度学术

百度学术

35. 尹延鑫,李传富. 基于深度学习的用户健康词表构建方法研究. 医学信息学杂志. 2020(08): 29-33 .  百度学术

百度学术

36. 陈德意,张宏怡,刘彩玲,张光斌. 基于关键词策略和CNN的中文文本有害信息分类. 集美大学学报(自然科学版). 2020(05): 392-400 .  百度学术

百度学术

37. 黎谦. “互联网+”背景下语言文字信息处理技术与应用发展现状研究. 电脑知识与技术. 2020(30): 194-195+201 .  百度学术

百度学术

38. 马郅斌. 自然语言处理中的深度学习:方法及应用. 科技传播. 2020(21): 128-130 .  百度学术

百度学术

39. 许杰,朱超越,毕成,吴琴,陈潘霞. 基于LSTM和CNN文本分类模型实现配网作业智能风险评估. 现代信息科技. 2020(18): 153-156+161 .  百度学术

百度学术

40. 韩志恒. 浅析深度学习在自然语言处理NLP中的应用. 电子元器件与信息技术. 2020(11): 46-47 .  百度学术

百度学术

41. 钟明亮. 类案检索机制研究——以类案识别技术在审判中的应用为视角. 黑龙江省政法管理干部学院学报. 2019(01): 127-132 .  百度学术

百度学术

42. 方明之. 自然语言处理技术发展与未来. 科技传播. 2019(06): 143-144 .  百度学术

百度学术

43. 薛源. 基于深度学习算法的中文分词的研究. 计算机产品与流通. 2019(05): 200 .  百度学术

百度学术

44. 李猛,朱迎际,庄轶. 基于自然语言技术的内部审计风险预警框架构建与应用——以NJ银行授信业务为例. 中国内部审计. 2019(06): 4-9 .  百度学术

百度学术

45. 杨传春,张冰雪,李仁德,郭强. 基于LDA模型的网络刊物主题发现与聚类. 上海理工大学学报. 2019(03): 273-280+306 .  百度学术

百度学术

46. 刘京麦野,刘新,郭炳元,孙道秋. 基于循环神经网络的语义完整性分析. 计算机系统应用. 2019(09): 203-208 .  百度学术

百度学术

47. 冯雅兴,龚希,徐永洋,谢忠,蔡惠慧,吕霞. 基于岩石新鲜面图像与孪生卷积神经网络的岩性识别方法研究. 地理与地理信息科学. 2019(05): 89-94 .  百度学术

百度学术

48. 袁里驰. 利用语义信息的句法分析统计模型. 小型微型计算机系统. 2019(10): 2125-2129 .  百度学术

百度学术

49. 邓钰,雷航,李晓瑜,林奕欧. 用于目标情感分类的多跳注意力深度模型. 电子科技大学学报. 2019(05): 759-766 .  本站查看

本站查看

50. 彭静. 基于大数据分析的体育赞助营销效果评估方法研究. 福建体育科技. 2019(05): 4-7 .  百度学术

百度学术

51. 薛亚非. 面向自然语言处理的深度学习. 电子技术与软件工程. 2018(12): 144-145 .  百度学术

百度学术

52. 薛蕊,马小宁,李平,杨连报. 自然语言处理关键技术在智能铁路中的应用研究. 铁路计算机应用. 2018(10): 40-43+48 .  百度学术

百度学术

53. 姜浩然,周萍,杨肖光. 大众媒体视野下的“健康中国”——基于2016—2017年部分媒体报道的文本分析. 中国卫生政策研究. 2018(09): 76-82 .  百度学术

百度学术

54. 王丽芬,王珏,洪燕,娄亚兵,简晖,吕爱平,查青林. 融合脉诊信息的女性移动中医健康管理平台的研制. 世界科学技术-中医药现代化. 2018(10): 1803-1807 .  百度学术

百度学术

55. 史加荣,马媛媛. 深度学习的研究进展与发展. 计算机工程与应用. 2018(10): 1-10 .  百度学术

百度学术

其他类型引用(132)

ISSN

ISSN

下载:

下载: